機械学習における公平性

このコースでは、これまで、既存タスクで貴重な時間を節約することから新たな機会の扉を開くことまで、機械学習が仕事をどのように強化できるかを示してきました。機械学習には多くの利点がありますが、同時に見落としてはならない課題も付属しています。

これらの課題に対処するため、ますます多くの研究者や実践者が機械学習の「公平性」というトピックに焦点を当てています。指針となる原則は、私たちの生活を形づくり、私たちの生活に影響を与える社会的カテゴリーに関係なく、機械学習はすべての人に等しく利益をもたらすべきであるということです。

バイアスとは何ですか?

機械学習の使用から派生する可能性のある負の結果とは何ですか?シンプルな答えは、バイアスです。

人間として、私たちは皆バイアスを持っています。それは、毎日投げかけられる情報に対処するために脳が使用するツールです。

一つの例を取り上げましょう。目を閉じて靴を思い描いてください。おそらくスニーカーを思い描いたことでしょう。革の紳士靴だったかもしれません。女性用のハイヒールを思い浮かべた可能性はそれほど高くないでしょう。理由はわからなくても、私たちはそれぞれ、靴に対して他の靴よりもバイアスがあります。

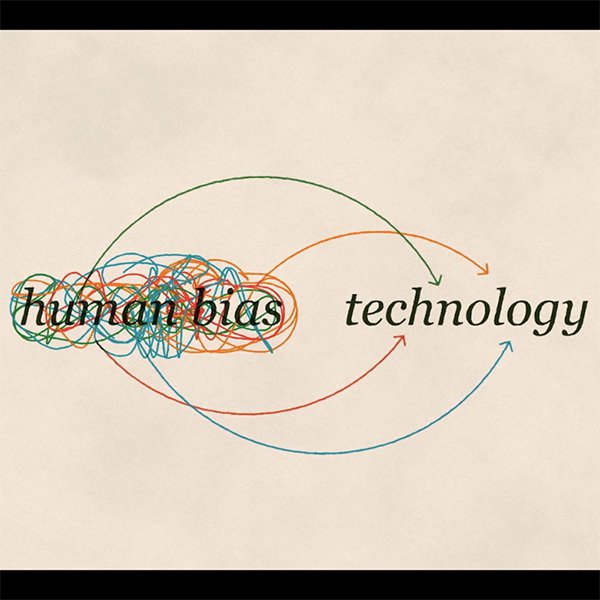

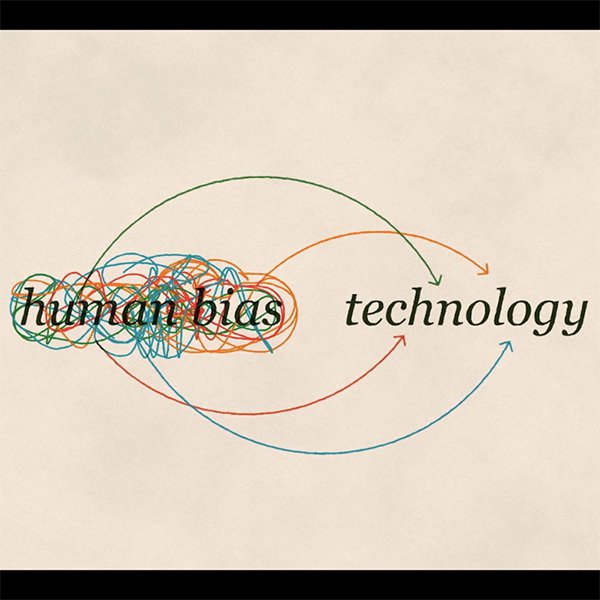

ここで、靴を認識するようにコンピューターに教えたいとします。すると、コンピューターを自分独自のバイアスにさらすことになります。このようにして、機械学習でバイアスが発生するのです。善意を持ってしても、自分自身から偏見を切り離すことは不可能です。

3種類のバイアス

さまざまな方法で、私たち自身の偏見が、私たちが作り出すテクノロジーの一部になるリスクがあります。

相互作用バイアス

前の例を考えましょう。スニーカーの写真が大半を占めるデータセットを使って靴を認識するようモデルを訓練する場合、システムはハイヒールを靴として認識することを学習しません。

潜在バイアス

過去の有名な科学者の写真を使って科学者の外見について機械学習システムをトレーニングする場合、アルゴリズムは科学者を男性だけに関連付けることを学習することでしょう。

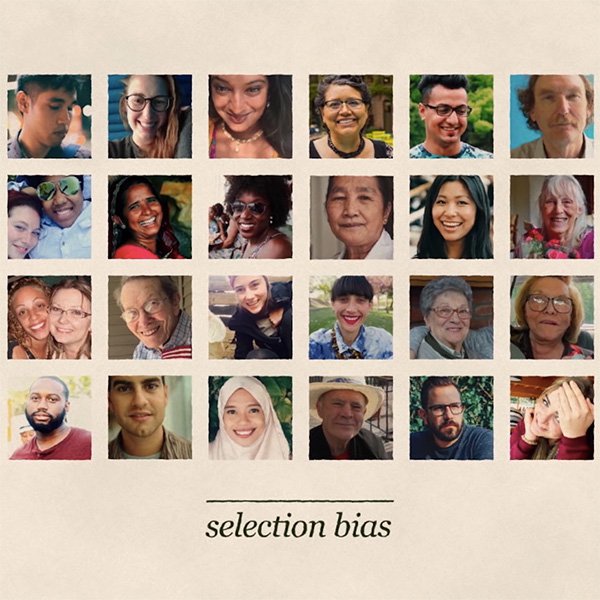

選択バイアス

顔を認識するようモデルをトレーニングするとしましょう。トレーニングに使用するデータが1つの母集団を過剰に示している場合、他者を犠牲にして彼らにより有利に機能することで、人種差別的な結果を招く可能性があります。

では、これらのバイアスを回避するために何ができるでしょうか?

バイアスを避けるために正しい質問をする

ジャーナリストとして、偏見に対する最前線の防衛は確実に手の届くところにあります。あなたが業務で毎日当てはめている、その同じ価値と倫理原則を、ツールボックスに追加される新しいテクノロジーの公平性の評価にまで拡張してください。機械学習も例外ではありません。

さらに、どんな場合でも、結果が個人の経済的または人生の他の重要な機会に悪影響を与える可能性があるかどうかを最初に検討する必要があります。使用するデータに個人の機密情報が含まれる場合、これは特に重要です。

多くの場合、不公正の影響はすぐには明らかになりませんが、機械学習システムがバイアスを忍び込ませる方法について、微妙な社会的、政治的、倫理的な質問を考慮する必要があります。

バイアスの主な原因を考慮する

完全に「バイアスのない」トレーニングデータはありませんが、データの潜在的バイアスの原因を慎重に検討し、それらに対処する手段を講じることで、公正なモデル構築の可能性を大幅に向上させることができます。

バイアスが忍び寄る最も一般的な理由は、トレーニングデータが、モデルが予測しようとしている母集団を正確に表していない場合です。関連する各グループに十分なデータがあることを確認する必要があります。

トレーニングデータ内で一部のグループが他のグループよりも肯定的に表現されない場合、別の種類のバイアスが現れています。データにより、アルゴリズムが学習および再現する可能性のある偏見が持ち込まれるかどうかを確認するため、データを使用してモデルをトレーニングする前に、データの確認を検討してください。

バイアスの防止は認識することから始まる

バイアスはさまざまな方法で - トレーニングデータセットから、機械学習システムの開発中に下される決定のために、そして機械学習システムを現実世界に導入するときに生じる複雑なフィードバックループを通して - 現れる可能性があります。

潜在的なバイアスを認識するために自問できる具体的な質問には次のものがあります。

- データはどんな目的で収集されましたか?

- データはどのように収集されましたか?

- このデータセットとこの特定のアルゴリズムを使用する目的は何ですか?

- データのソースはどのように評価されましたか?

- データ分析のプロセスは、分析自体の前にどのように定義されましたか?

バイアスは複雑な問題であり、特効薬はありません。解決策の第一歩は、認識から始まり、私たち全員がリスクに留意し、それを最小限に抑えるための適切な措置を講じることです。