الإنصاف في التعلم الآلي

حتى الآن، أظهرت هذه الدورة كيف يمكن للتعلم الآلي تعزيز عملك، من توفير الوقت الثمين على المهام الحالية إلى توفير فرص جديدة. يمكن أن يقدم التعلم الآلي الكثير من أجلك، ولكنه يأتي مع تحديات لا يجب تجاهلها.

لمواجهة هذه التحديات، يركز عدد متزايد من الباحثين والممارسين على موضوع "الإنصاف" في التعلم الآلي. حيث يتركز مبدأه الإرشادي على أن يكون التعلم الآلي مفيدًا للجميع على حدٍ سواء، بصرف النظر عن الفئات المجتمعية التي تشكل وتؤثر في حياتنا.

ما هو التحيز؟

ما هي العواقب السلبية التي قد تنجم عن استخدام التعلم الآلي؟ الإجابة القصيرة هي: التحيز.

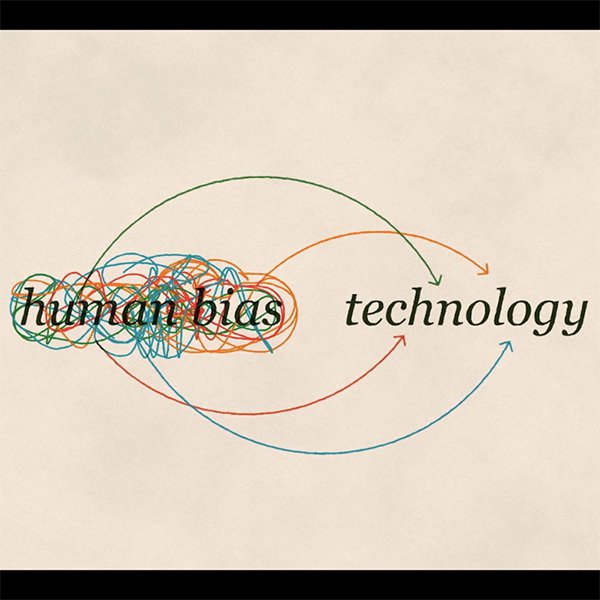

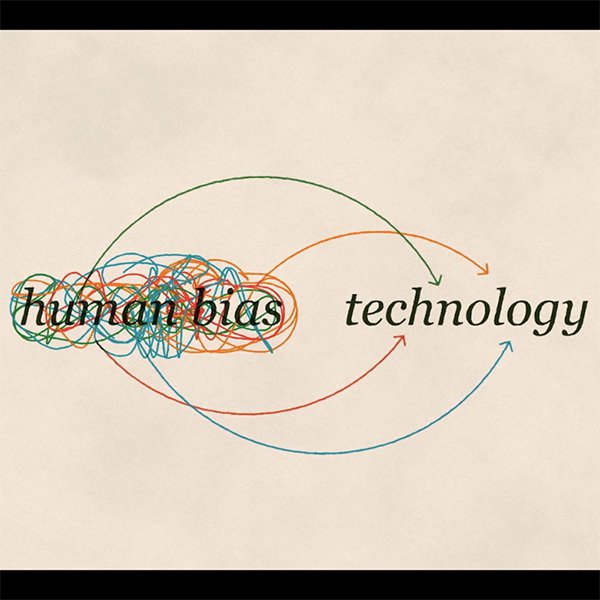

كبشر، لدينا جميعًا تحيزاتنا. إنها أدوات يستخدمها العقل للتعامل مع المعلومات التي يتم إلقاؤها عليه كل يوم.

إليك هذا المثال: أغمض عينيك وصور حذاءًا. على الأرجح صورت حذاءً رياضيًا. ربما حذاءً جلديا للرجال. من غير المحتمل أنك فكرت في حذاء نسائي بكعب عال. قد لا نعرف حتى السبب، لكن كل واحد منا ينحاز نحو حذاء على حساب الآخر.

والآن تخيل أنك تريد تعليم الحاسب الآلي التعرف على الحذاء. قد ينتهي بك الأمر بتعريضه لتحيزك. هكذا يحدث التحيز في التعلم الآلي. حتى مع النوايا الحسنة، من المستحيل فصل أنفسنا عن تحيزاتنا.

ثلاث أنواع من التحيز

هناك طرق مختلفة تخاطر بها انحيازاتنا الخاصة لتصبح جزءًا من التكنولوجيا التي نبتكرها:

انحياز التفاعل

خذ المثال السابق: إذا قمنا بتدريب نموذج للتعرف على الأحذية بمجموعة بيانات تتضمن في الغالب صورًا للأحذية الرياضية، فلن يتعلم النظام التعرف على الأحذية ذات الكعب العالي على أنها أحذية.

الانحياز الكامن

إذا قمت بتدريب نظام التعلم الآلي على ما يبدو عليه العالم باستخدام صور العلماء المشهورين من الماضي، فمن المحتمل أن تتعلم الخوارزمية ربط العلماء بالرجال فقط.

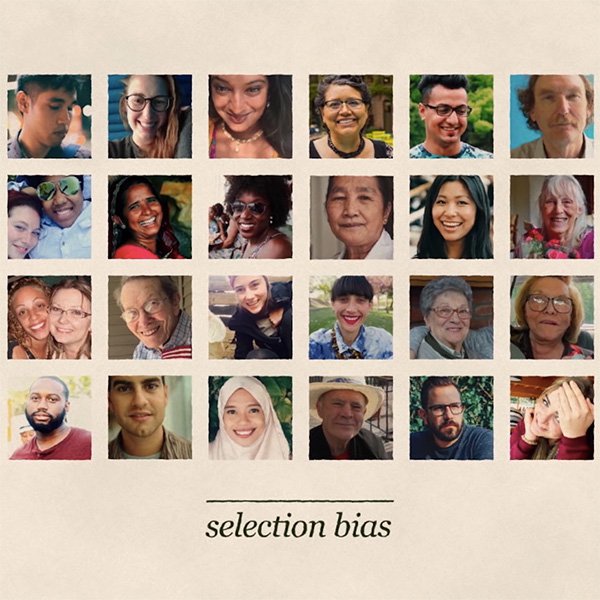

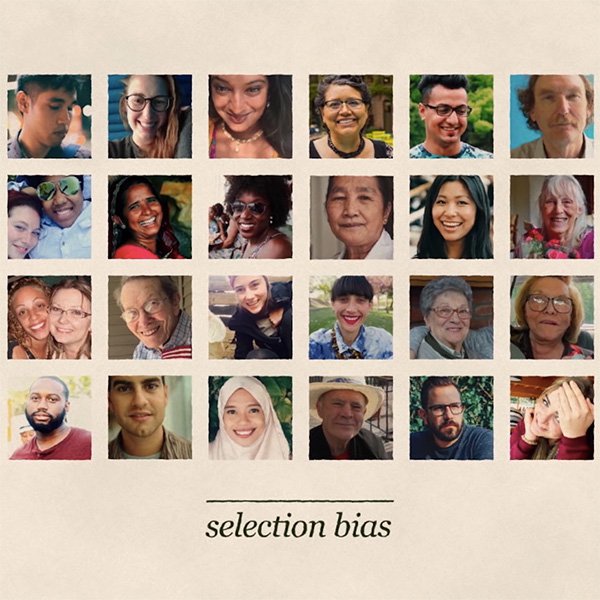

التحيز في الاختيار

لنفترض أنك تدرب نموذجًا للتعرف على الوجوه. إذا كانت البيانات التي تستخدمها لتدريب النموذج تمثل سكان منطقة واحدة، فستعمل بشكل أفضل بالنسبة لهم على حساب الآخرين، مع عواقب عنصرية محتملة.

إذن ما الذي يمكننا فعله لتجنب هذه التحيزات؟

طرح الأسئلة الصحيحة لتجنب التحيز

كصحفي، فإن خط الدفاع الأول ضد التحيز في متناول يدك بقوة: نفس القيم والمبادئ الأخلاقية التي تطبقها كل يوم في مهنتك يجب أن تمتد إلى تقييم إنصاف أي تقنية جديدة تضاف إلى صندوق أدواتك. والتعلم الآلي ليس استثناءً.

علاوةً على ذلك، في جميع الحالات يجب أن تبدأ بالنظر في ما إذا كانت العواقب قد تؤثر سلبًا على الفرص الاقتصادية للأفراد أو غيرها من فرص الحياة المهمة. هذا أمر بالغ الأهمية، خاصةً إذا كانت البيانات التي تستخدمها تتضمن معلومات شخصية حساسة.

غالبًا ما لا يكون التأثير غير المنصف واضحًا على الفور، ولكنه يتطلب طرح أسئلة اجتماعية وسياسية وأخلاقية دقيقة حول الكيفية التي قد يسمح بها نظام التعلم الآلي لديك بالتحيز.

التعمق في المصادر الرئيسية للتحيز

رغم أن أي بيانات تدريب لن تكون أبدًا "منحازة" تمامًا، يمكنك تحسين فرصك في إنشاء نموذج منصف إلى حد كبير إذا كنت تفكر بعناية في المصادر المحتملة للتحيز في بياناتك، وتتخذ خطوات لمعالجتها.

السبب الأكثر شيوعًا لوجود التحيز هو عندما لا تمثل بيانات التدريب الخاصة بك حقًا نفس النسبة الذي يقوم نموذجك بتوقعها. يجب التأكد من وجود بيانات كافية لكل مجموعة ذات صلة.

يظهر نوع مختلف من التحيز عندما تكون بعض المجموعات ممثلة بشكل أقل إيجابية من غيرها في بيانات التدريب. يجب أن تفكر في مراجعة بياناتك قبل استخدامها لتدريب نموذج ما، من أجل التحقق مما إذا كانت تحمل أي تحيزات يمكن تعلمها وإعادة إنتاجها بواسطة الخوارزمية.

منع التحيز يبدأ بالوعي

يمكن أن يظهر التحيز بطرق عديدة: من مجموعات بيانات التدريب، بسبب القرارات التي يتم اتخاذها أثناء تطوير نظام التعلم الآلي، ومن خلال حلقات التغذية الاسترجاعية المعقدة التي تنشأ عند نشر نظام التعلم الآلي في العالم الحقيقي.

تتضمن بعض الأسئلة المحددة التي قد ترغب في طرحها من أجل التعرف على التحيز المحتمل ما يلي:

- لأي غرض جمعت البيانات؟

- كيف جمعت البيانات؟

- ما الهدف من استخدام هذه المجموعة من البيانات وهذه الخوارزمية المحددة؟

- كيف تم تقييم مصدر البيانات؟

- كيف تم تعريف عملية تحليل البيانات قبل التحليل نفسه؟

التحيز قضية معقدة ولا يوجد حل نهائي لها. يبدأ الحل بالوعي ومع إدراكنا جميعًا للمخاطر واتخاذ الخطوات الصحيحة لتقليلها.

-

How to add them to your site

الدرسThere are two ways to add Web Stories to your site, regardless of the CMS you use to maintain it. Each approach is simple, intuitive, and poised to make Web Stories a vital part of your content strategy going forward. -

-