Viés algorítmico em Machine Learning

Compreender o que é o viés algorítmico do ML e como evitá-lo.

A imparcialidade no Machine Learning

Até agora, este curso mostrou como o machine learning pode melhorar o seu trabalho, desde economizar tempo nas tarefas existentes até abrir novas oportunidades. O ML pode fazer muito por você, mas vem com desafios que você não deveria ignorar.

Para enfrentar esses desafios, um número crescente de pesquisadores e profissionais concentram-se no tema da “imparcialidade” em machine learning. Seu princípio orientador é que o ML deve beneficiar igualmente a todos, independentemente das categorias sociais que estruturam e impactam as nossas vidas.

O que é o viés algorítmico (bias)?

Quais são as consequências negativas que podem derivar do uso do machine learning? A resposta breve é: Viés algorítmico (Bias).

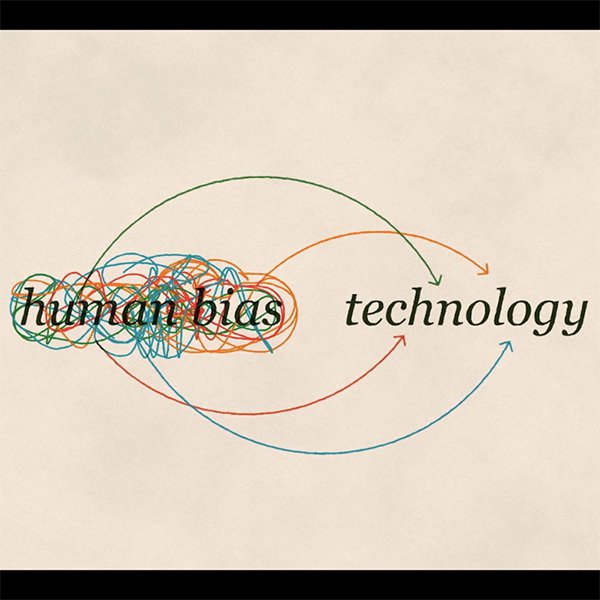

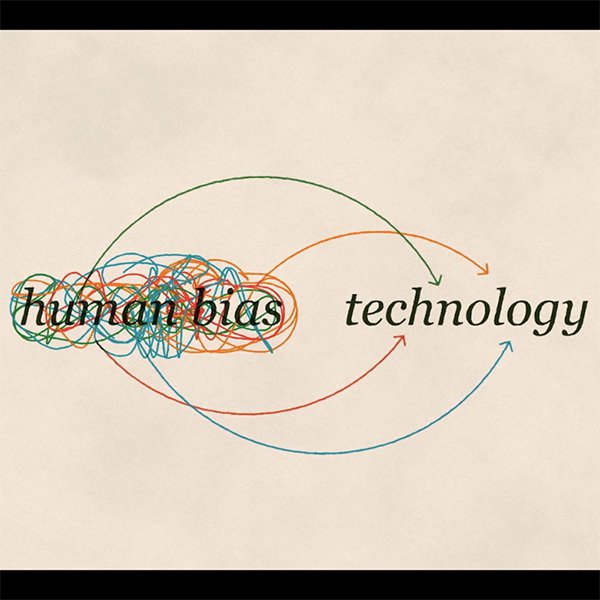

Como humanos, todo nós temos vieses. Eles são ferramentas que o nosso cérebro usa para lidar com as informações que recebe todos os dias.

Veja este exemplo: feche os seus olhos e imagine um sapato. Provavelmente você imaginou um tênis. Talvez um sapato masculino de couro. É menos provável que você tenha pensado em um sapato feminino de salto alto. Podemos nem saber por que, mas cada um de nós está predisposto a um sapato em detrimento dos demais.

Agora, imagine que você queira ensinar um computador a reconhecer um sapato. Você pode acabar expondo-o ao seu próprio viés. É assim que o viés algorítmico ocorre em machine learning. Mesmo com boas intenções, é impossível separar-nos dos nossos próprios vieses.

Três tipos de vieses

Há três formas diferentes nas quais os nossos vieses correm o risco de se tornarem parte da tecnologia que criamos:

Viés de interação

Veja o exemplo anterior: se treinamos um modelo para reconhecer sapatos com um conjunto de dados que inclui majoritariamente imagens de tênis, o sistema não aprenderá a reconhecer os saltos altos como sapatos.

Viés latente

Se você treinar um sistema de ML sobre como é um cientista usando fotos de cientistas famosos do passado, o seu algoritmo provavelmente aprenderá a associar os cientistas apenas a homens.

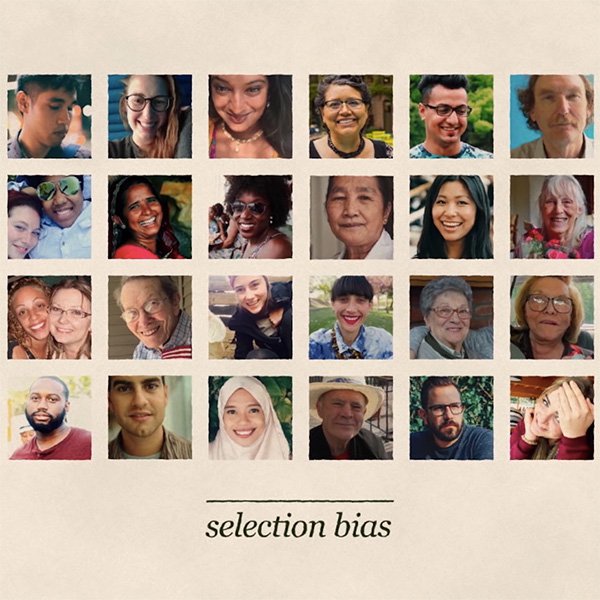

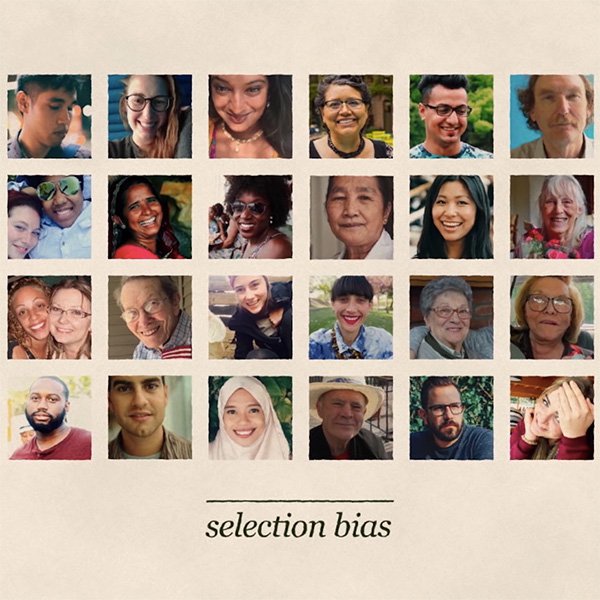

Viés de seleção

Digamos que você está treinando um modelo a reconhecer rostos. Se os dados que você usar para treinar sobrerrepresentarem uma população, ele operará melhor para eles em detrimento dos demais, com consequências potencialmente racistas.

Então o que podemos fazer para evitar esses vieses?

Formular as perguntas certas para evitar vieses

Como jornalista, uma primeira linha de defesa contra o viés está firmemente dentro do seu alcance: os mesmos valores e princípios éticos que você aplica todos os dias na sua profissão devem valer para avaliar a imparcialidade de qualquer nova tecnologia que é adicionada aos seus instrumentos de trabalho. O machine learning não é uma exceção.

Além disso, em todos os casos você devem começar considerando se as consequências podem impactar negativamente a economia ou outras oportunidades importantes da vida dos indivíduos. Isso é fundamental, especialmente se os dados que você usa incluem informações pessoais confidenciais.

Frequentemente, o impacto injusto não é imediatamente óbvio, mas requer formular perguntas de matizes sociais, políticos e éticos sobre como o sistema de machine learning pode propiciar que o viés comete erros.

Considerando as principais fontes de vieses

Embora nenhum dado de treinamento seja perfeitamente à prova de vieses, você pode melhorar significativamente suas chances de criar um modelo justo se considerar cuidadosamente as potenciais fontes de vieses nos seus dados, e tomar todas as medidas para enfrentá-las.

O motivo mais comum para os erros provocados por vieses é quando os seus dados de treinamento não representam verdadeiramente a população que o seu modelo está classificando. Você deve certificar-se de que possui dados suficientes para cada grupo relevante.

Um tipo diferente de viés se manifesta quando alguns grupos são representados de forma menos positivas do que outros nos dados de treinamento. Você deve considerar revisar os seus dados antes de usá-los para treinar um modelo, a fim de verificar se eles contêm algum preconceito que possa ser aprendido e reproduzido pelo algoritmo.

Prevendo o viés: começa com a conscientização

O viés pode surgir de várias formas: desde o conjunto de dados de treinamento, devido a decisões feitas durante o desenvolvimento de um sistema de machine learning, e através de recebimentos de feedback complexos que surgem quando um sistema de ML é implantado no mundo real.

Algumas perguntas concretas que você pode querer formular a fim de reconhecer o viés potencial incluem:

- Para qual finalidade os dados foram coletados?

- Como os dados foram coletados?

- Qual é o objetivo de usar este conjunto de dados e este algoritmo em particular?

- Como a fonte dos dados foi avaliada?

- Como foi definido o processo de análise dos dados antes da análise propriamente dita?

O viés é um problema complexo e não existe uma solução mágica. A solução começa com a conscientização e com todos nós sendo conscientes dos riscos e tomando as medidas corretas para minimizá-los.

-

Aumente seu tráfego com os produtos de pesquisa do Google

AulaAjude mais pessoas a encontrar suas notícias -

YouTube Creator Academy: Aprimorando suas habilidades no YouTube

AulaAprenda a acessar e escolher lições que ajudam a fortalecer sua presença. -

Google Fact Check Tools

AulaThese tools allow you to search for stories and images that have already been debunked and lets you add ClaimReview markup to your own fact checks.