Sesgos y aprendizaje automático

Comprenda qué son los sesgos en el aprendizaje automático y cómo evitarlos.

Equidad en el aprendizaje automatizado

Hasta el momento, este curso ha mostrado de qué modo el aprendizaje automático puede contribuir a su trabajo, desde ahorrarle tiempo dedicado a tareas existentes hasta abrirle nuevas oportunidades. El aprendizaje automático puede hacer mucho por usted, pero presenta ciertas dificultades que no se pueden obviar.

Para abordar tales dificultades, cada vez son más los investigadores y profesionales que se centran en el tema de la "equidad" en el aprendizaje automático. Su principio rector es que el aprendizaje automático debe beneficiar a todos por igual, con independencia de las categorías sociales que estructuren y afecten nuestras vidas.

¿Qué son los sesgos?

¿Qué efectos adversos puede tener el uso del aprendizaje automático? El tema se resume en una palabra: sesgos.

Como humanos, todos tenemos nuestras inclinaciones y estructuras mentales. Son herramientas que nuestro cerebro utiliza para procesar la información que le llega cada día.

Veamos este ejemplo: cierre los ojos y visualice un calzado. Lo más probable es que haya imaginado una zapatilla deportiva. Quizás un zapato de piel para hombres. Es menos probable que pensase en un zapato de mujer de tacón alto. Incluso sin saber por qué, cada uno de nosotros tiene tendencia a pensar en un tipo de calzado en lugar de pensar en otros.

Ahora suponga que quiere enseñar a un ordenador a reconocer un zapato. Puede acabar exponiéndolo a su propia parcialidad. Es así como pueden filtrarse sesgos en el aprendizaje automático. Incluso con la mejor de las intenciones, no nos es posible dejar de lado nuestras inclinaciones y parcialidades.

Existen tres tipos de parcialidad

Hay tres modos diferentes en que nuestros propios sesgos pueden colarse en la tecnología que creamos y alterar el resultado:

Parcialidad en la interacción

Veamos el ejemplo anterior: si entrenamos un modelo para que reconozca calzado con una serie de datos que mayoritariamente incluyan imágenes de zapatillas deportivas, el sistema no aprenderá a reconocer los zapatos de tacón alto como calzado.

Parcialidad latente

Si usted entrena un sistema de aprendizaje automático sobre el aspecto que tiene un científico utilizando imágenes de científicos famosos del pasado, es probable que su algoritmo solo asocie los científicos con los hombres.

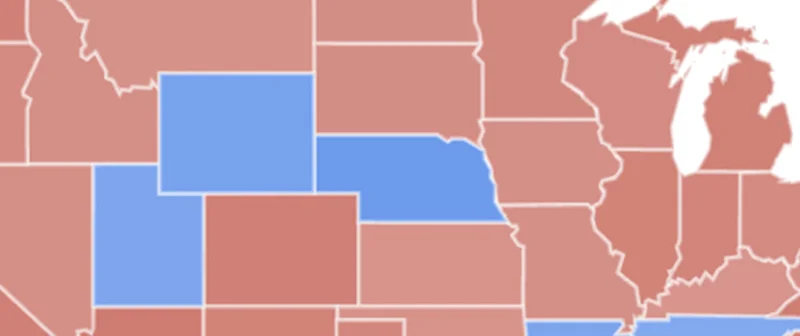

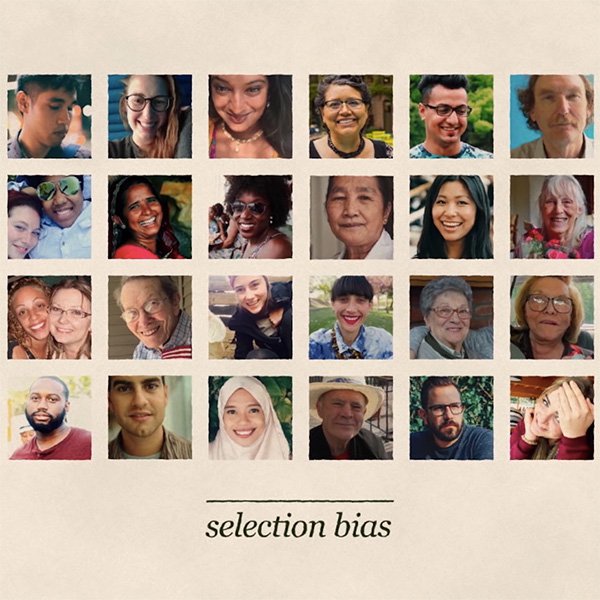

Parcialidad en la selección

Supongamos que está entrenando un modelo para reconocer caras. Si los datos que utiliza para entrenarlo representan excesivamente una población, funcionará mejor para esta población en detrimento de otras, lo que podría derivar en resultados racistas.

¿Qué podemos hacer para evitar estos sesgos?

Formular las preguntas adecuadas para evitar sesgos

Como periodista, tiene a su alcance una primera línea de defensa contra los sesgos: los mismos principios éticos y valores que usted aplica cada día en su profesión deben aplicarse al evaluar la equidad de cualquier nueva tecnología que se añada a su caja de herramientas. El aprendizaje automático no constituye la excepción.

En todos los casos, usted debe empezar por considerar si las consecuencias podrían afectar a las oportunidades económicas u otras oportunidades vitales de los individuos. Se trata de algo fundamental, especialmente si los datos que utiliza son información personal sensible.

A menudo, el impacto de la falta de equidad no es obvio de inmediato, sino que requiere preguntas matizadas de carácter social, político y ético sobre cómo su sistema de aprendizaje automático se vio afectado por sesgos.

Analizar las principales fuentes de sesgos

Si bien no será posible tener datos de entrenamiento perfectamente «imparciales», usted sí puede mejorar enormemente sus oportunidades de construir un modelo justo si analiza cuidadosamente las fuentes potenciales de sesgos en sus datos y adopta las medidas necesarias para evitarlos.

El motivo más común detrás de la parcialidad es cuando sus datos de entrenamiento no son auténticamente representativos de la población sobre la cual su modelo hace predicciones. Debe asegurarse de tener datos suficientes para cada grupo pertinente.

Una clase diferente de parcialidad se manifiesta cuando hay grupos que tienen una representación menos positiva que otros en los datos de entrenamiento. Piense en la posibilidad de revisar sus datos antes de utilizarlos para entrenar un modelo, para verificar si incluye prejuicios que el algoritmo pueda aprender y reproducir.

Evitar sesgos: comience con la concienciación

Los sesgos pueden deberse a muchas causas: datos de entrenamiento parciales, decisiones incorrectas adoptadas durante el desarrollo de un sistema de aprendizaje automático y complejos bucles de retroalimentación que surgen cuando un sistema de aprendizaje automático se despliega en el mundo real.

Entre las preguntas concretas que quizás usted quiera formular para reconocer estos riesgos potenciales se encuentran las siguientes:

- ¿Con qué finalidad se recopilaron los datos?

- ¿Cómo se recopilaron los datos?

- ¿Con qué objetivo se utiliza este conjunto de datos y este algoritmo en particular?

- ¿Cómo se evaluó el origen de los datos?

- ¿Cómo se definió el proceso de análisis de datos antes del propio análisis?

La parcialidad es una cuestión compleja y no existe ninguna solución mágica o perfecta. La solución empieza con la toma de conciencia y con todos nosotros teniendo presentes los riesgos y adoptando las medidas adecuadas para minimizarlos.

-

Advanced Google Trends

LecciónConviértete en un maestro de la herramienta Trends Explore con estos sencillos consejos para extraer datos precisos. -

-

Hojas de cálculo de Google: cómo eliminar datos

LecciónPrepara tus datos para su análisis y visualización.