Il bias nel Machine Learning

Che cosa si intende per bias nel Machine Learning e come evitarlo.

Il principio di equità nel Machine Learning

Finora, questo corso ha dimostrato come il Machine Learning possa migliorare il tuo lavoro, facendoti risparmiare tempo prezioso nello svolgimento di attività esistenti o aprendo nuove possibilità.Il ML può fare molto per te, ma comporta delle sfide che non dovresti prendere alla leggera.

Per affrontare queste sfide, un numero crescente di ricercatori e professionisti si sta concentrando sul tema dell'equità del Machine Learning. In base a questo principio, il ML deve giovare a tutti allo stesso modo, indipendentemente dalle categorie sociali che caratterizzano e influenzano la nostra vita.

Cosa si intende per bias?

Quali sono le conseguenze negative che potrebbero derivare dall'uso del Machine Learning? La risposta è: il bias ovvero la parzialità

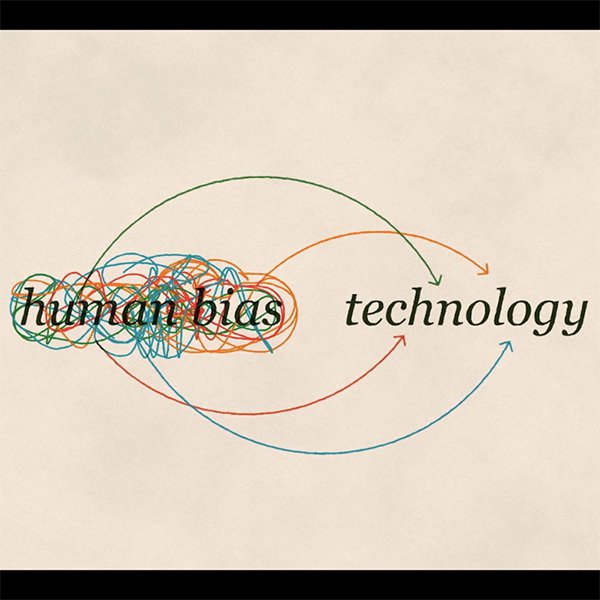

In qualità di esseri umani, ciascuno di noi ha i propri bias cognitivi. Si tratta di strumenti che il nostro cervello utilizza per elaborare le informazioni che gli vengono sottoposte ogni giorno.

Prendi questo esempio: chiudi gli occhi e immagina una scarpa . Molto probabilmente hai immaginato una sneaker. Forse una scarpa da uomo in pelle. È meno probabile che tu abbia pensato a una scarpa da donna con il tacco alto. Potremmo anche non sapere perché, ma ciascuno di noi è orientato verso una scarpa rispetto alle altre.

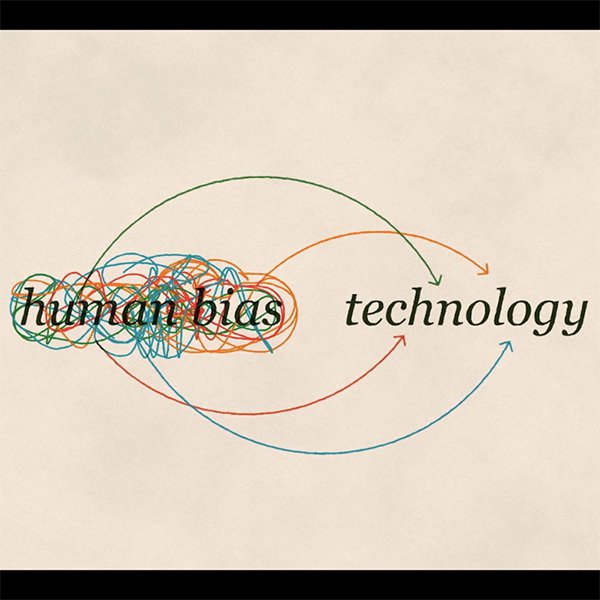

Ora immagina di voler insegnare a un computer a riconoscere una scarpa. Potresti finire per esporlo al tuo bias cognitivo, cioè alla tua idea di scarpa. Ecco come si verifica il bias nel Machine Learning. Anche con tutte le più buone intenzioni, è impossibile separarci dai nostri stessi bias cognitivi.

I tre tipi di bias

Esistono diversi modi in cui i nostri bias cognitivi, i nostri pregiudizi, rischiano di diventare parte della tecnologia che creiamo:

Bias d’interazione.

Prendiamo l'esempio appena fatto: se alleniamo un modello a riconoscere le scarpe con un dataset che include principalmente immagini di scarpe da ginnastica, il sistema non imparerà a riconoscere anche le calzature con i tacchi alti come scarpe.

Bias latente.

Se provi a insegnare a un modello di Machine Learning a riconoscere il profilo di uno scienziato utilizzando foto di scienziati famosi del passato, è probabile che il tuo algoritmo classifichi come scienziati solo gli uomini.

Bias selettivo.

Supponi di voler costruire un modello per il riconoscimento dei volti. Se i dati che stai usando per il training sovrarappresentano una parte di popolazione rispetto alla popolazione totale, il ML funzionerà meglio per quella porzione di popolazione a spese però delle altre categorie, con conseguenze potenzialmente razziste.

Quindi, cosa possiamo fare per evitare questi bias?

Porre le domande giuste per evitare il bias cognitivo

Come giornalista, c'è una prima contromisura per difendersi dal bias ed è decisamente alla tua portata: gli stessi valori e principi etici che applichi quotidianamente nella tua professione dovrebbero estendersi alla valutazione del corretto ed equo utilizzo di ogni nuova tecnologia che entra a far parte dei tuoi strumenti di lavoro. Il Machine Learning non fa eccezione.

Inoltre, in qualunque caso dovresti analizzare quali potrebbero essere le conseguenze negative capaci di intaccare le opportunità economiche o di vita delle singole persone. Ciò è fondamentale soprattutto se i dati che utilizzi includono informazioni personali sensibili.

Spesso, l'impatto iniquo non è immediatamente ovvio ma richiede porsi domande sulle sfumature sociali, politiche ed etiche per capire se il meccanismo di Machine Learning adottato potrebbe mai consentire ai bias di farsi strada.

Tenere presenti le principali fonti di bias

Sebbene nessun dato 'addestrato' sarà mai perfettamente imparziale, puoi migliorare notevolmente le tue possibilità di costruire un modello equo se consideri attentamente le potenziali fonti di bias nei tuoi dati e prendi provvedimenti per affrontarli.

La causa più comune di bias sia ha quando i dati che hai sottoposto al training non sono veramente rappresentativi della popolazione su cui il tuo modello sta basando l'analisi. È necessario assicurarsi di disporre di dati sufficienti per ciascun gruppo rappresentativo.

Un diverso tipo di bias si manifesta quando alcuni gruppi sono rappresentati in modo meno positivo di altri nei dati di addestramento. È necessario esaminare i dati prima di utilizzarli per formare un modello, al fine di verificare se ricalchino dei pregiudizi che potrebbero essere appresi e riprodotti dall'algoritmo.

Prevenire il bias: tutto parte dalla consapevolezza

Il bias può emergere in vari modi: dai dataset per il training, dalle scelte fatte durante lo sviluppo di un sistema di Machine Learning, oppure dai loop nei complessi sistemi di feedback che sorgono quando un sistema di ML viene diffuso nel mondo reale.

Tra le domande pratiche che potresti porre per riconoscere potenziali bias possiamo includere:

- Per quale scopo sono stati raccolti i dati?

- Come sono stati raccolti i dati?

- Qual è l'obiettivo che si prefigge l'utilizzo di questo dataset e di questo particolare algoritmo?

- Come è stata valutata la fonte dei dati?

- Come è stato definito il processo di analisi dei dati prima dell'analisi stessa?

ll bias è un problema complesso e non esiste per ora una ricetta magica per risolverlo. La soluzione inizia con la consapevolezza, ovvero tutti noi dobbiamo essere pienamente consapevoli dei rischi e compiere i passi giusti per minimizzarli.

-

-

Scopri di più sul tuo pubblico con i sondaggi

LezioneUsa i sondaggi per comprendere il pubblico, le sue abitudini e ciò a cui dà valore -