Avaliação e teste

Como interpretar o resultado do seu modelo e avaliar seu desempenho

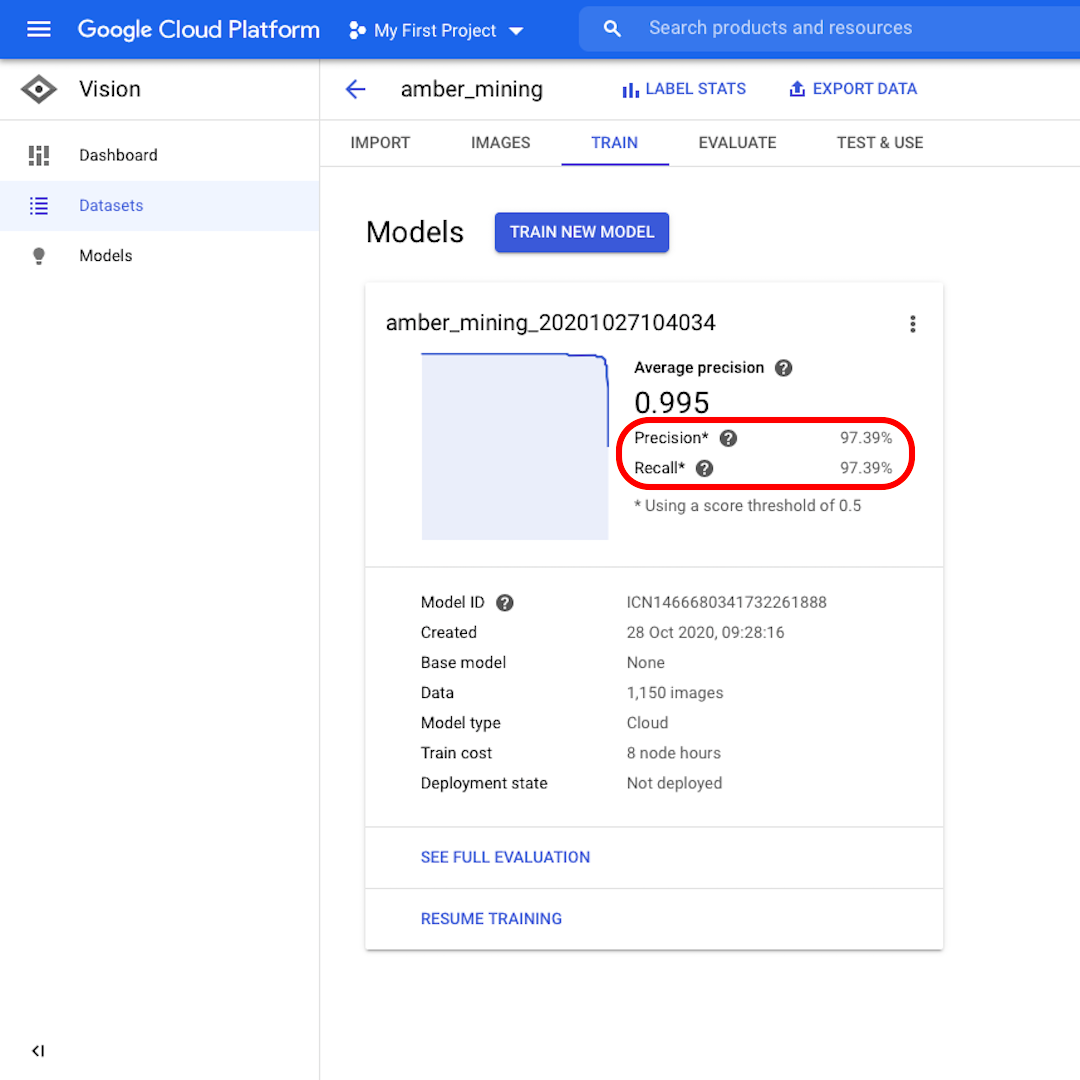

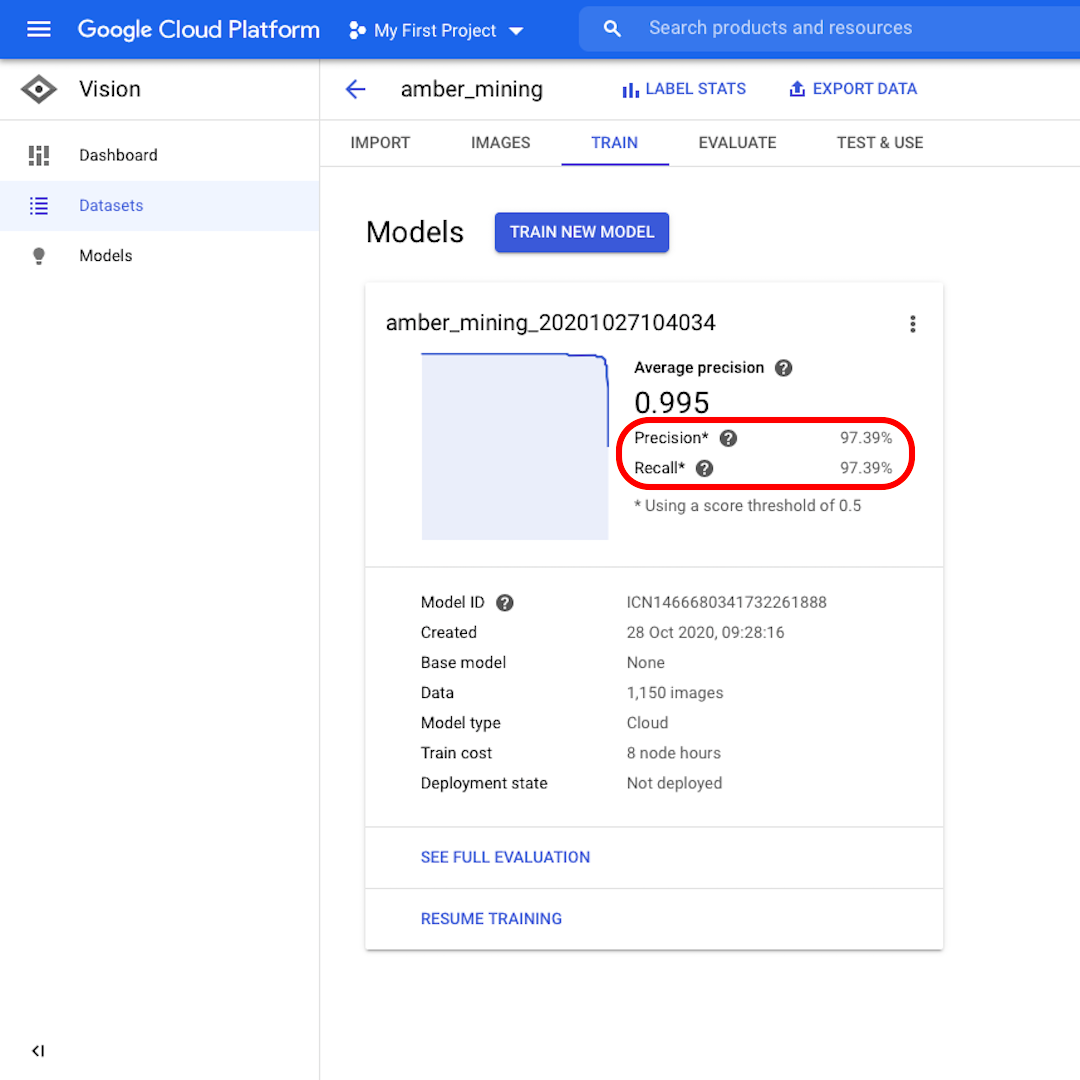

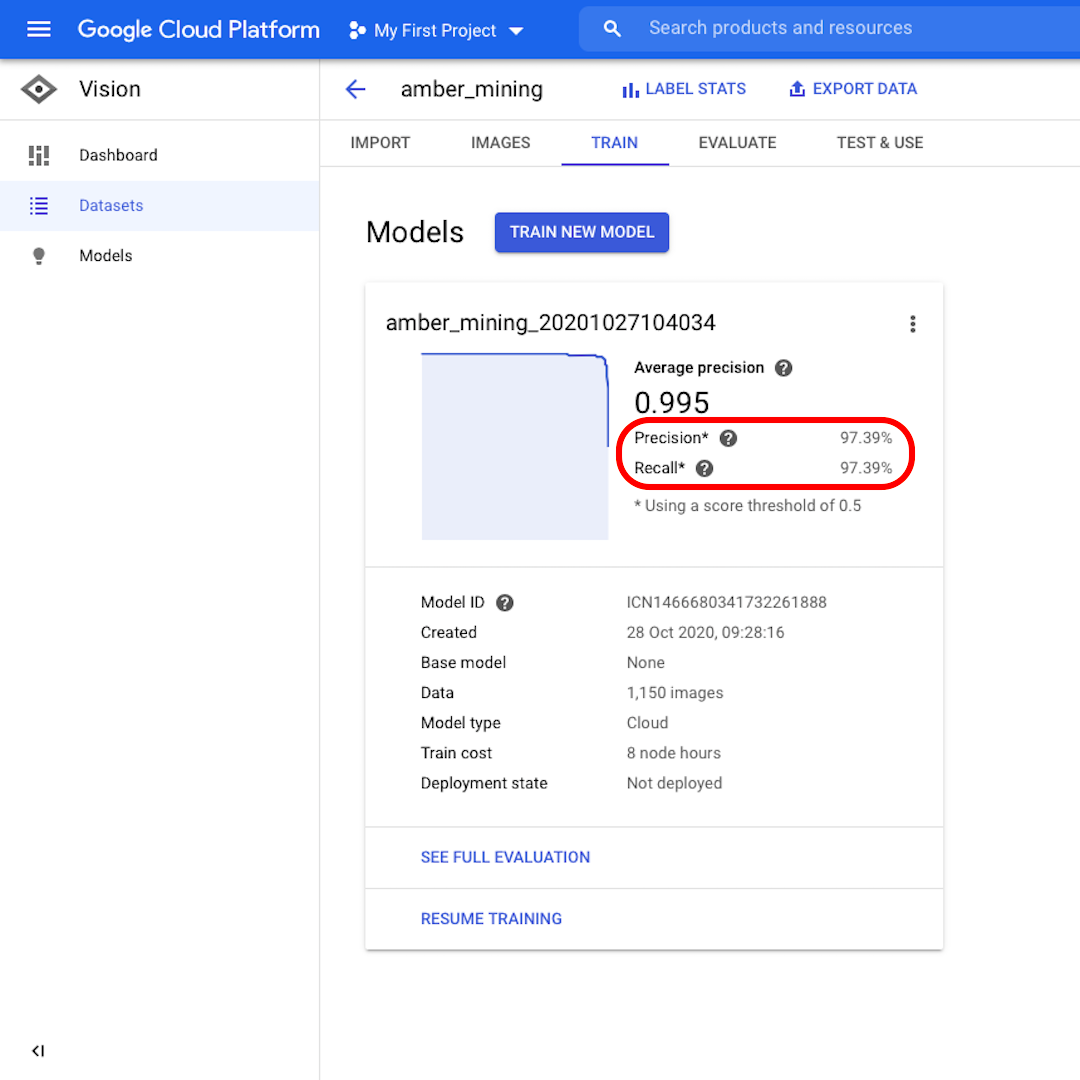

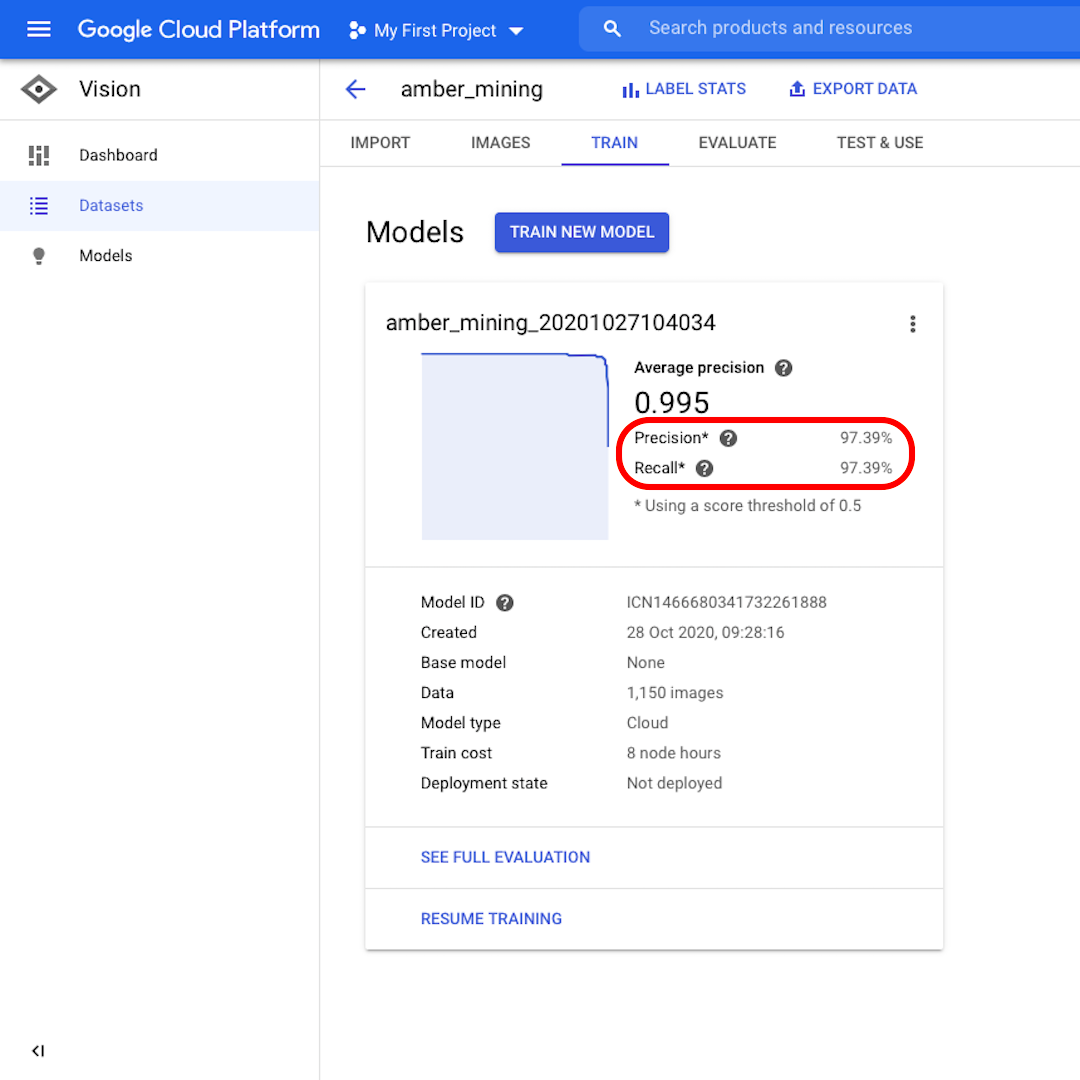

Precisão e recall

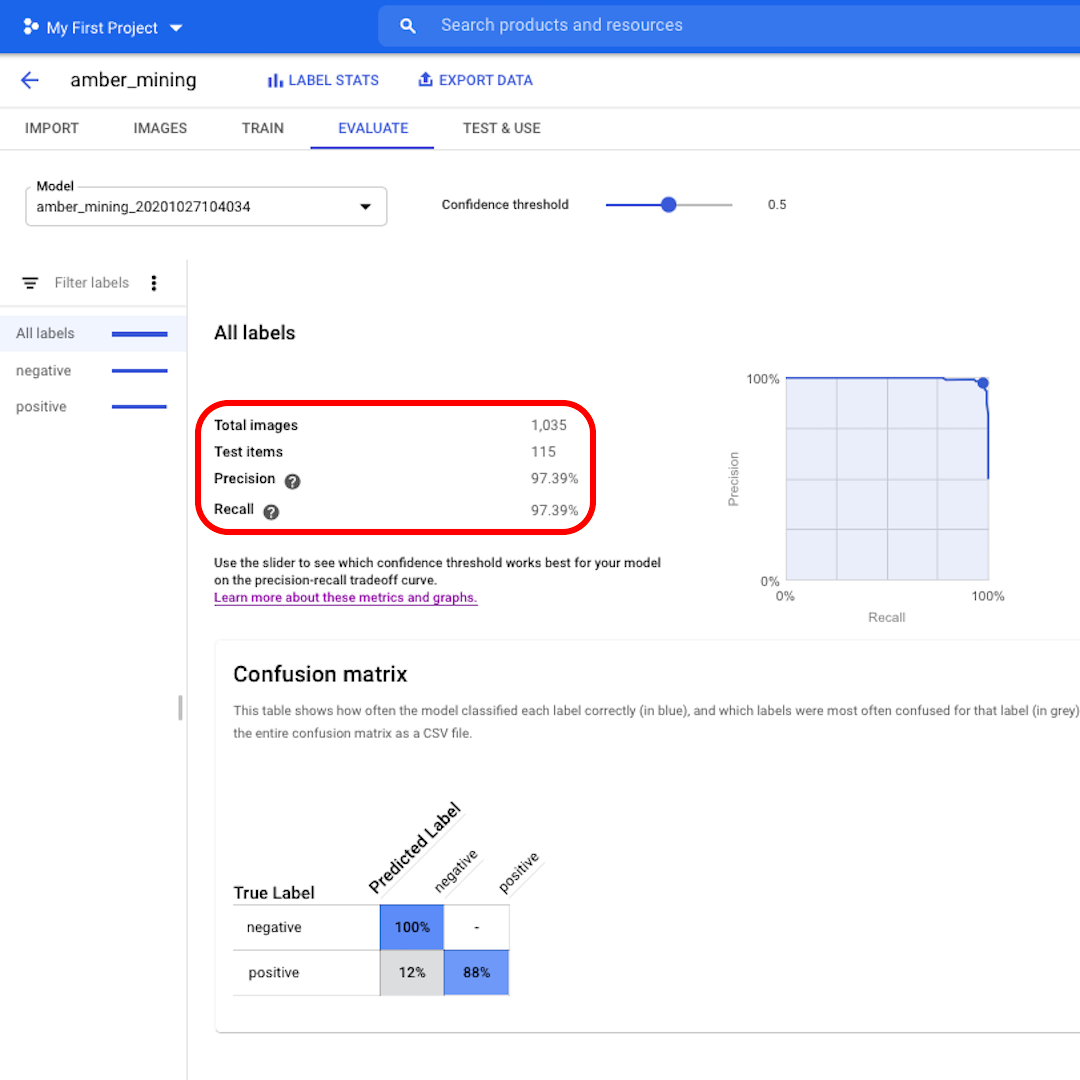

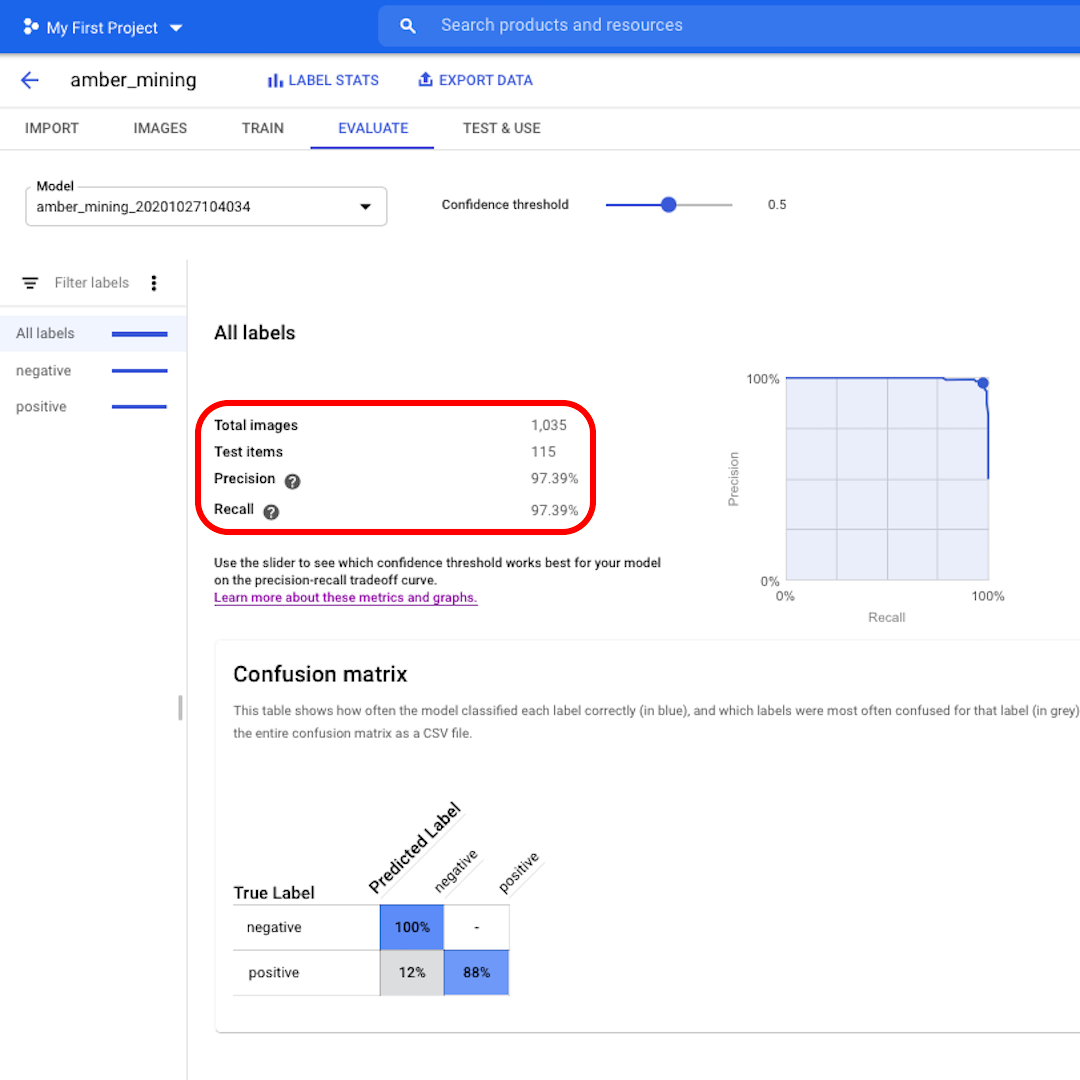

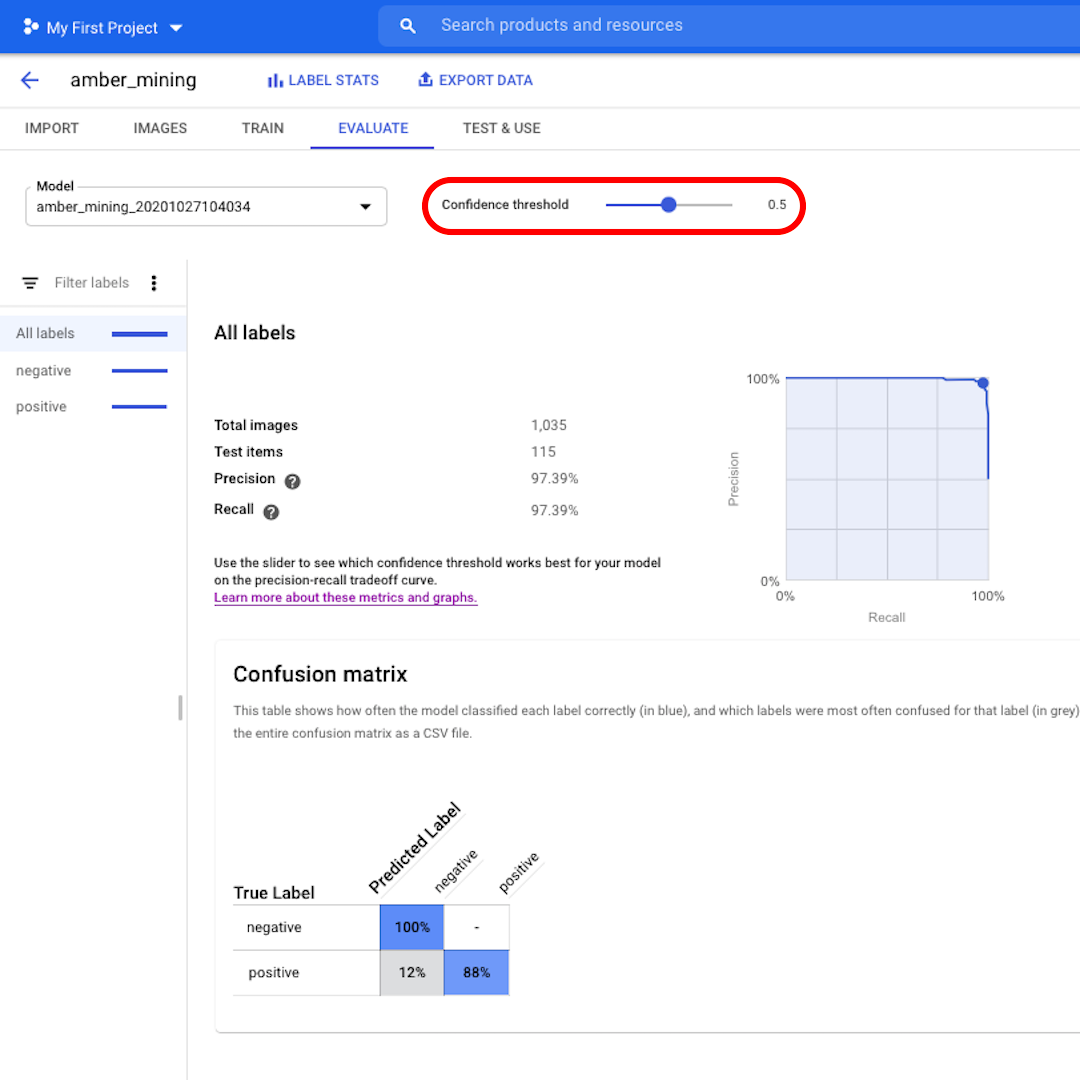

Quando o modelo estiver treinado, vocês visualizarão um resumo de seu desempenho com pontuações para “Precisão” e “Recall”.

A precisão nos informa qual proporção das imagens identificadas como positivas pelo modelo deveria efetivamente ter sido categorizada como tal. O recall, por sua vez, informa qual proporção de imagens positivas foi identificada corretamente.

Nosso modelo obteve bom desempenho em ambas as categorias, com pontuações acima de 97%. Vamos ver o que isso significa com mais detalhes.

Avalie o desempenho do modelo

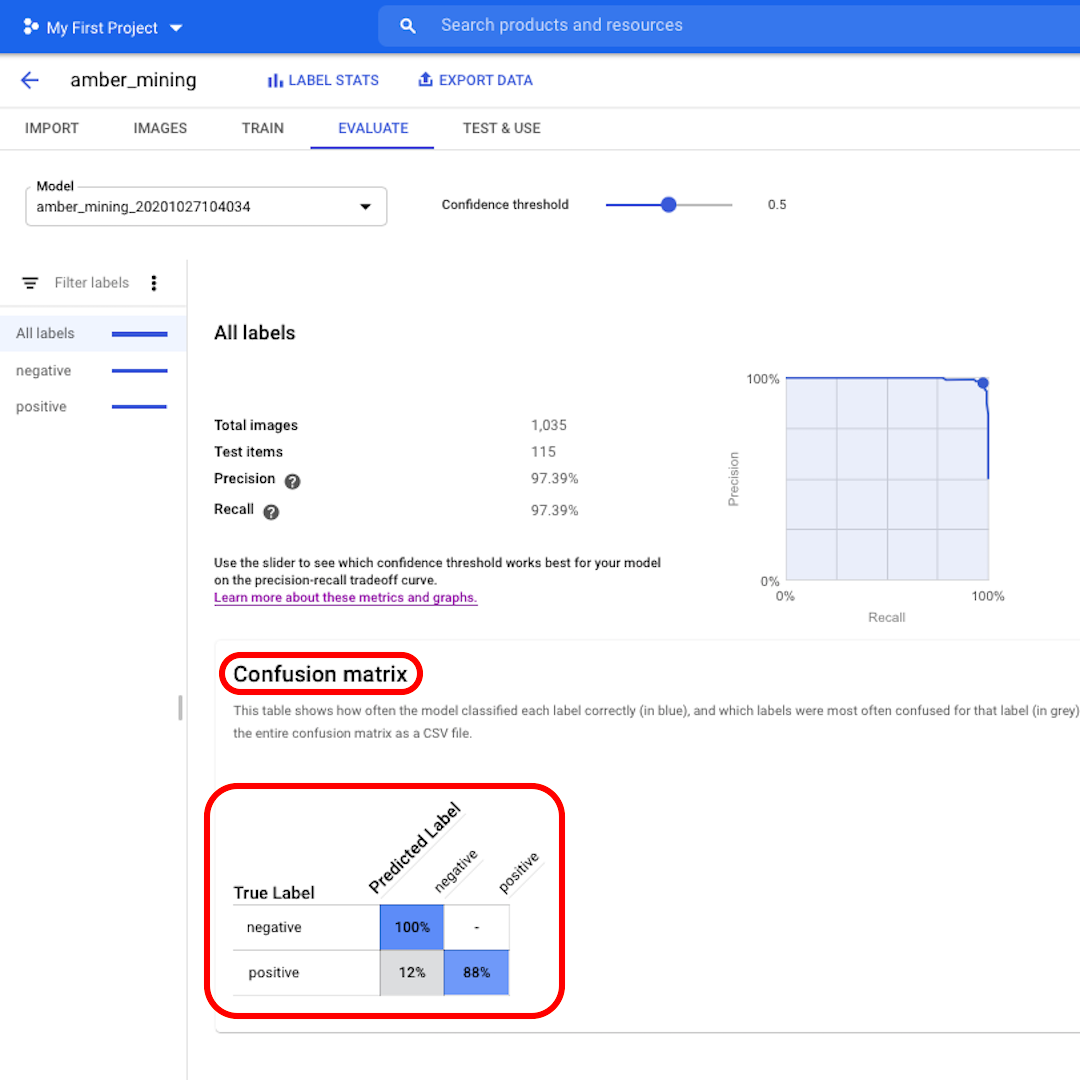

Cliquem em “Avaliar”, no topo do menu, para explorarmos a interface. Primeiro, ela nos mostra novamente as pontuações de precisão e recall. Em nosso caso, a pontuação de precisão nos informa que 97% das imagens do teste que o modelo identificou como exemplos de mineração de âmbar efetivamente mostravam indícios dessa atividade.

A pontuação de recall, por sua vez, informa que 97% das imagens do teste que mostravam exemplos de mineração de âmbar foram corretamente rotuladas como tal pelo modelo.

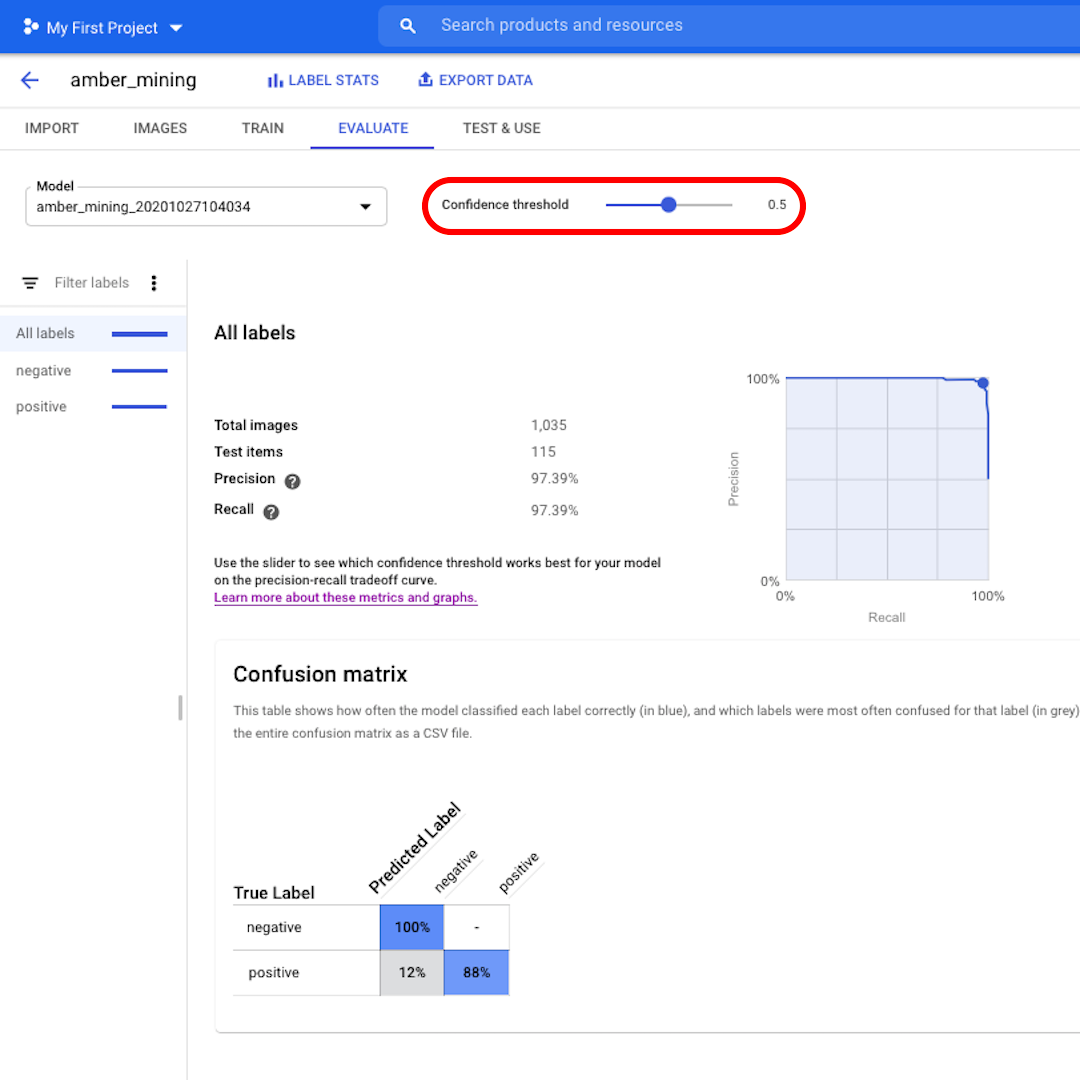

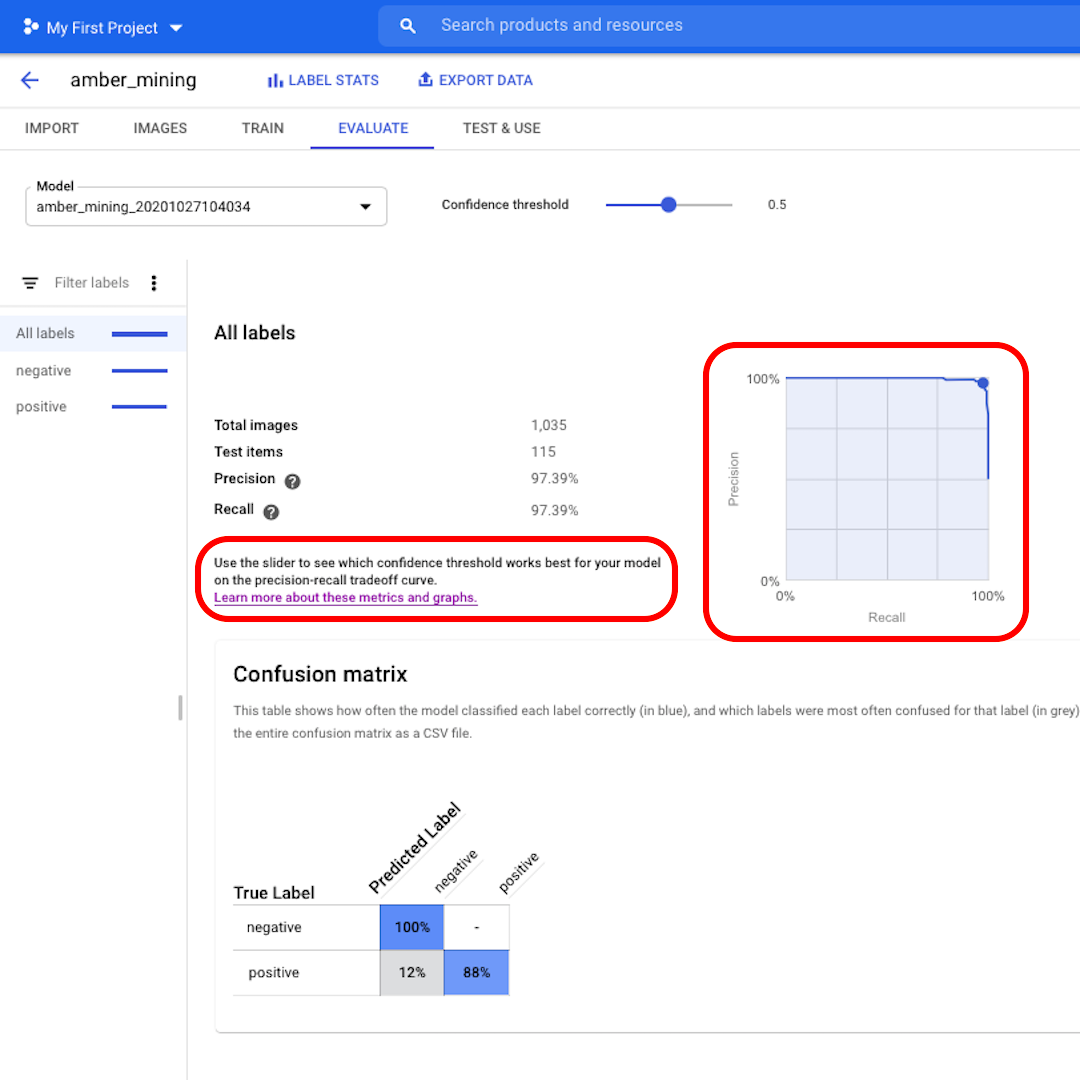

O limite de confiança representa o nível de confiança que o modelo deve possuir para atribuir um rótulo. Quanto menor ele for, mais imagens serão classificadas pelo modelo, mas maior será o risco de classificar algumas imagens incorretamente.

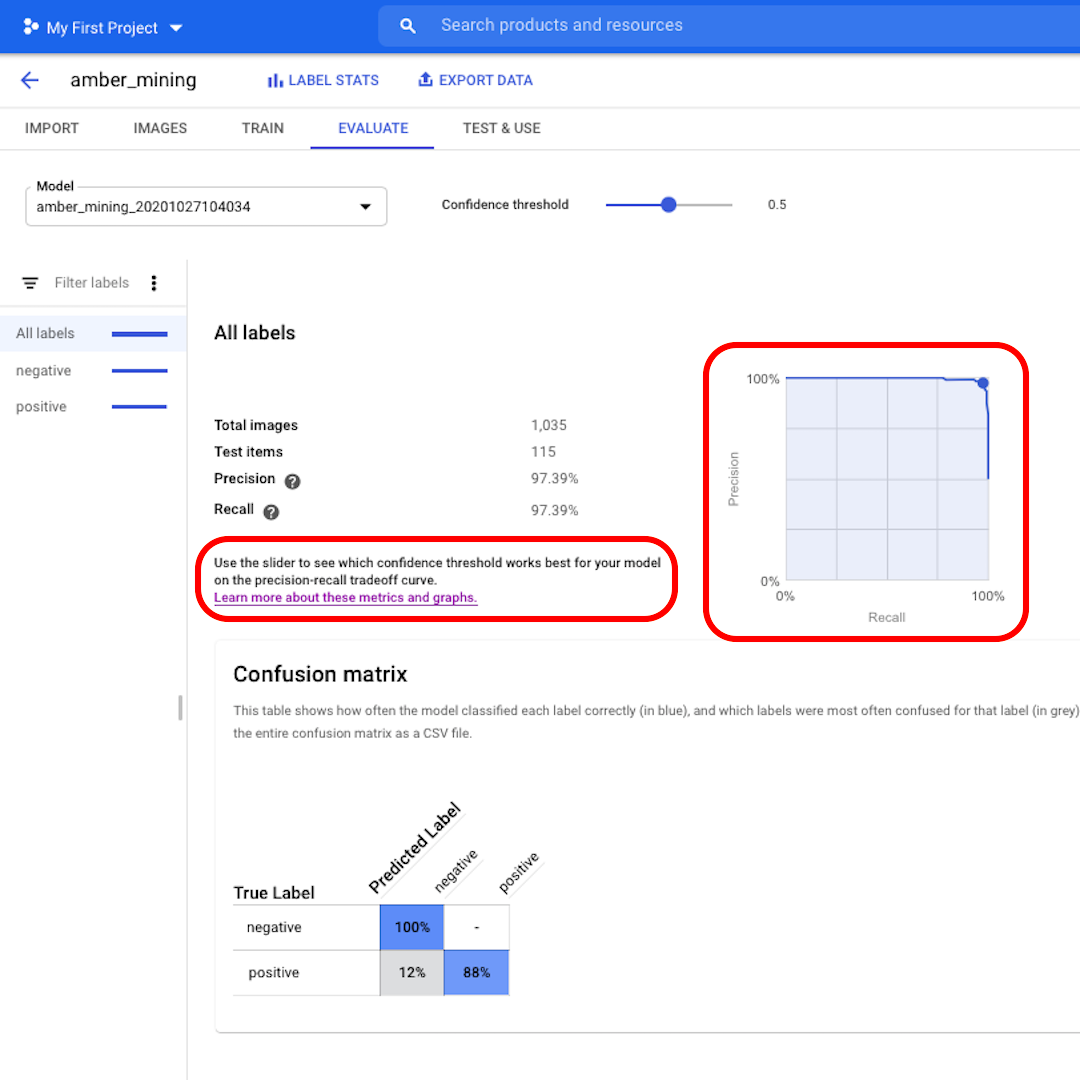

Se vocês quiserem se aprofundar no assunto e explorar as curvas de precisão-recall, cliquem no link da interface para saber mais.

Falsos positivos e falsos negativos

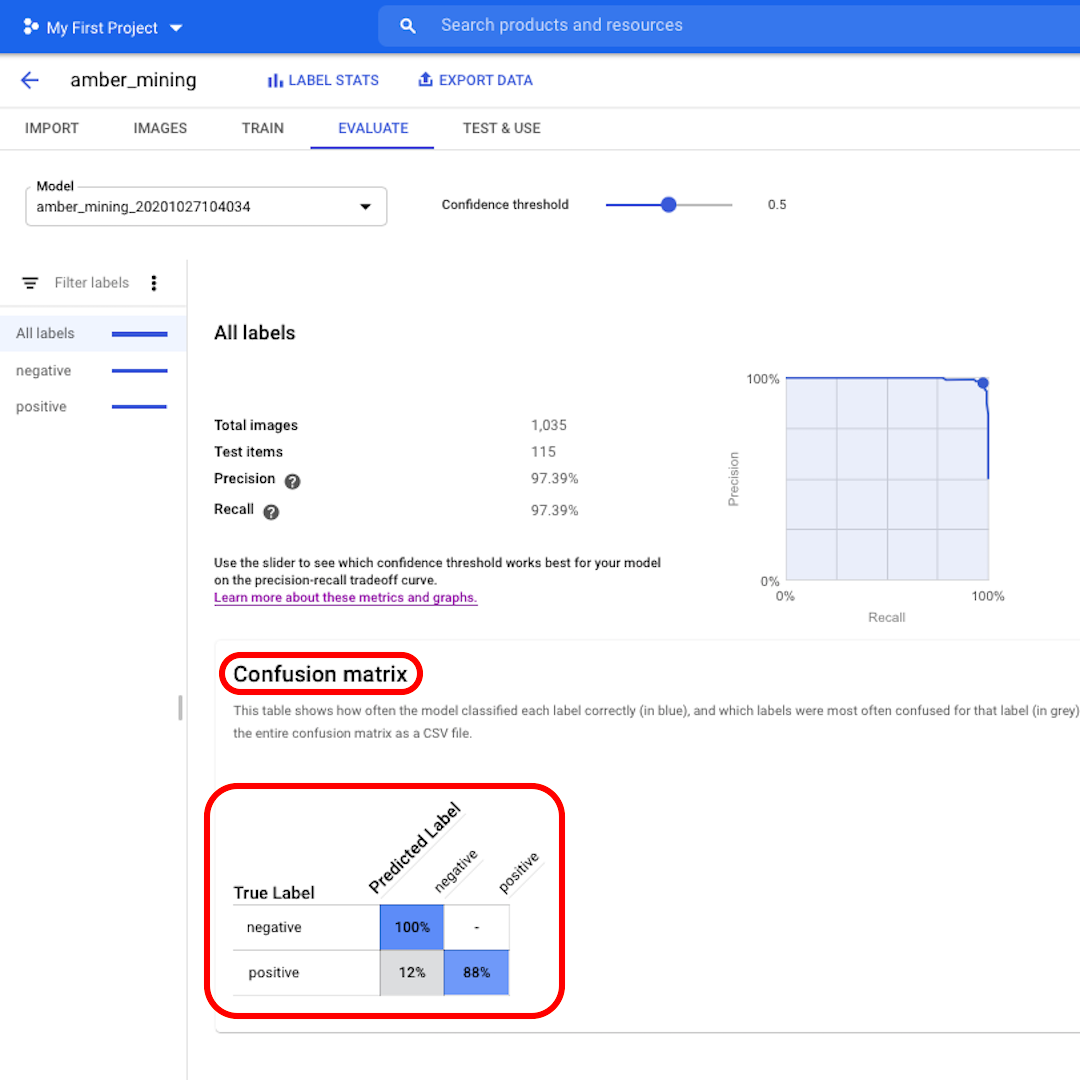

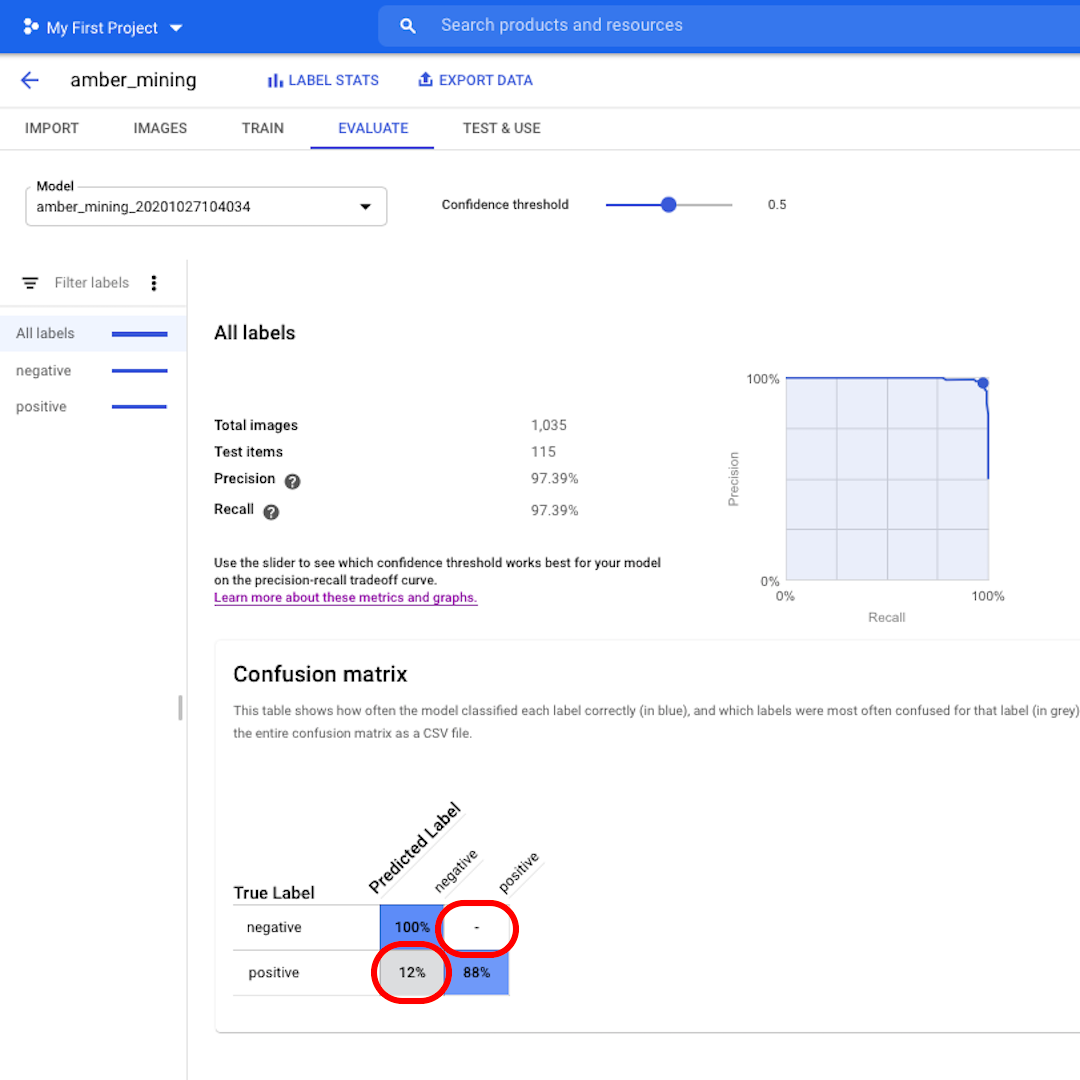

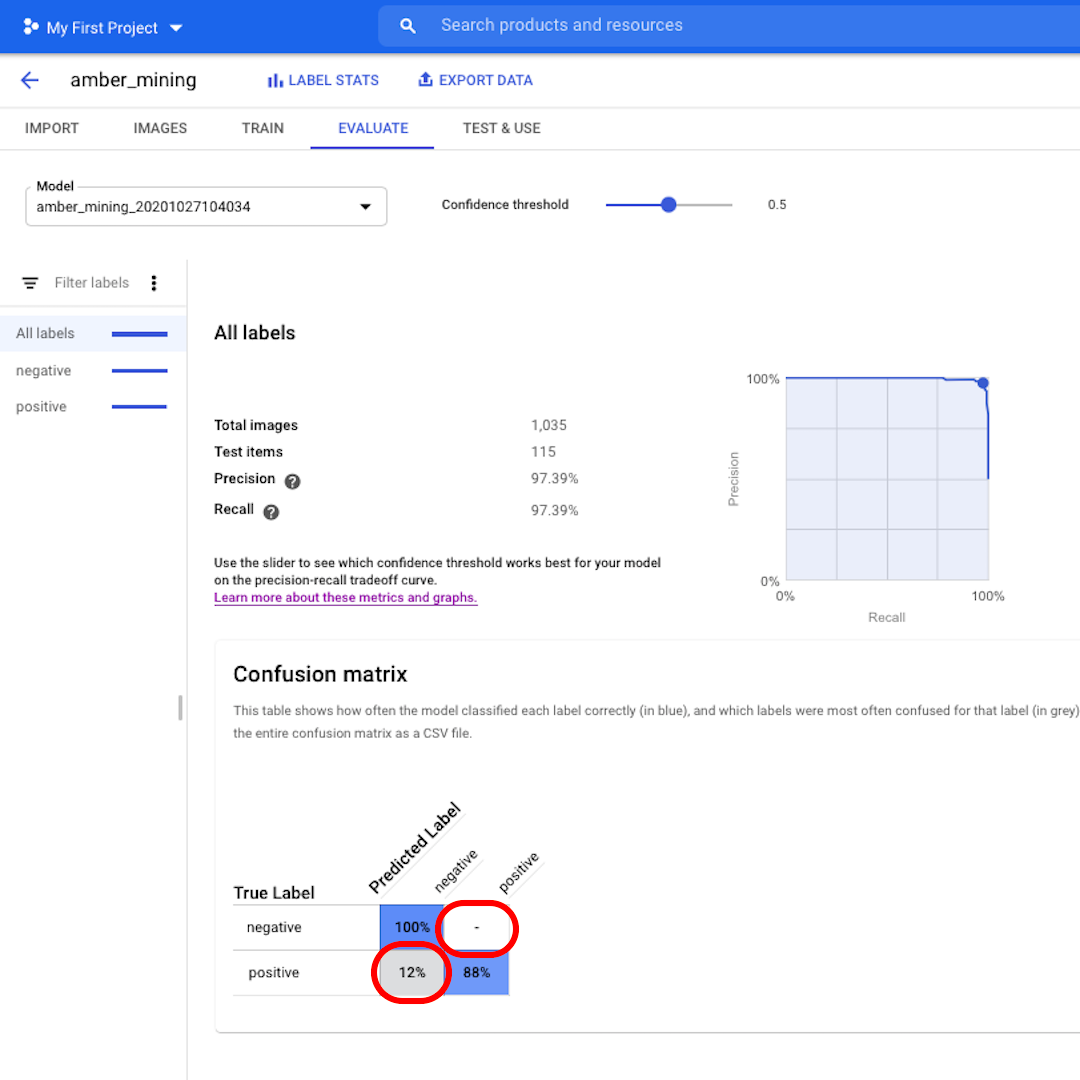

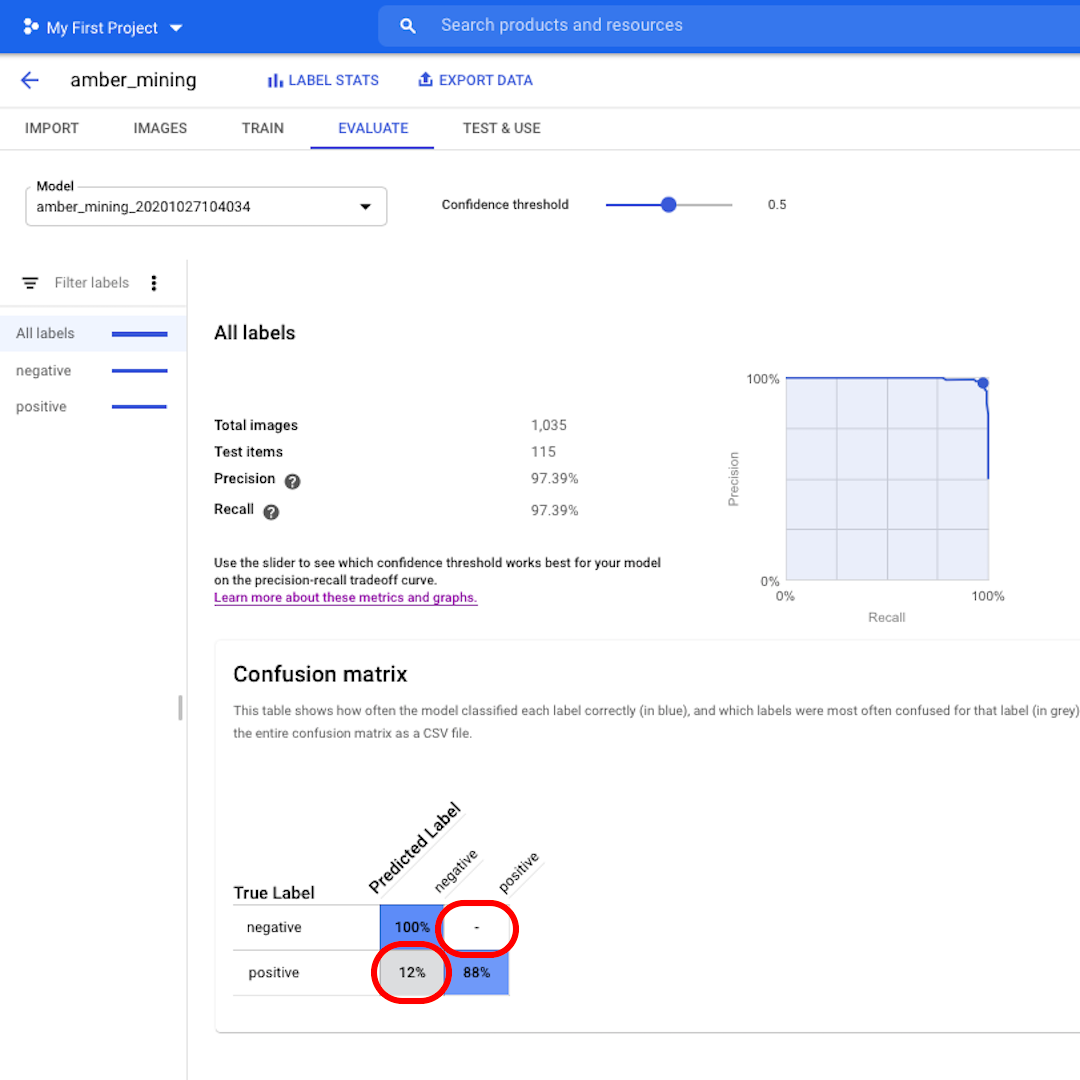

Em seguir, vamos conferir a Matriz de Confusão. Quanto maiores forem as pontuações no fundo azul, melhor terá sido o desempenho do modelo. Neste exemplo, as pontuações são ótimas.

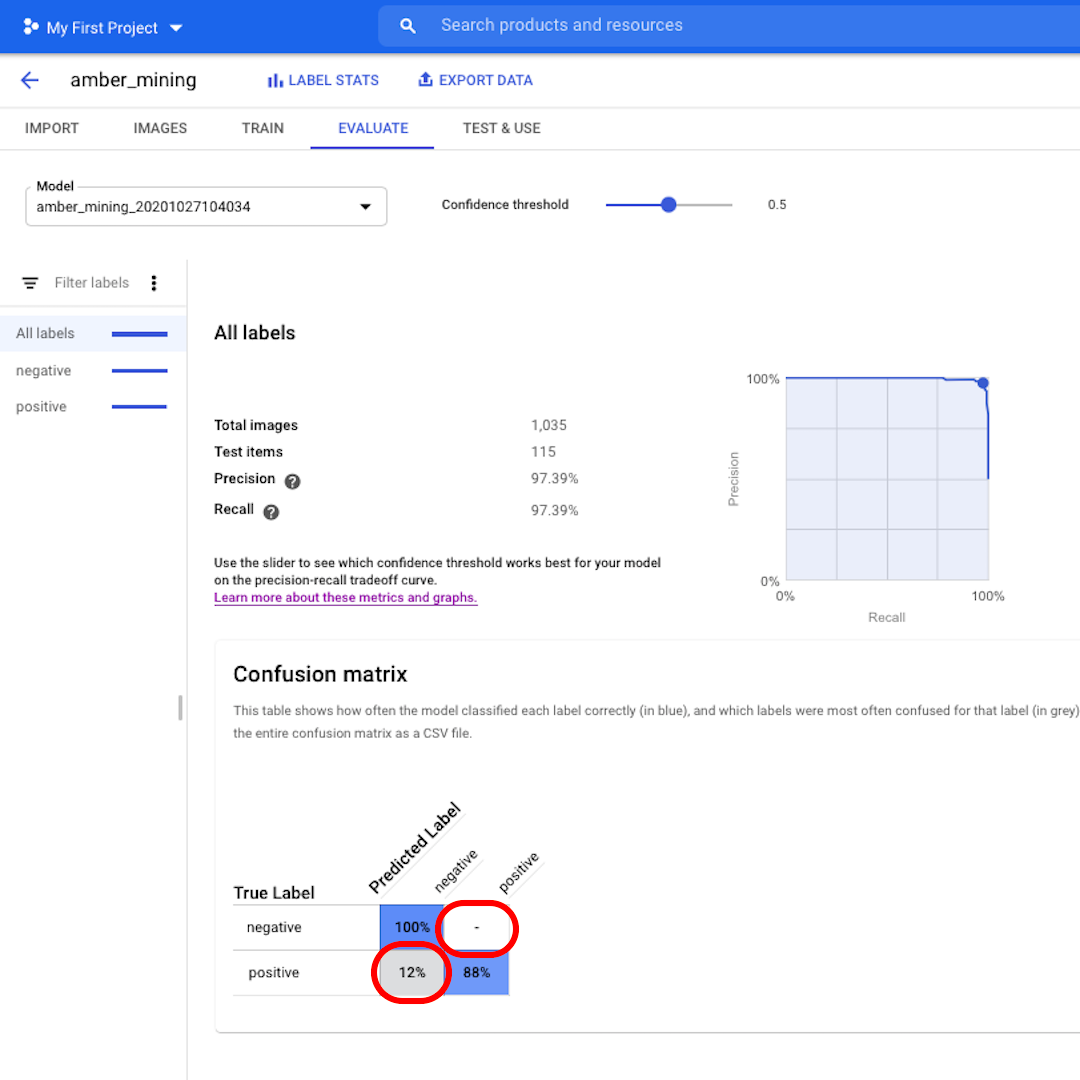

Todas as imagens que deveriam ter sido rotuladas como negativas (sem mineração de âmbar) foram reconhecidas pelo modelo, e 82% das imagens que incluíam indícios de mineração de âmbar foram corretamente rotuladas como tal.

Não temos falsos positivos – nenhuma imagem foi incorretamente rotulada como exemplo de mineração de âmbar. E apenas 12% de falsos negativos: imagens demonstrando indícios de mineração de âmbar que o modelo não foi capaz de reconhecer.

Isso é positivo para os fins da nossa investigação sobre mineração ilegal de âmbar: é melhor perder alguns exemplos positivos que apresentar como provas imagens de mineração de âmbar que não mostram isso na prática.

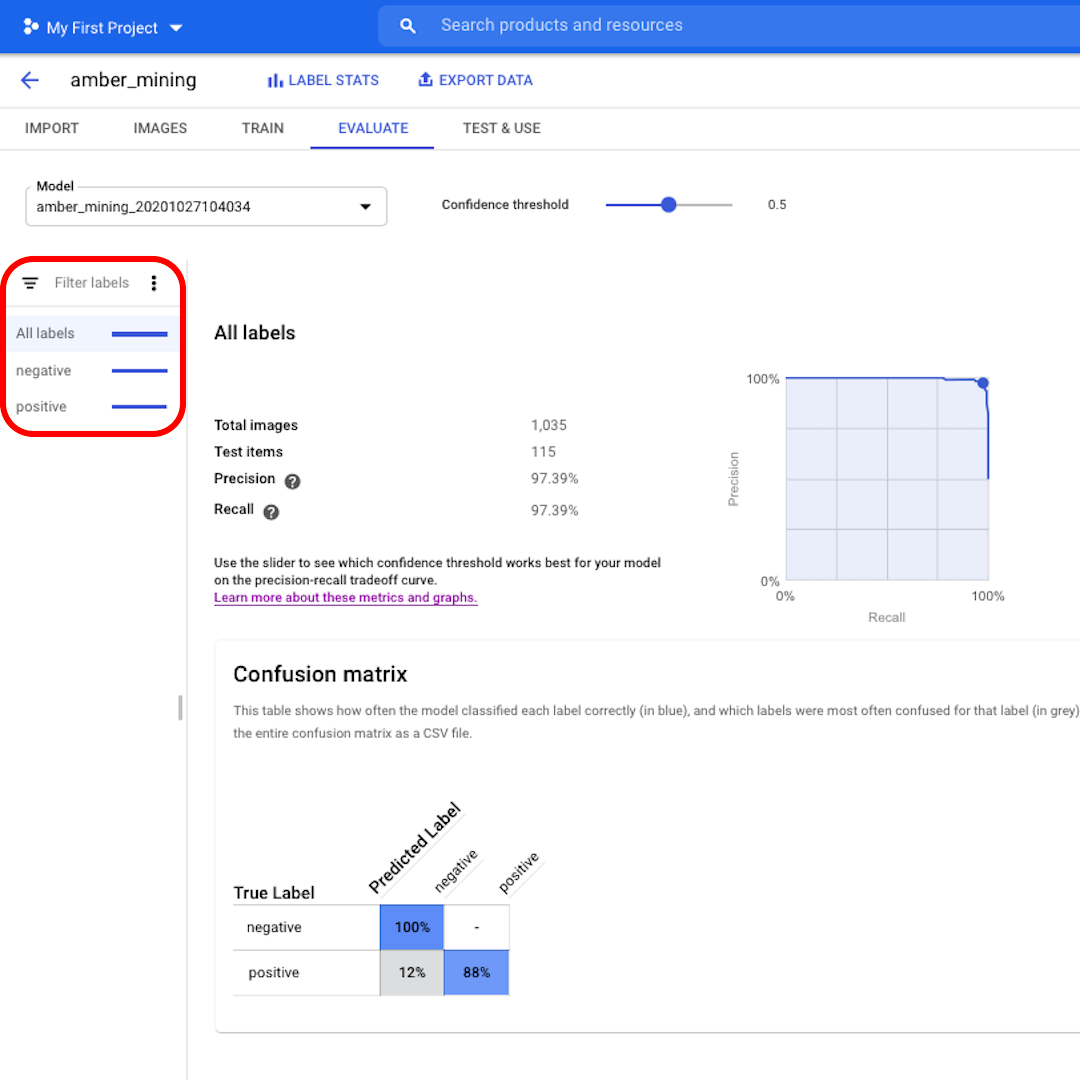

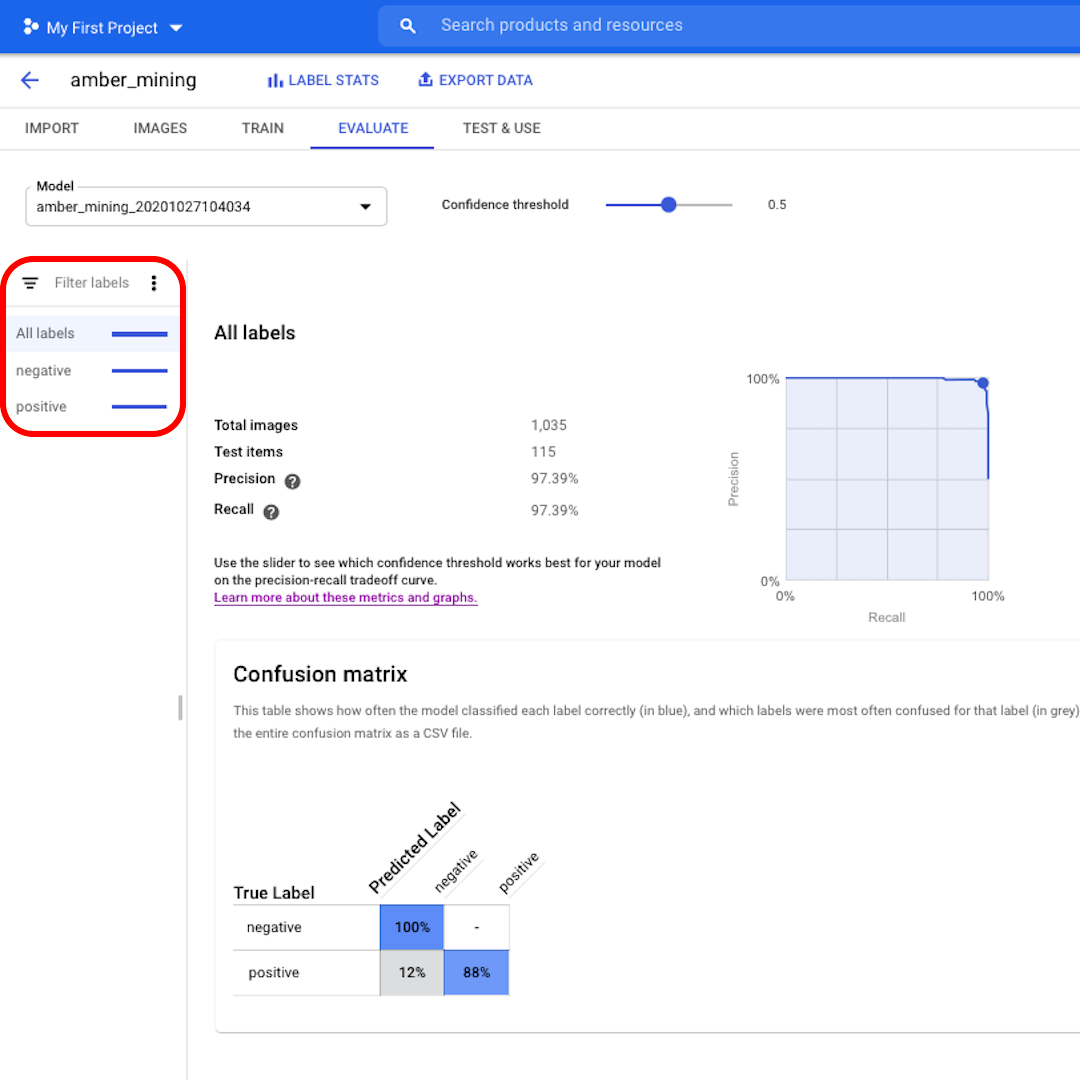

Cliquem nos filtros à esquerda para conferir quais imagens do teste foram correta ou incorretamente classificadas pelo modelo.

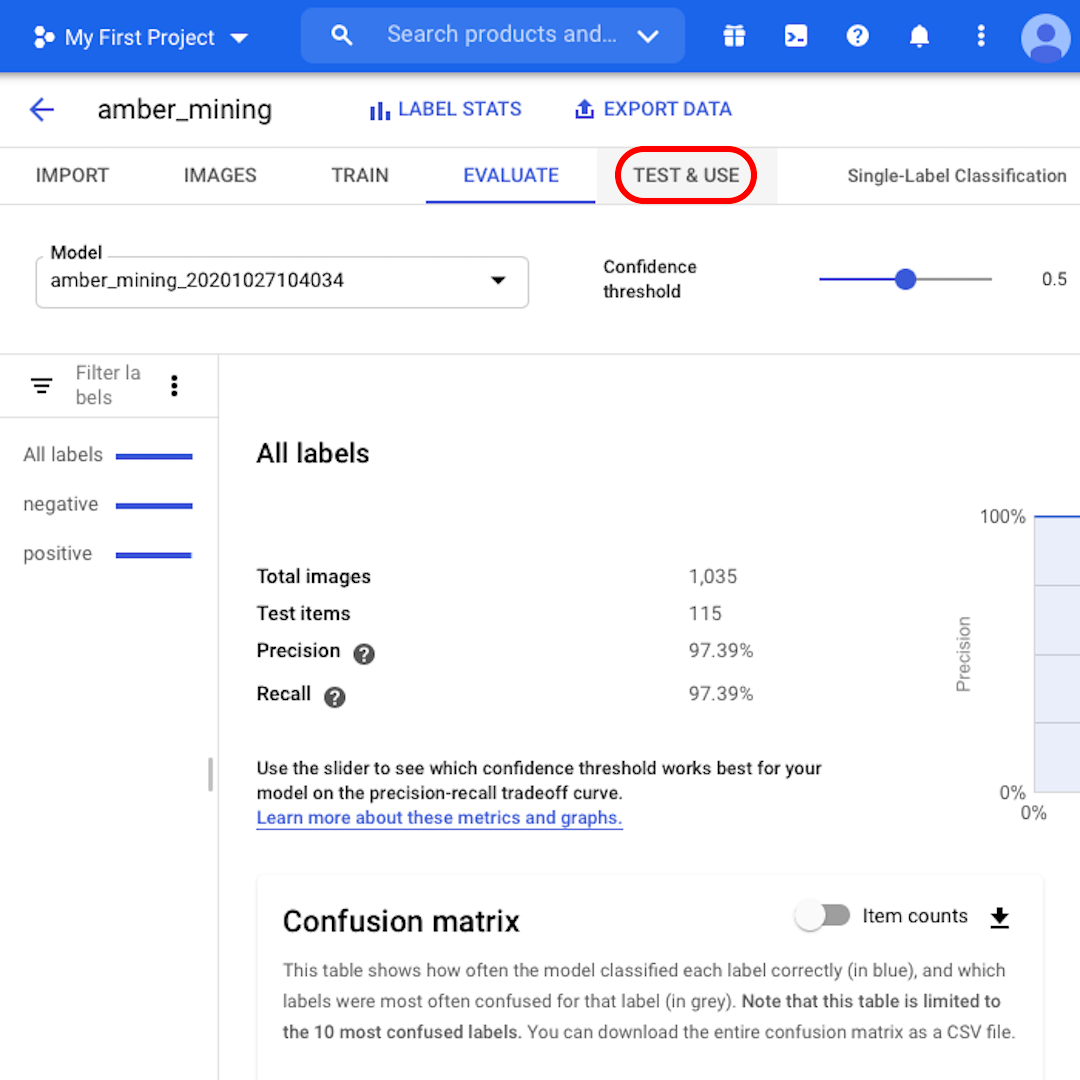

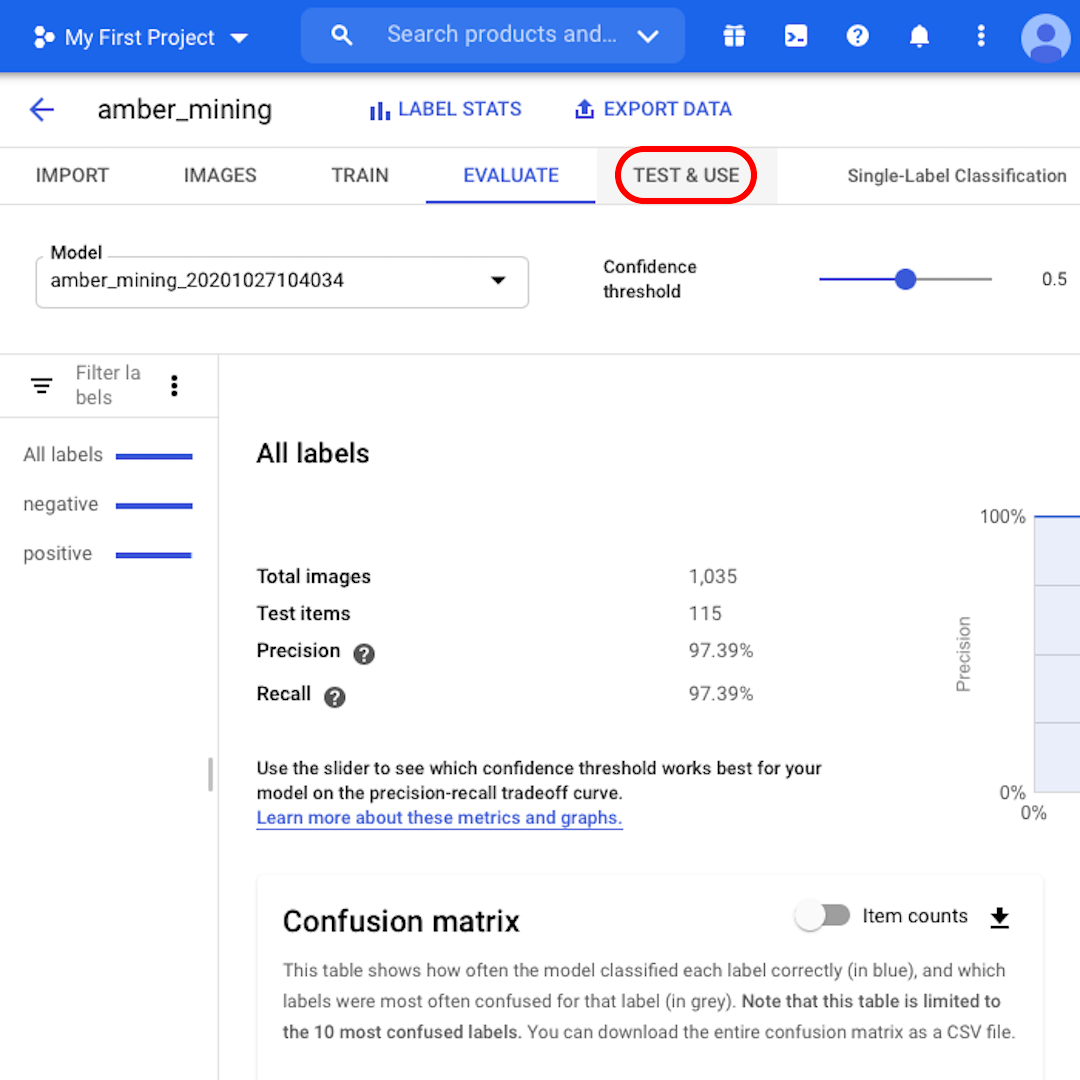

Ainda não estão certos de que podem confiar no modelo? Clicando em “Testar e usar”, vocês podem carregar novas imagens de satélite – com ou sem indícios de mineração de âmbar – para ver se o modelo as rotula corretamente.

Teste e treine novamente

Algumas considerações finais antes de concluirmos:

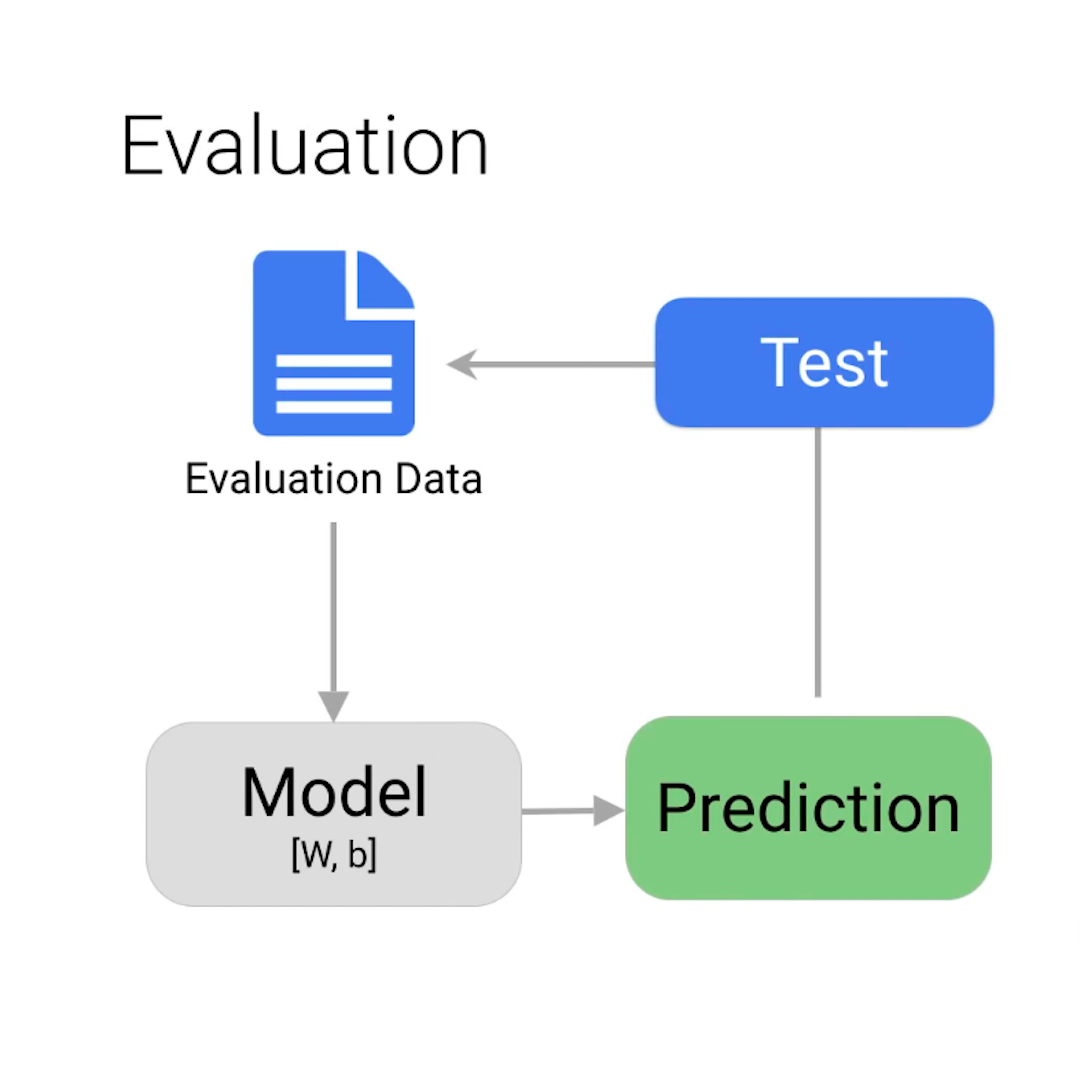

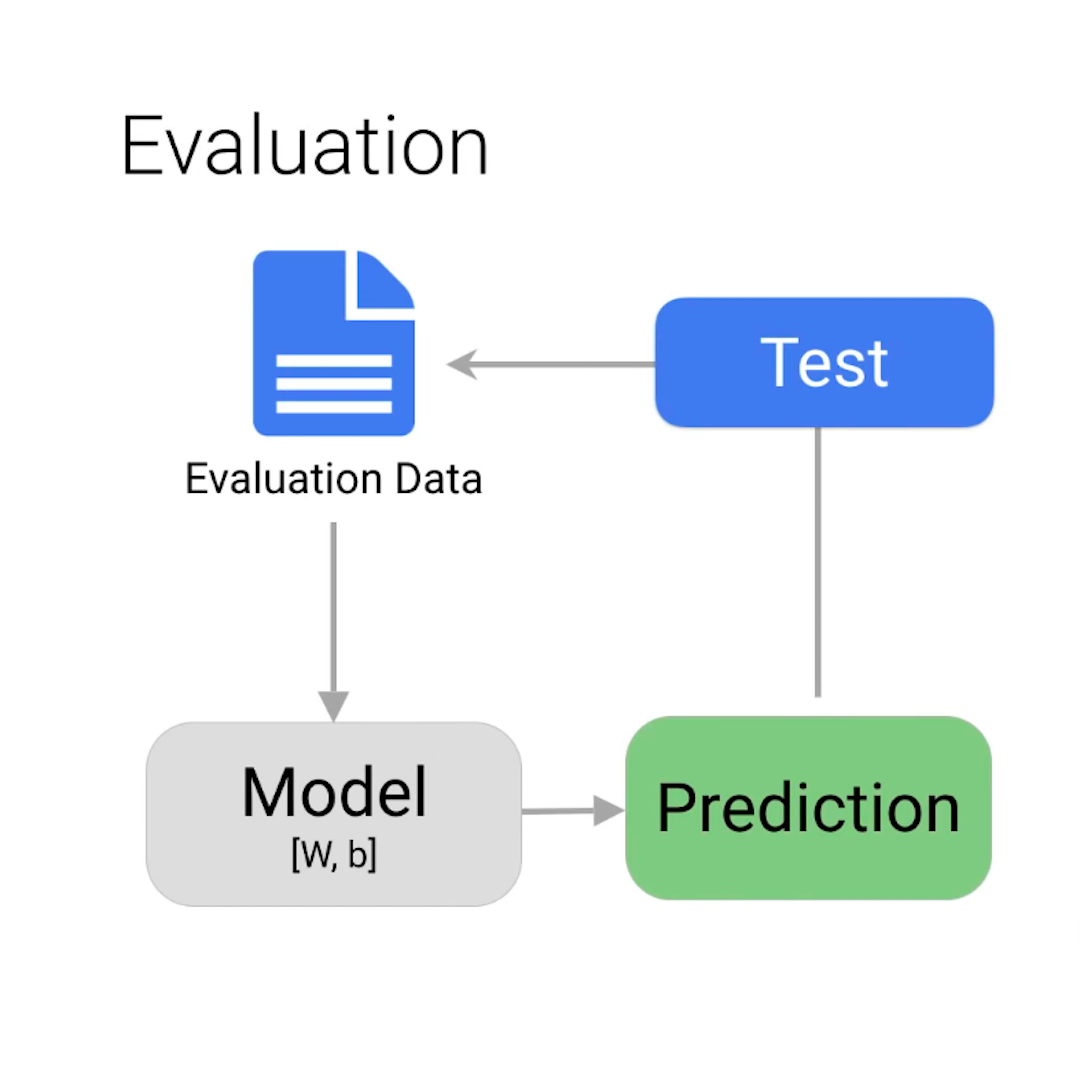

Vocês podem estar se perguntando como o modelo está fornecendo algumas respostas erradas quando lhe informamos todas as respostas certas inicialmente. Nesse caso, revisem a divisão entre os conjuntos treinamento, validação e teste, descrita na aula anterior.

Para este exemplo, quase todas as imagens foram classificadas corretamente. Mas esse nem sempre será o caso. Se não estiverem satisfeitos com o desempenho de seus modelos, vocês sempre podem atualizar e aprimorar seus conjuntos de dados e treinar os modelos novamente. Vocês podem analisar cuidadosamente o que houve de errado na primeira iteração – e, por exemplo, adicionar aos seus conjuntos de treinamento mais imagens similares àquelas que foram classificadas incorretamente pelo modelo.

Quanto às pessoas, a aprendizagem é um processo iterativo.

-

-

Comece a usar o Google Notícias com a Central do Editor

AulaEnvie, gerencie e gere receita com suas notícias no Google. -

Como usar as principais métricas da Web para manter o engajamento dos visitantes

AulaCrie uma ótima experiência do usuário no seu site de notícias