Preferencias en el aprendizaje automático

Comprenda lo que son las preferencias del aprendizaje automático y cómo evitarlas.

Imparcialidad en el aprendizaje automático

Hasta ahora, este curso ha mostrado la forma en que el aprendizaje automático puede mejorar su trabajo, desde ahorrarle tiempo valioso en las tareas existentes hasta abrir nuevas oportunidades. El aprendizaje automático puede hacer mucho por usted, pero esto conlleva desafíos que no debería ignorar.

Para abordar esos desafíos, un número cada vez mayor de investigadores y practicantes se enfocan en el tema de la "imparcialidad" en el aprendizaje automático. Su principio fundamental es que el aprendizaje automático debería beneficiar por igual a todos, sin importar las categorías sociales que diseñan e impactan nuestras vidas.

¿Qué son las preferencias?

¿Cuáles son las consecuencias negativas que podrían derivar del uso del aprendizaje automático? La respuesta corta es: las preferencias.

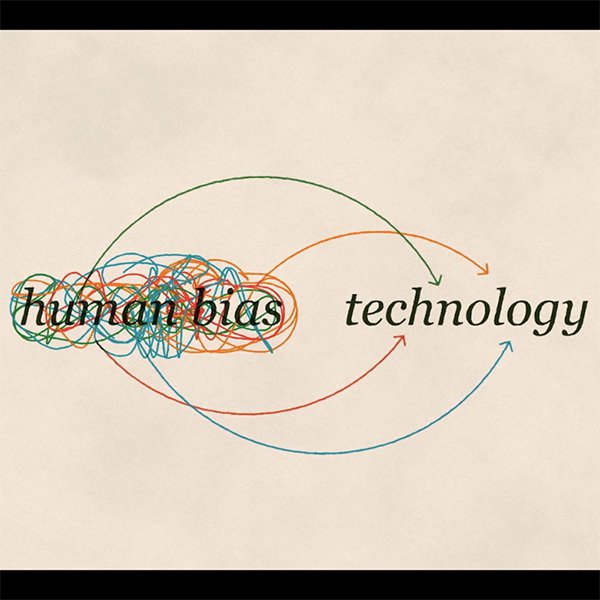

Como humanos, todos tenemos nuestras preferencias. Son herramientas que nuestro cerebro usa para lidiar con la información que se nos presenta día tras día.

Tomemos este ejemplo: cierre sus ojos e imagine un zapato. Lo más probable es que haya imaginado un tenis. O quizás un zapato de piel para caballero. Es menos probable que haya pensado en un zapato de tacón alto para dama. Quizás ni siquiera sepamos por qué, pero cada uno de nosotros preferimos un zapato por encima de otros.

Ahora imagine que desea enseñarle a una computadora a reconocer un zapato. Puede terminar exponiéndole sus propias preferencias. Así es como ocurren las preferencias en el aprendizaje automático. Incluso con buenas intenciones, es imposible separarnos a nosotros mismos de nuestras propias preferencias.

Tres tipos de preferencias

Existen diferentes formas en las que nuestras propias preferencias se arriesgan a formar parte de la tecnología que creamos:

Preferencias de interacción

Tomemos el ejemplo anterior: si entrenamos a un modelo para que reconozca zapatos con un conjunto de datos que incluya mayormente imágenes de tenis, el sistema no aprenderá a reconocer los zapatos de tacón alto como zapatos.

Preferencias latentes

Si entrena a un sistema de aprendizaje automático sobre la apariencia de un científico usando imágenes de científicos famosos del pasado, su algoritmo probablemente aprenderá a asociar científicos solamente con hombres.

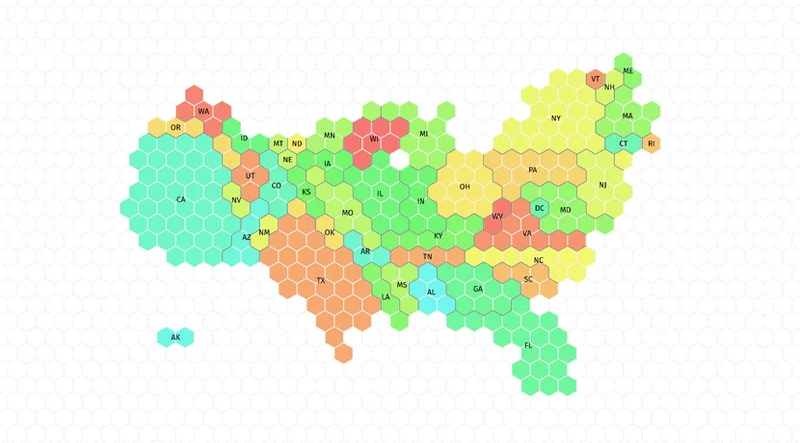

Preferencias de selección

Digamos que está entrenando a un modelo para reconocer rostros. Si los datos que usa para entrenarlo representan en exceso una población, operará mejor para ellos a expensas de otros, con consecuencias potencialmente racistas.

Entonces, ¿qué podemos hacer para evitar estas preferencias?

Haciendo las preguntas correctas para evitar preferencias

Como reportero, una primera línea de defensa contra las preferencias está firmemente dentro de su alcance: los mismos valores y principios éticos que aplica cada día en su profesión deberían extenderse para evaluar la imparcialidad de cualquier tecnología que sea añadida a su caja de herramientas. El aprendizaje automático no es la excepción.

Además, en todos los casos, debería comenzar considerando si las consecuencias podrían impactar negativamente la economía de las personas u otras oportunidades importantes de vida. Esto es especialmente fundamental si los datos que usa incluyen información personalmente sensible.

A menudo, el impacto injusto no es inmediatamente obvio, pero requiere hacer preguntas con matices sociales, políticos y éticos sobre la manera en que permitiría que ingresaran sus preferencias a su sistema de aprendizaje automático.

Considerando las fuentes principales de las preferencias

Aunque no habrá datos de entrenamiento que estén completamente "sin preferencias", puede mejorar en gran medida sus posibilidades de crear un modelo imparcial si considera cuidadosamente las fuentes potenciales de las preferencias en sus datos, y tomar medidas para abordarlas.

La razón más común de que se infiltren las preferencias es cuando sus datos de entrenamiento no representan realmente la población en la cual su modelo está haciendo predicciones. Debe asegurarse de tener datos suficientes para cada grupo relevante.

Un tipo diferente de preferencias se manifiesta cuando algunos grupos son representados de manera menos positiva que otros en los datos de entrenamiento. Debería considerar revisar sus datos antes de usarlos para entrenar a su modelo con el fin de verificar si conllevan algún prejuicio que pudiera ser aprendido y reproducido por el algoritmo.

Evitando las preferencias: comienza con la conciencia

Las preferencias pueden emerger de muchas formas: desde los conjuntos de datos para el entrenamiento, debido a decisiones tomadas durante el desarrollo de un sistema de aprendizaje automático, y a través de los complejos bucles de retroalimentación que surgen cuando se está implementando un sistema de aprendizaje automático en el mundo real.

Algunas preguntas concretas que querrá hacer para reconocer posibles preferencias incluyen:

- ¿Para qué fin fueron recopilados los datos?

- ¿Cómo se recopilaron los datos?

- ¿Cuál fue la meta de usar este conjunto de datos y este algoritmo en particular?

- ¿Cómo fue evaluada la fuente de los datos?

- ¿Cómo se definió el proceso de análisis de datos antes del mismo análisis?

Las preferencias son un asunto complejo y no existe un remedio perfecto. La solución comienza con el conocimiento y siendo todos nosotros conscientes de los riesgos y tomando las medidas correctas para minimizarlos.

-

-

Video: Introducción a Google Trends

LecciónGoogle Trends te permite explorar patrones de solicitudes de búsqueda por tema y períodos. -

Aumenta el tráfico con los productos de búsqueda de Google

LecciónConsigue que más usuarios descubran tus noticias