Évaluer et tester

Comment interpréter les résultats de votre modèle et évaluer ses performances

Précision et rappel

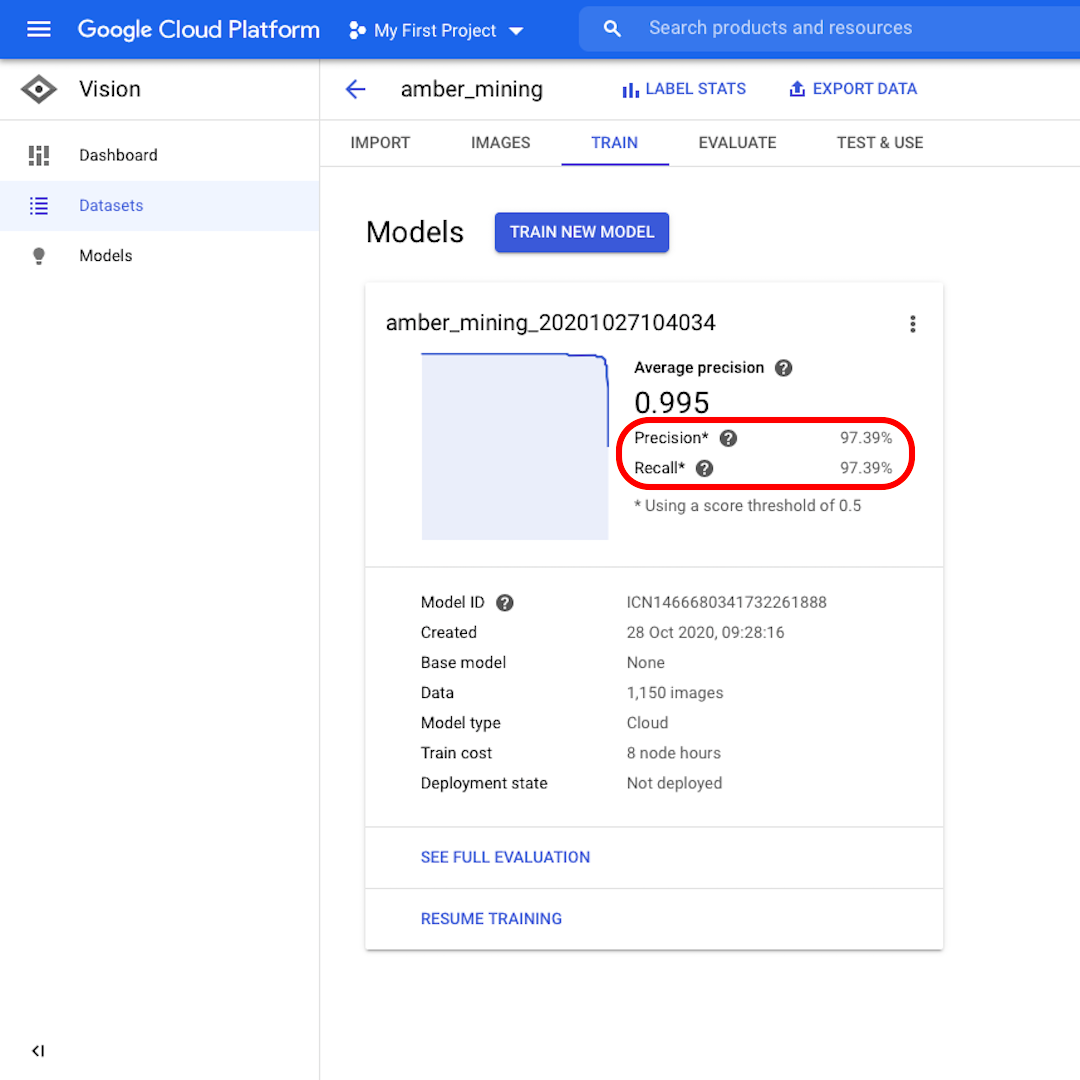

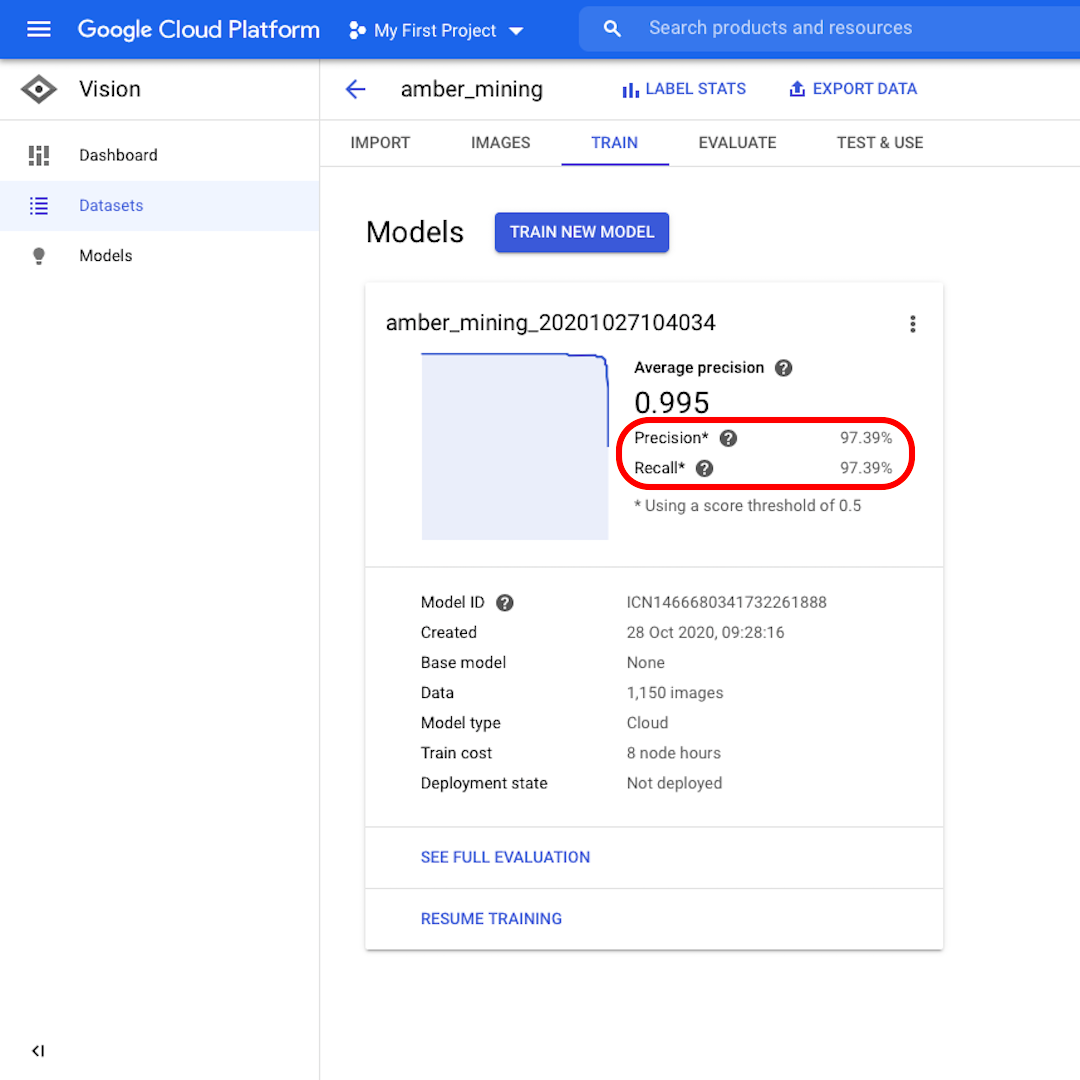

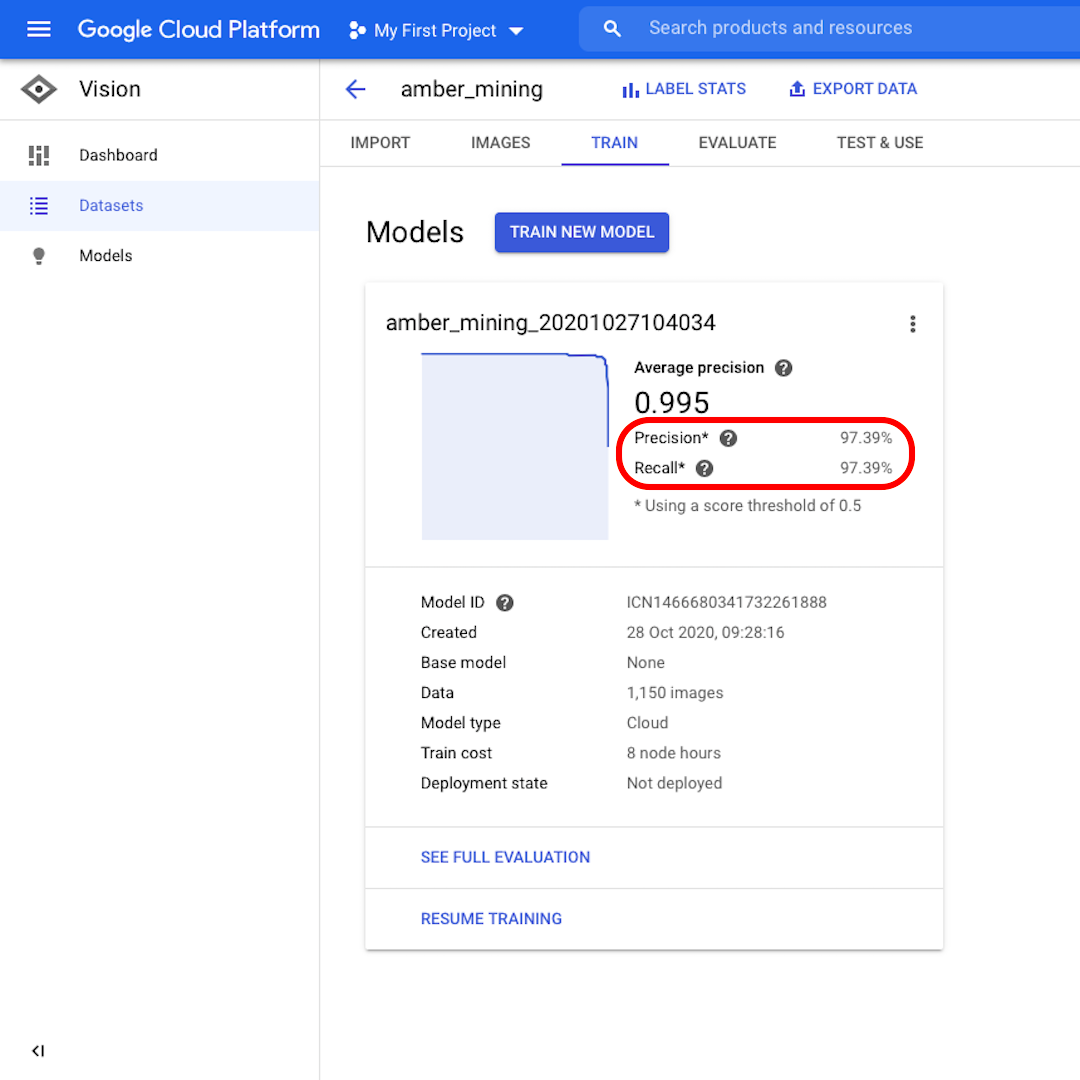

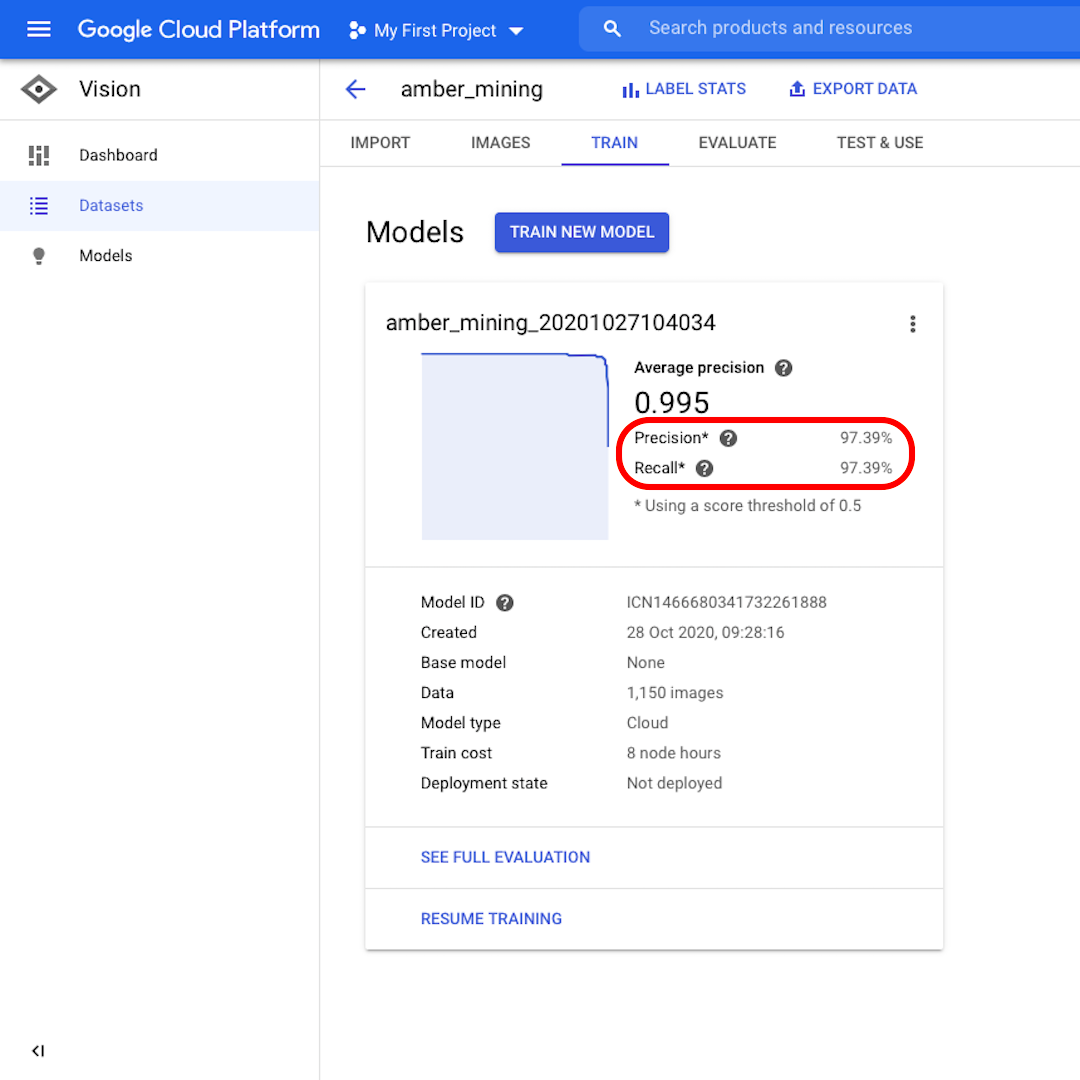

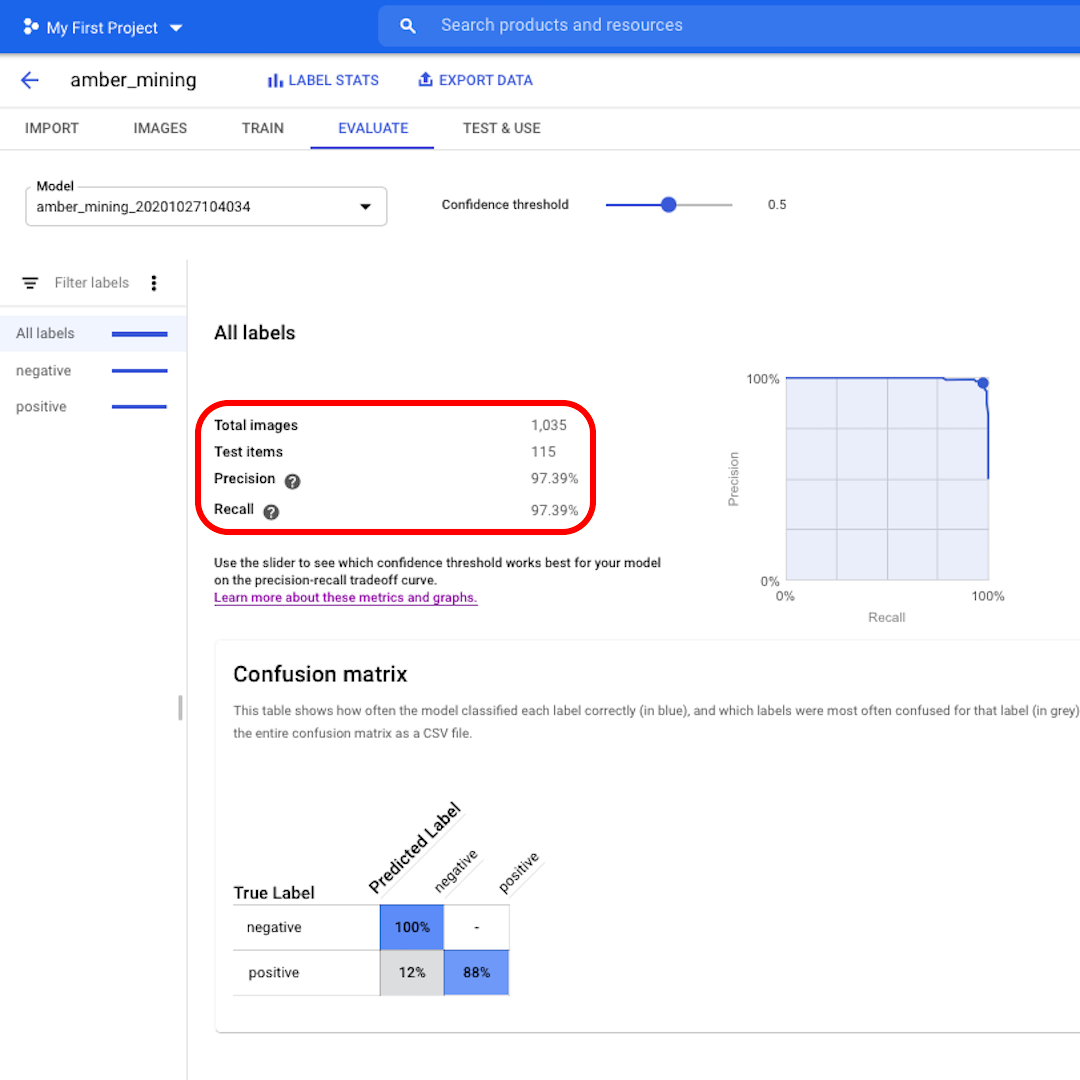

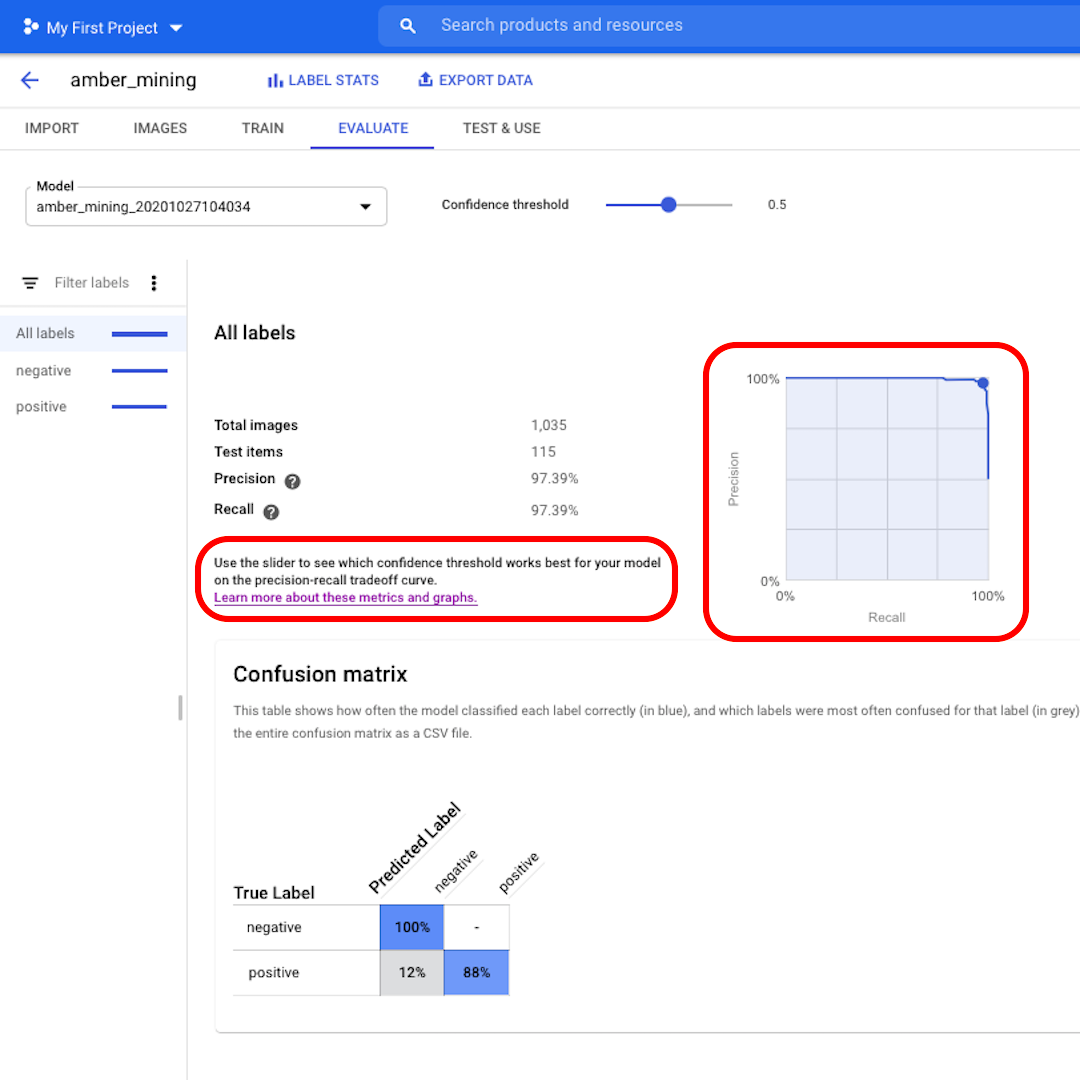

Une fois le modèle formé, vous verrez un résumé des performances du modèle avec les scores pour « Précision » et « Rappel ».

La précision nous indique quelle proportion des images identifiées par le modèle comme positives aurait effectivement dû être classée comme telle. Le rappel nous indique plutôt quelle proportion des images positives réelles a été correctement identifiée.

Notre modèle a obtenu de très bons résultats dans les deux catégories, avec des scores supérieurs à 97 %. Voyons ce que cela signifie plus en détail.

Évaluer les performances du modèle

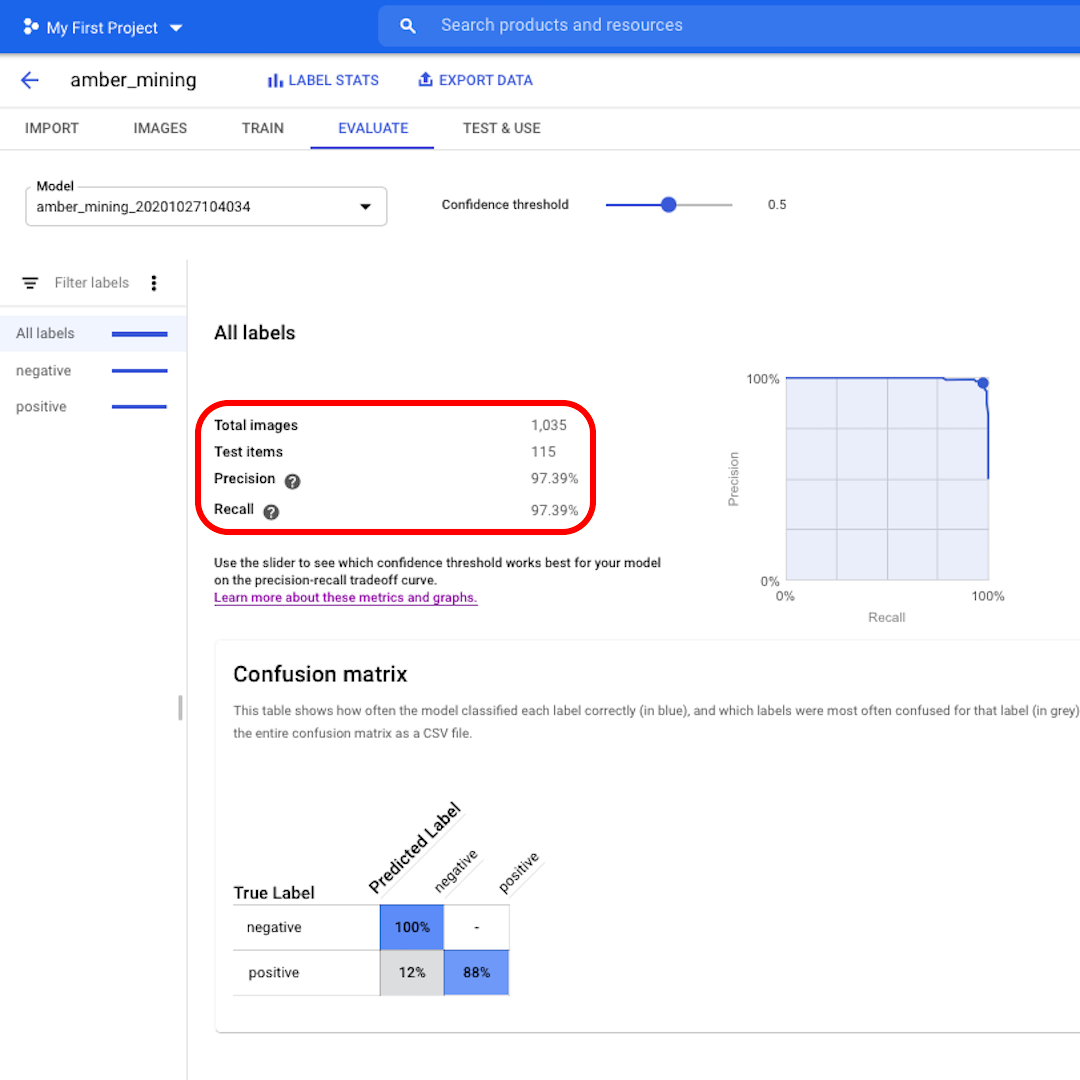

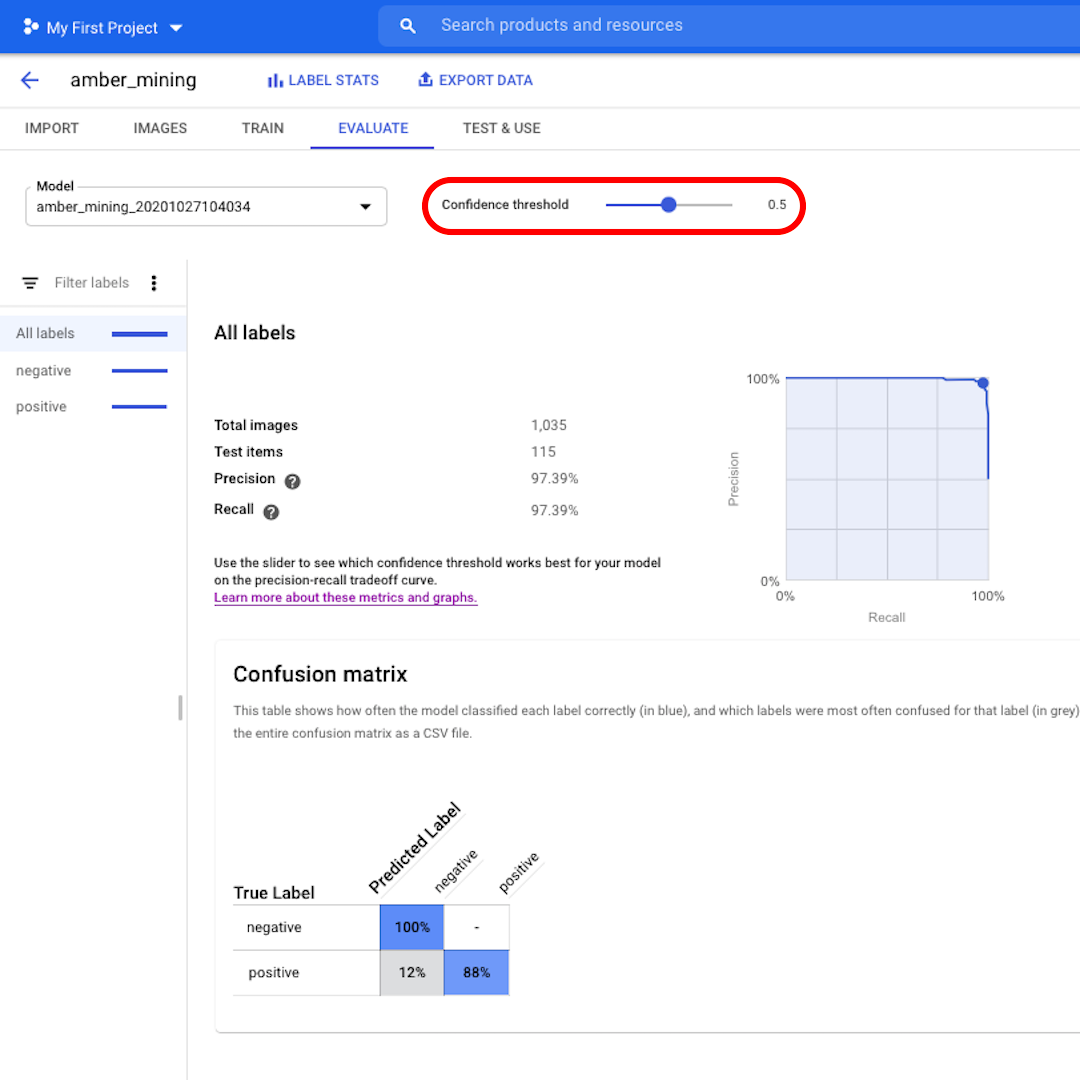

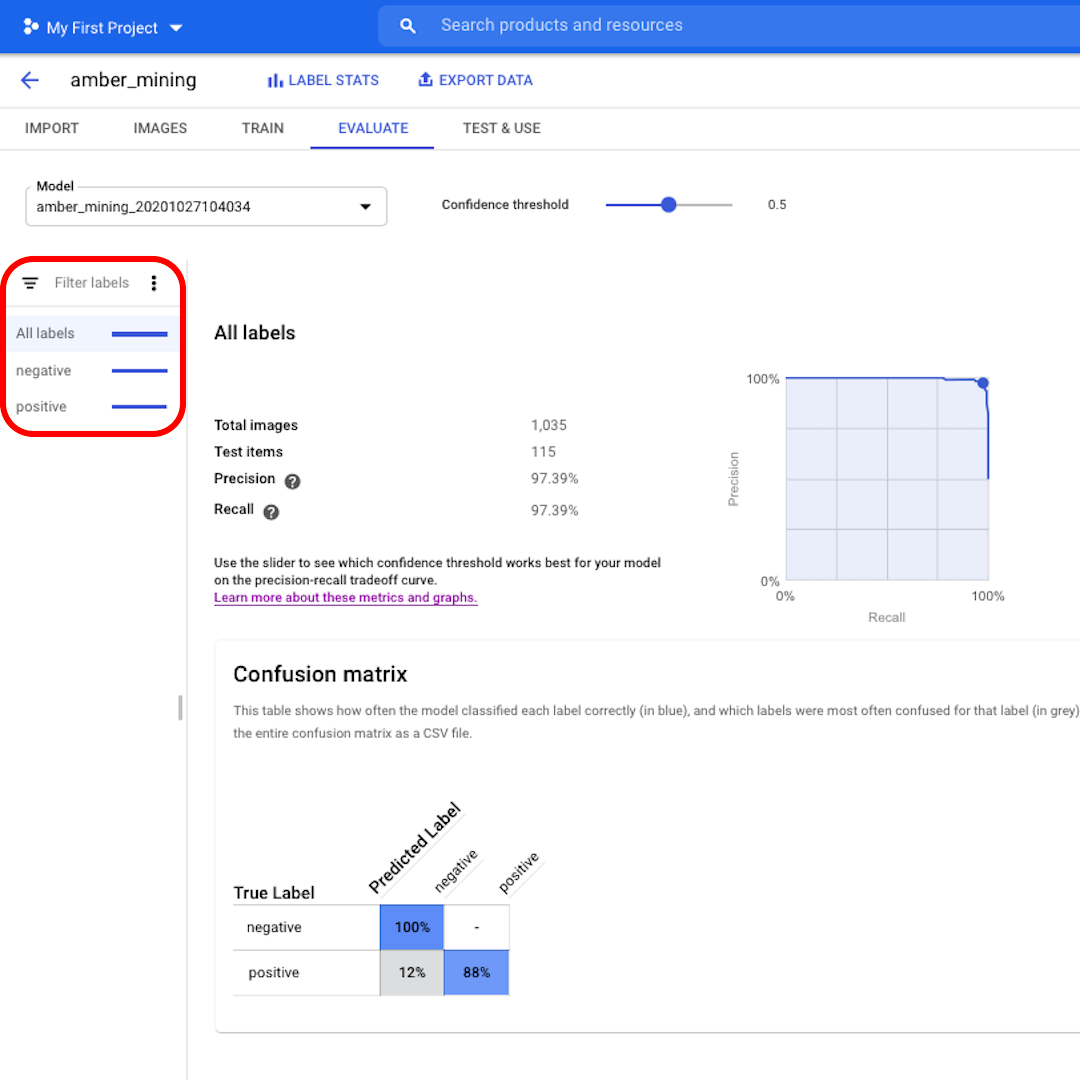

Cliquez sur « Évaluer » dans le menu du haut et étudions l’interface. Tout d’abord, elle nous montre à nouveau les scores sur la précision et le rappel. Dans notre cas, le score de précision nous indique que 97 % des images de test que le modèle a identifiées comme exemples d’extraction d’ambre montraient effectivement des traces d’extraction d’ambre.

Le score de rappel nous indique au contraire que 97 % des images de test montrant des exemples d’extraction d’ambre ont été correctement étiquetées comme telles par le modèle.

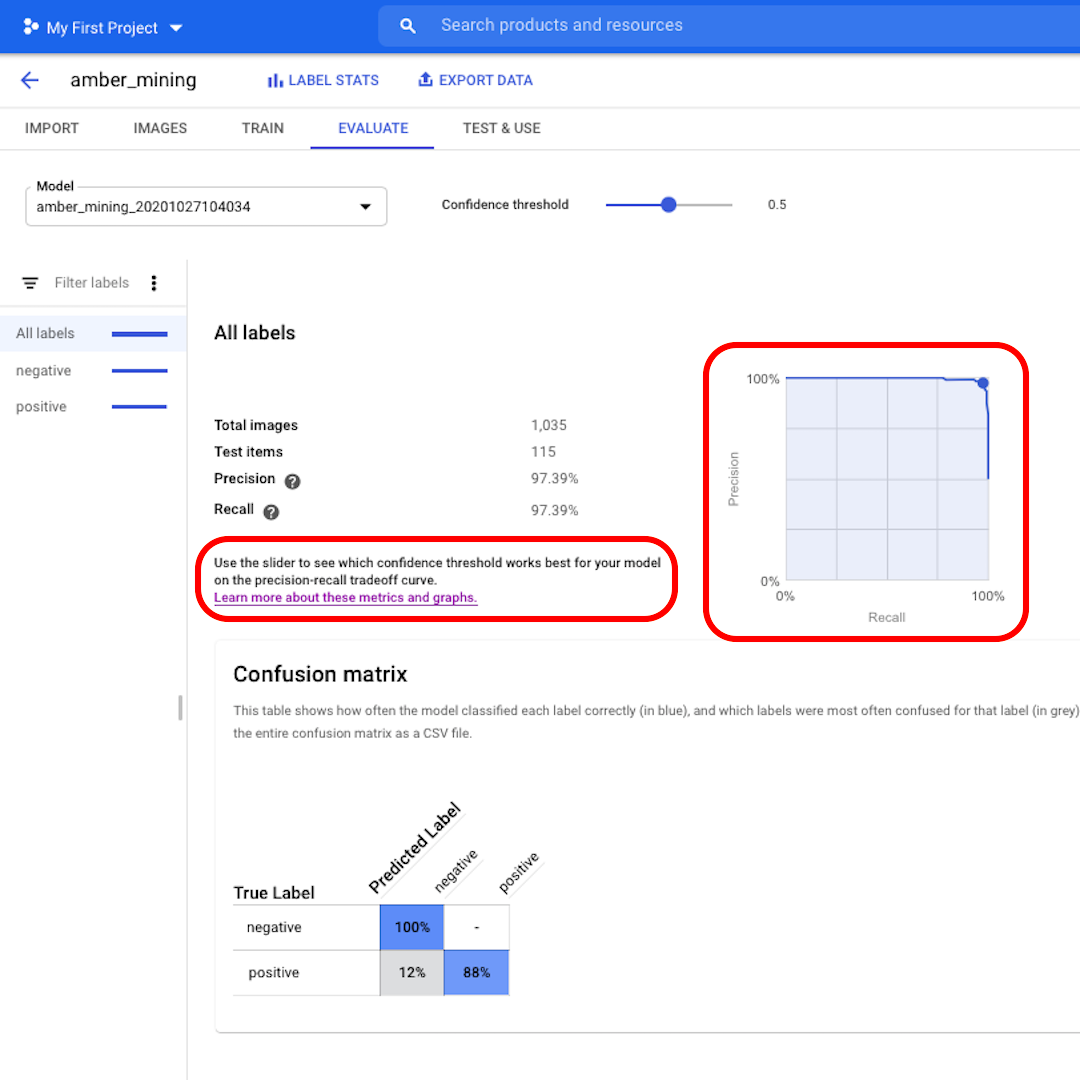

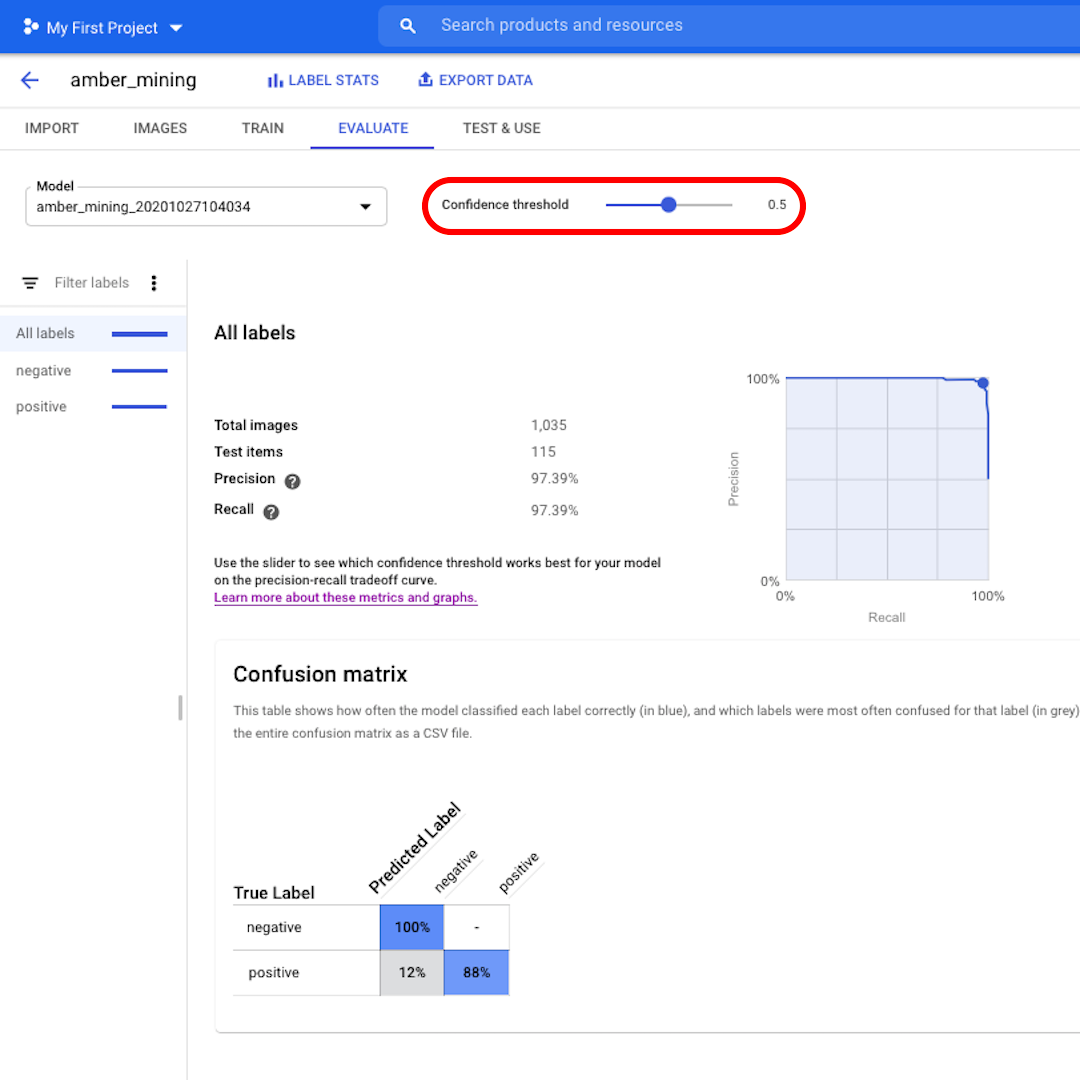

Le seuil de confiance désigne le niveau de confiance que le modèle doit avoir pour attribuer une étiquette. Plus il est bas, plus le modèle classifier d’images, mais plus le risque de mal classifier certaines images est élevé.

Si vous souhaitez approfondir et également explorer les courbes de rappel de précision, suivez le lien sur l’interface pour en savoir plus.

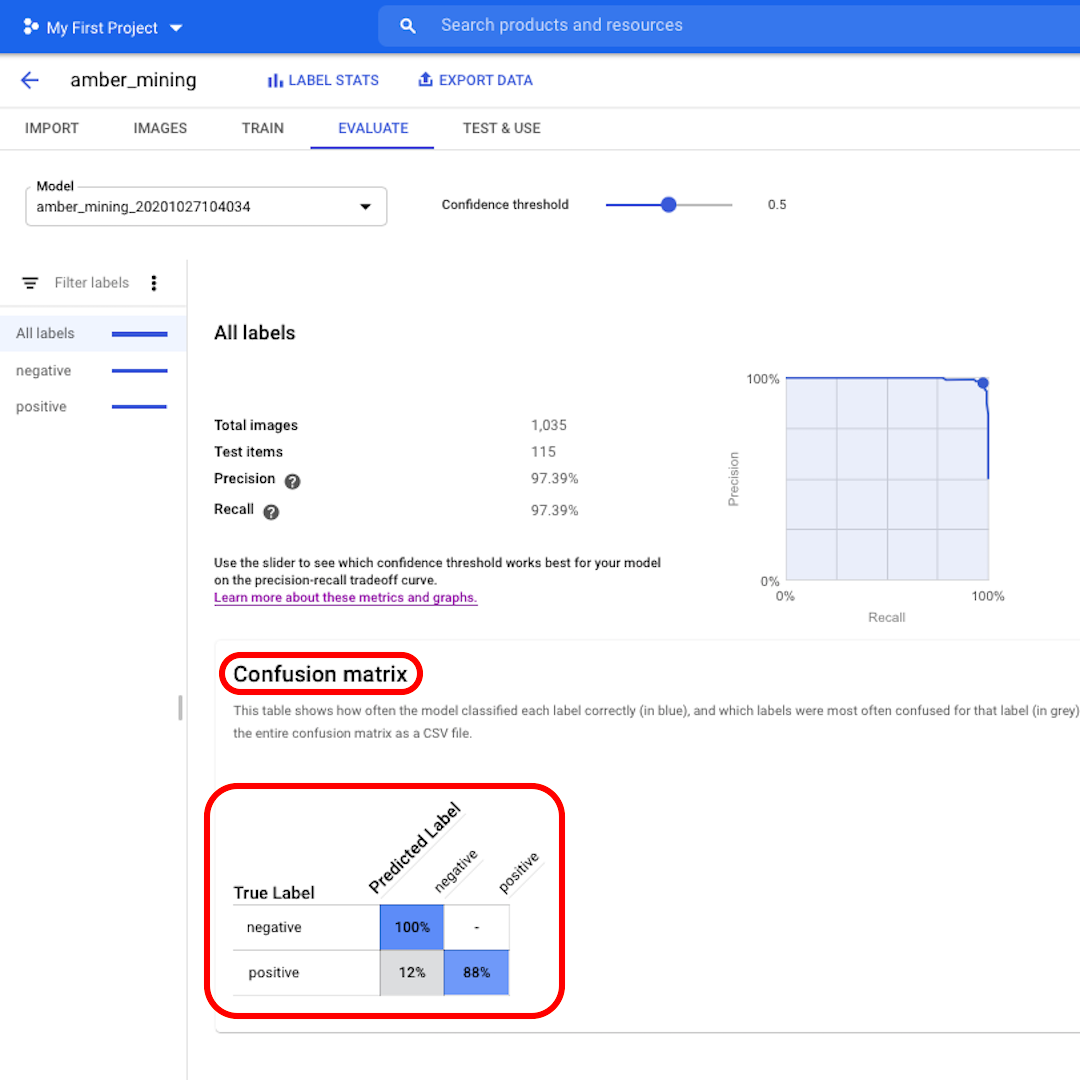

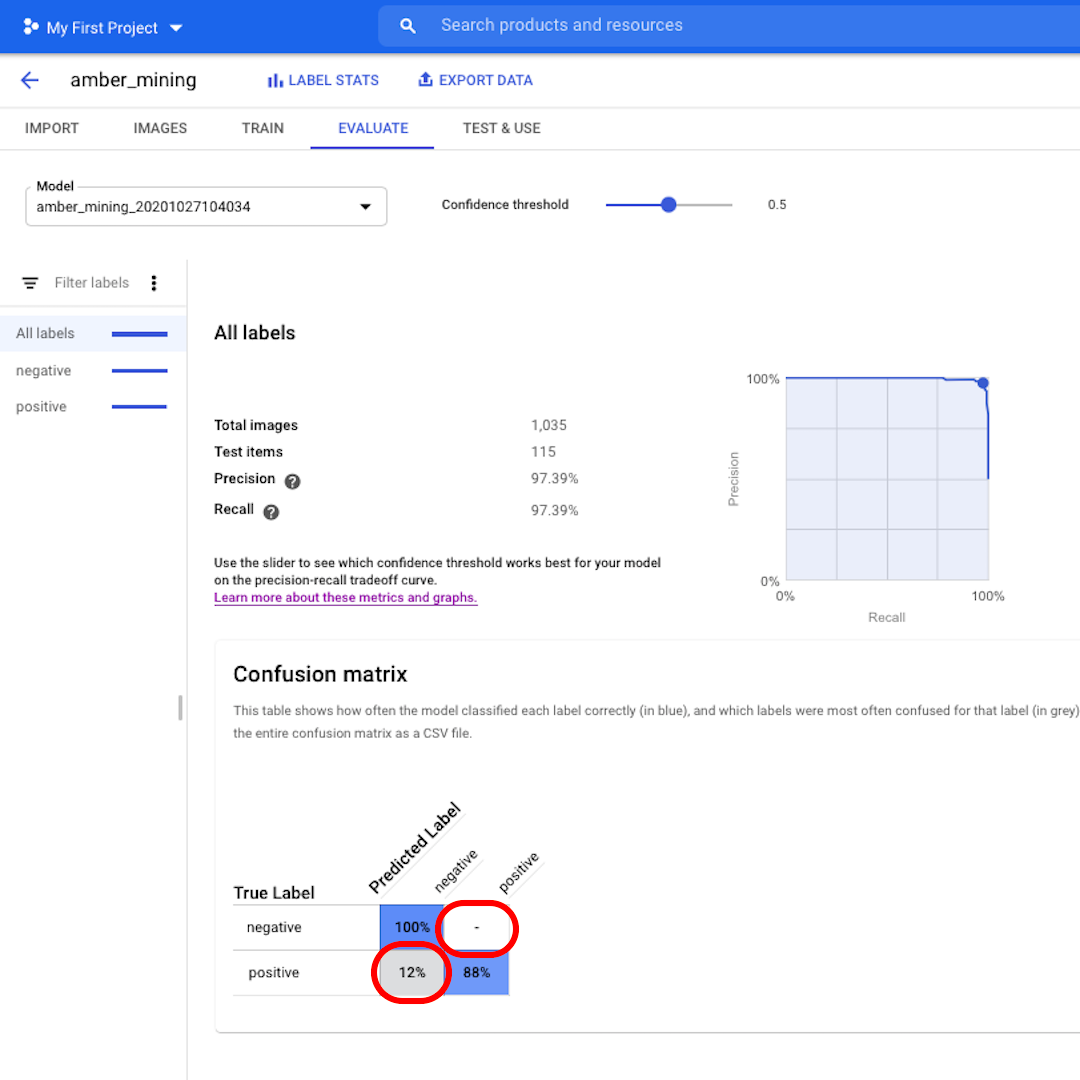

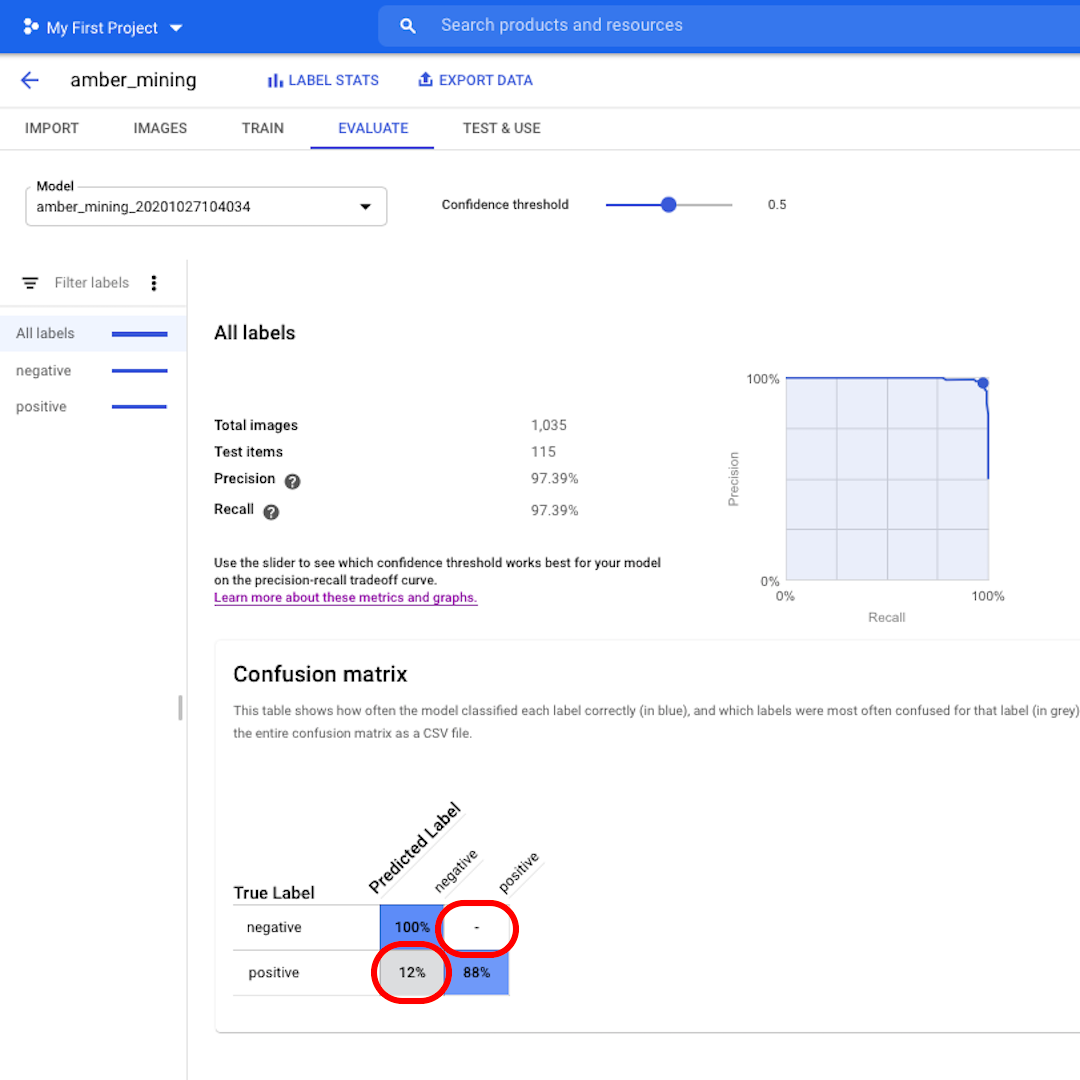

Faux positifs et faux négatifs

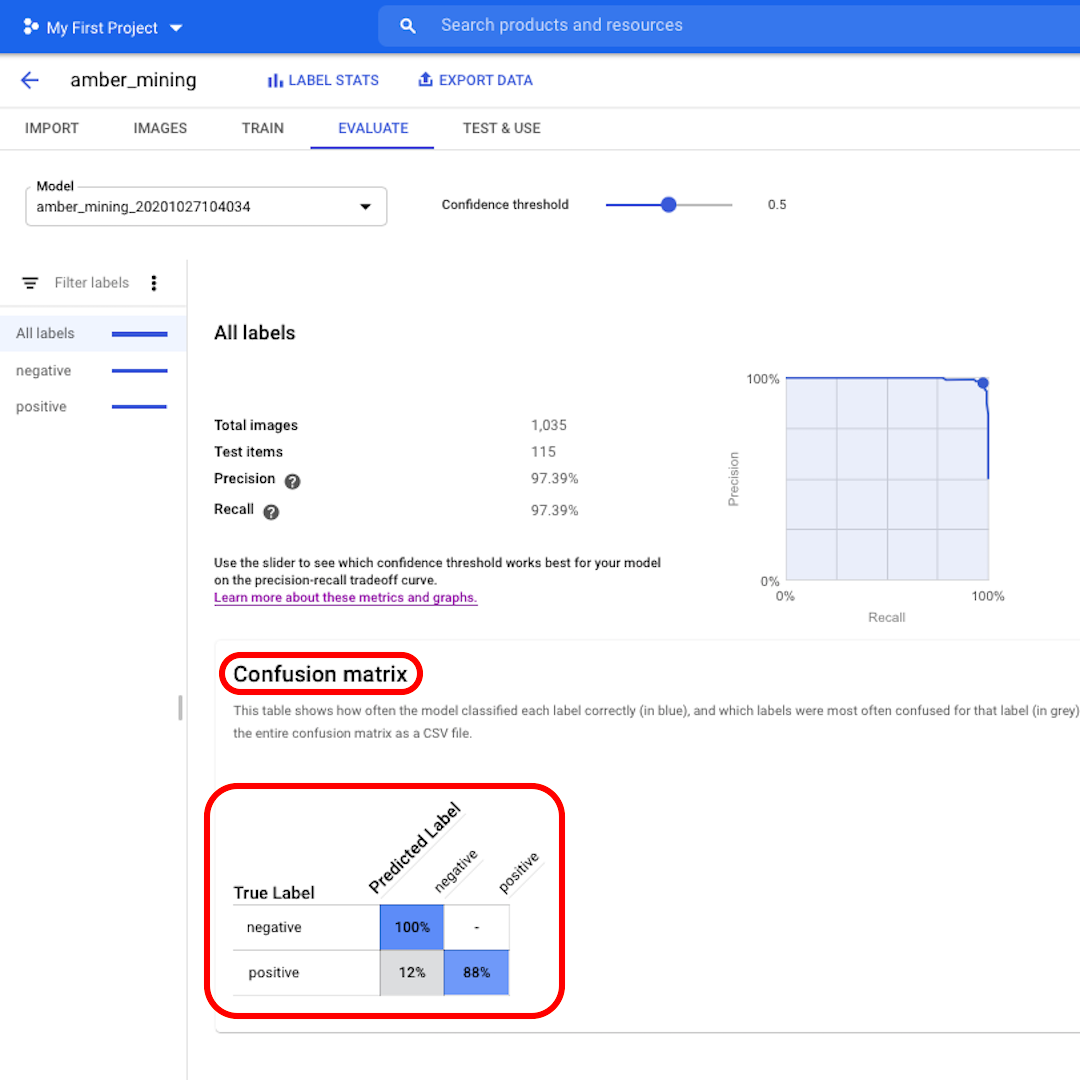

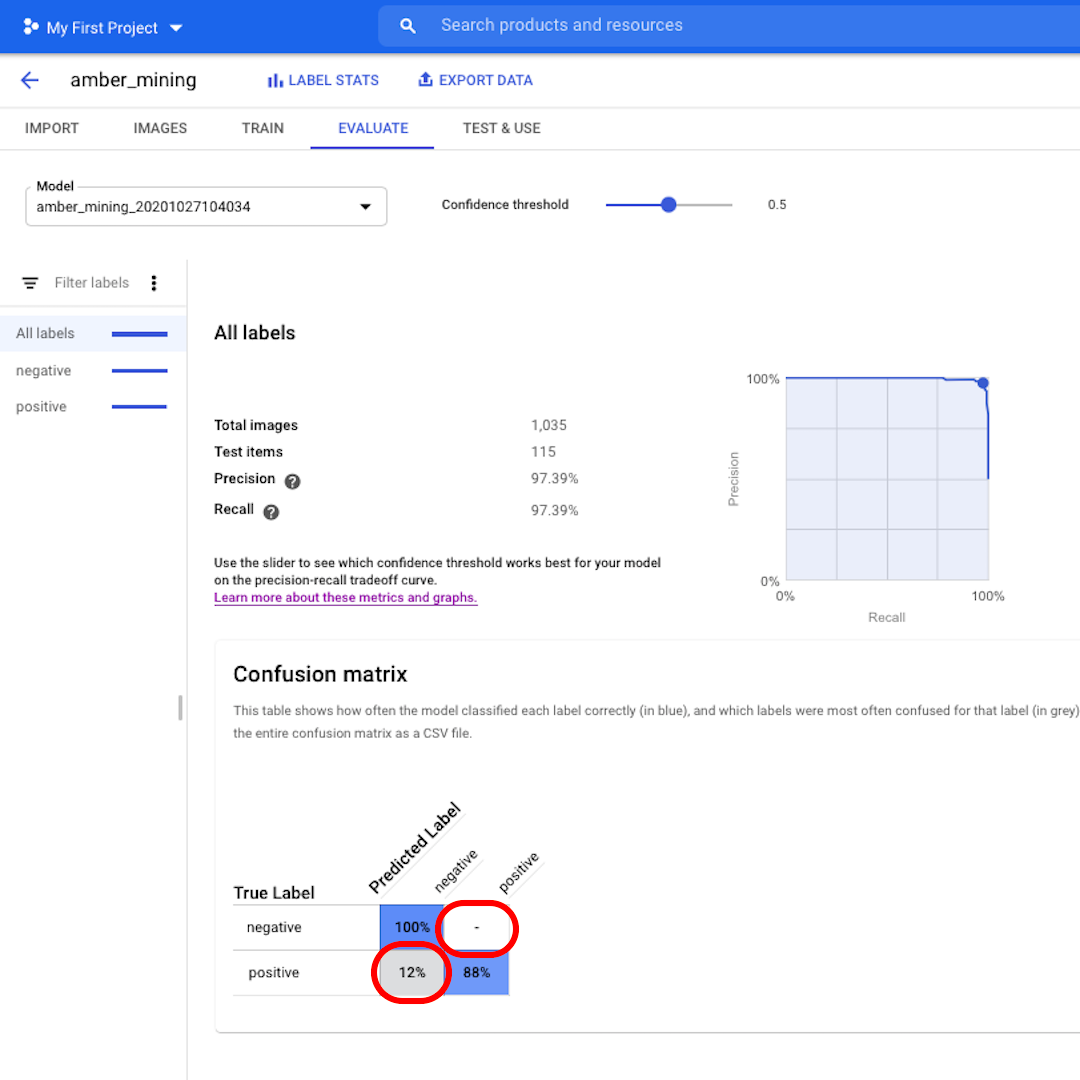

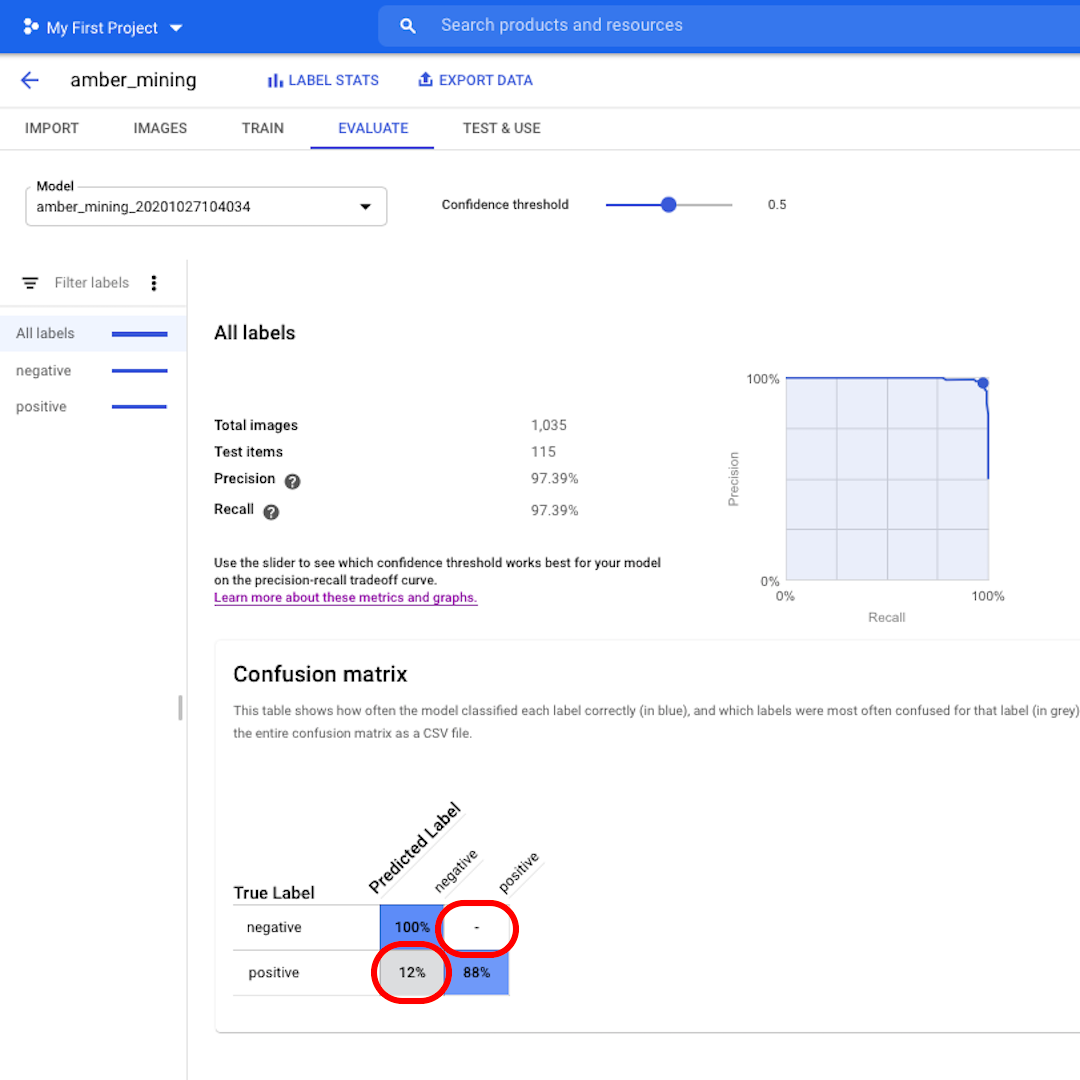

Ensuite, voyons la matrice de confusion. Plus les scores sont élevés sur fond bleu, plus le modèle est bon. Dans cet exemple, les scores sont très bons.

Toutes les images qui auraient dû être étiquetées comme négatives (pas d’extraction d’ambre) ont été reconnues par le modèle et 88 % des images qui comportaient des traces d’extraction d’ambre ont été correctement étiquetées comme telles.

Nous n’avons pas de faux positifs - aucune image n’a été étiquetée à tort comme exemple d’extraction d’ambre - et seulement 12 % de faux négatifs : des images montrant des traces d’extraction d’ambre que le modèle n’a pas reconnues.

Il s’agit d’un élément probant pour notre enquête sur l’exploitation illégale de l’ambre : mieux vaut passer à côté de quelques exemples positifs que d’apporter comme preuve de l’exploitation de l’ambre des images qui ne l’indiquent pas clairement.

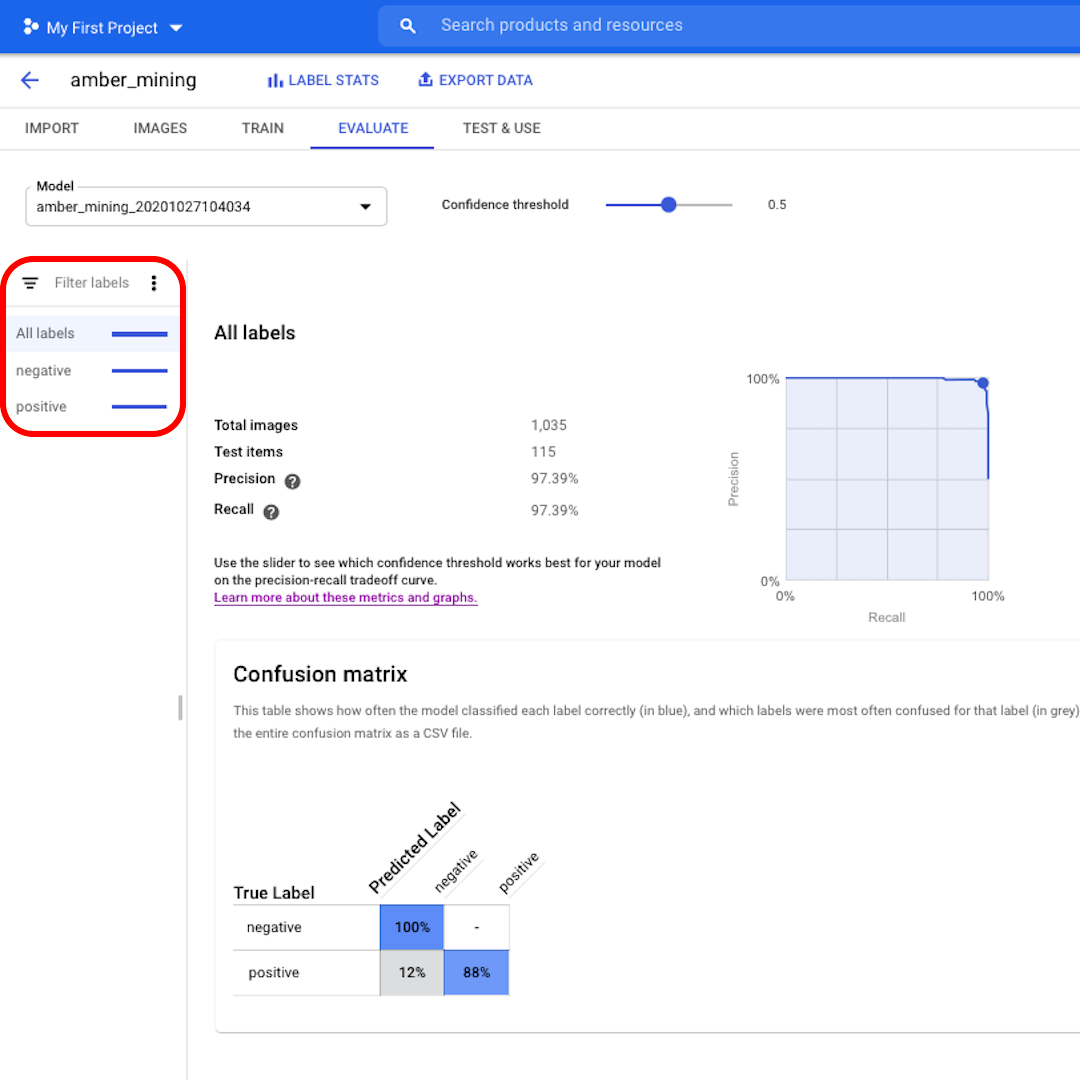

Cliquez sur les filtres de gauche pour voir quelles images de test ont été correctement ou incorrectement classées par le modèle.

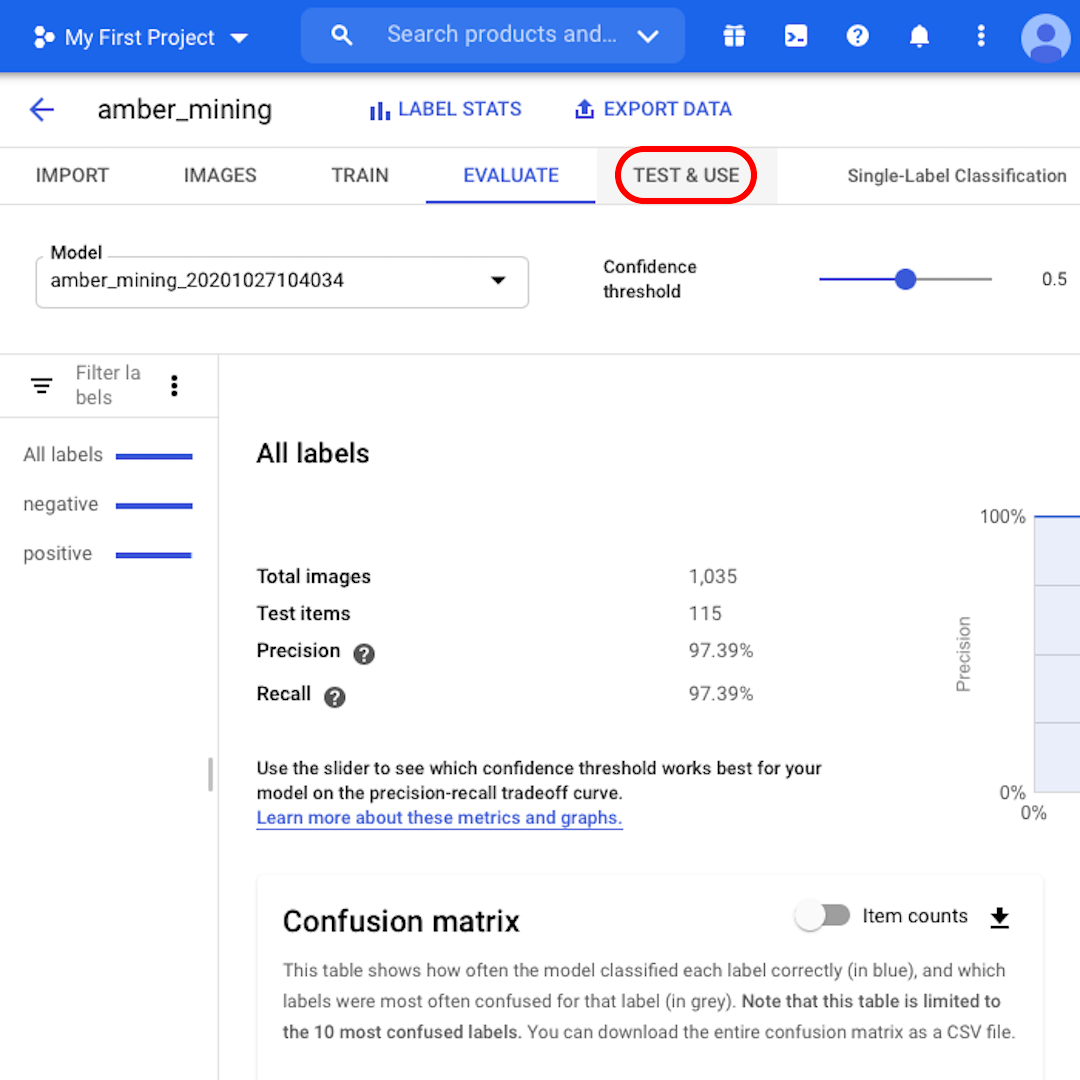

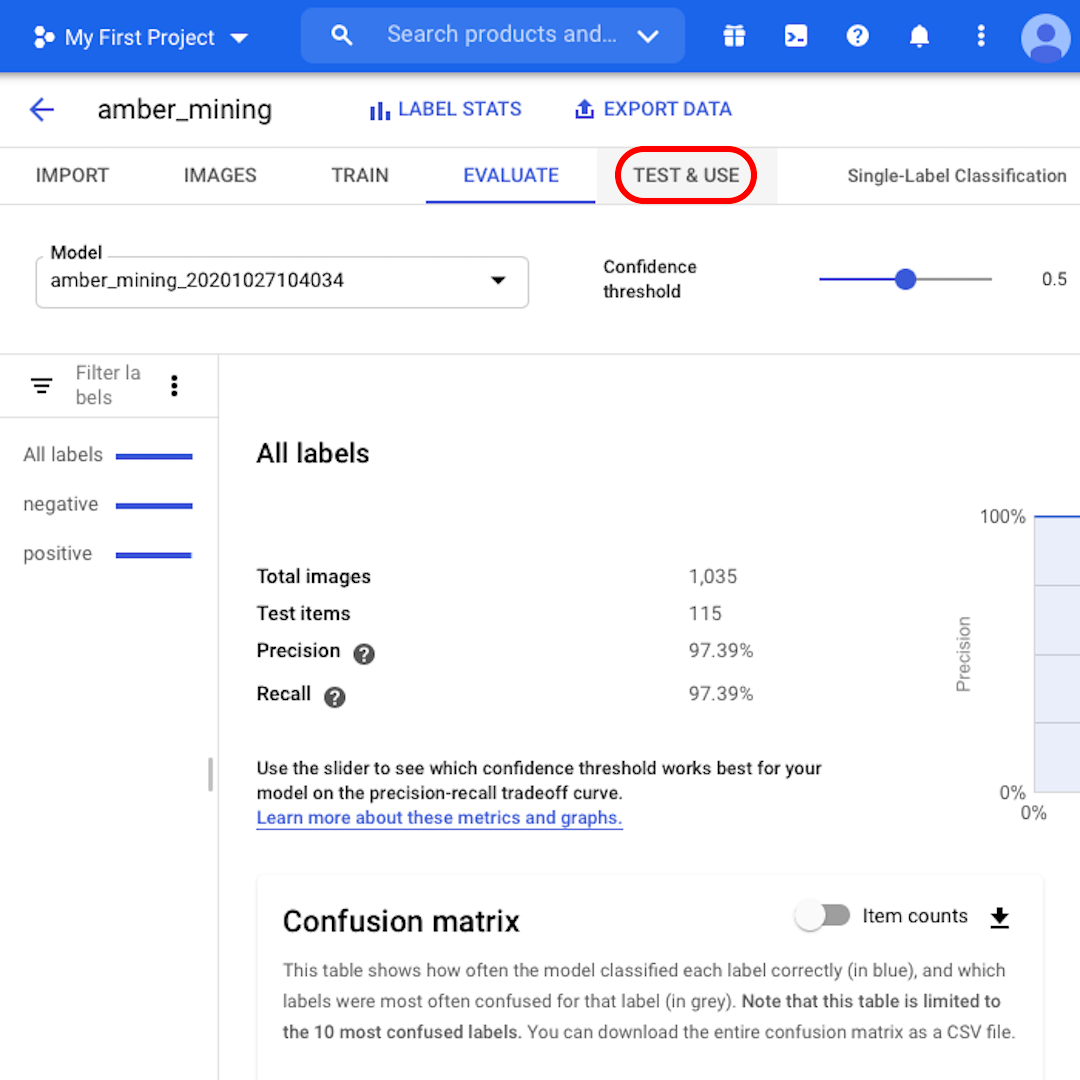

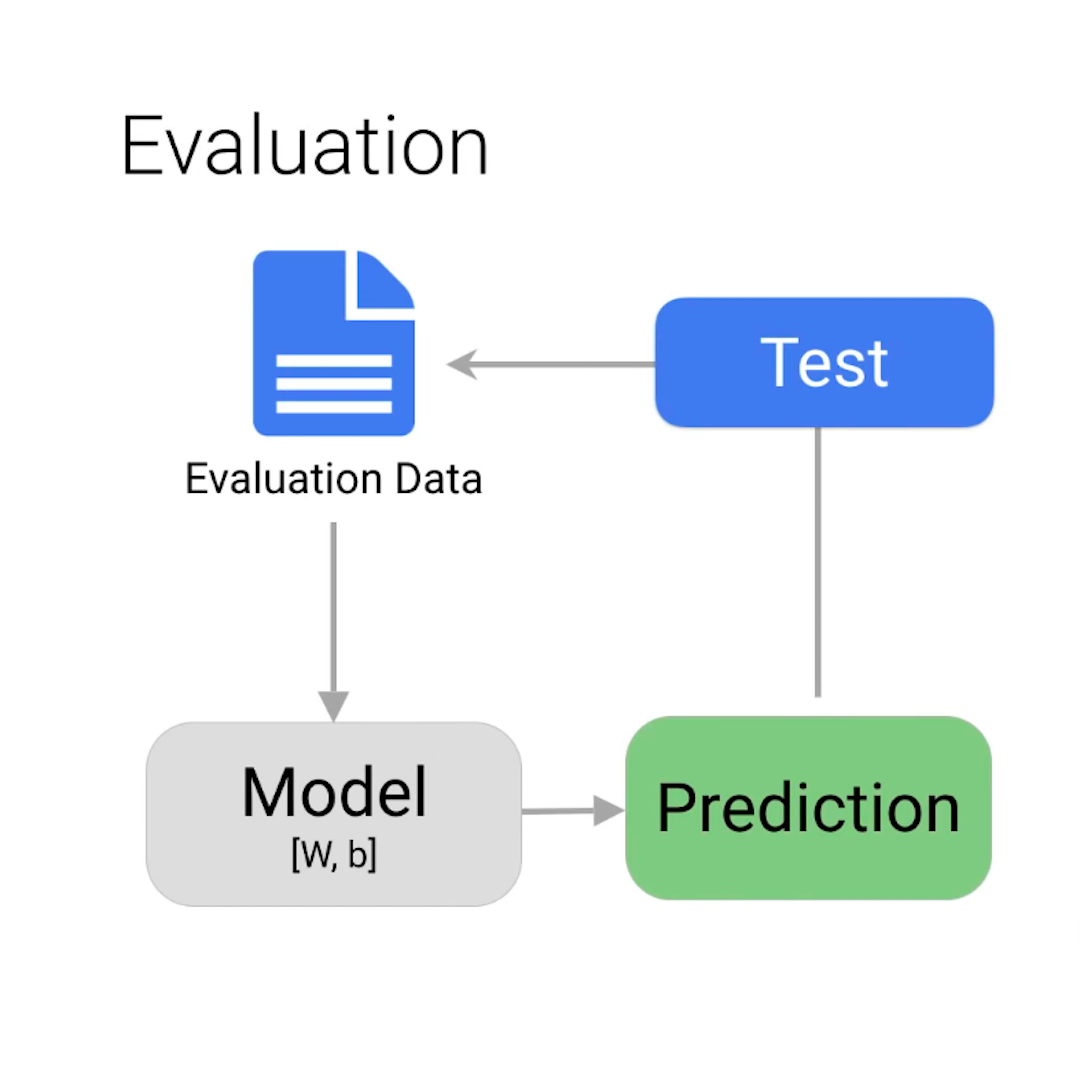

Vous ne savez pas encore si vous pouvez vous fier au modèle ? En cliquant sur « Tester et utiliser », vous pouvez télécharger de toutes nouvelles images satellites - avec ou sans traces d’extraction d’ambre - pour voir si le modèle les classe correctement.

Tester et s’entraîner à nouveau

Quelques considérations finales avant de conclure :

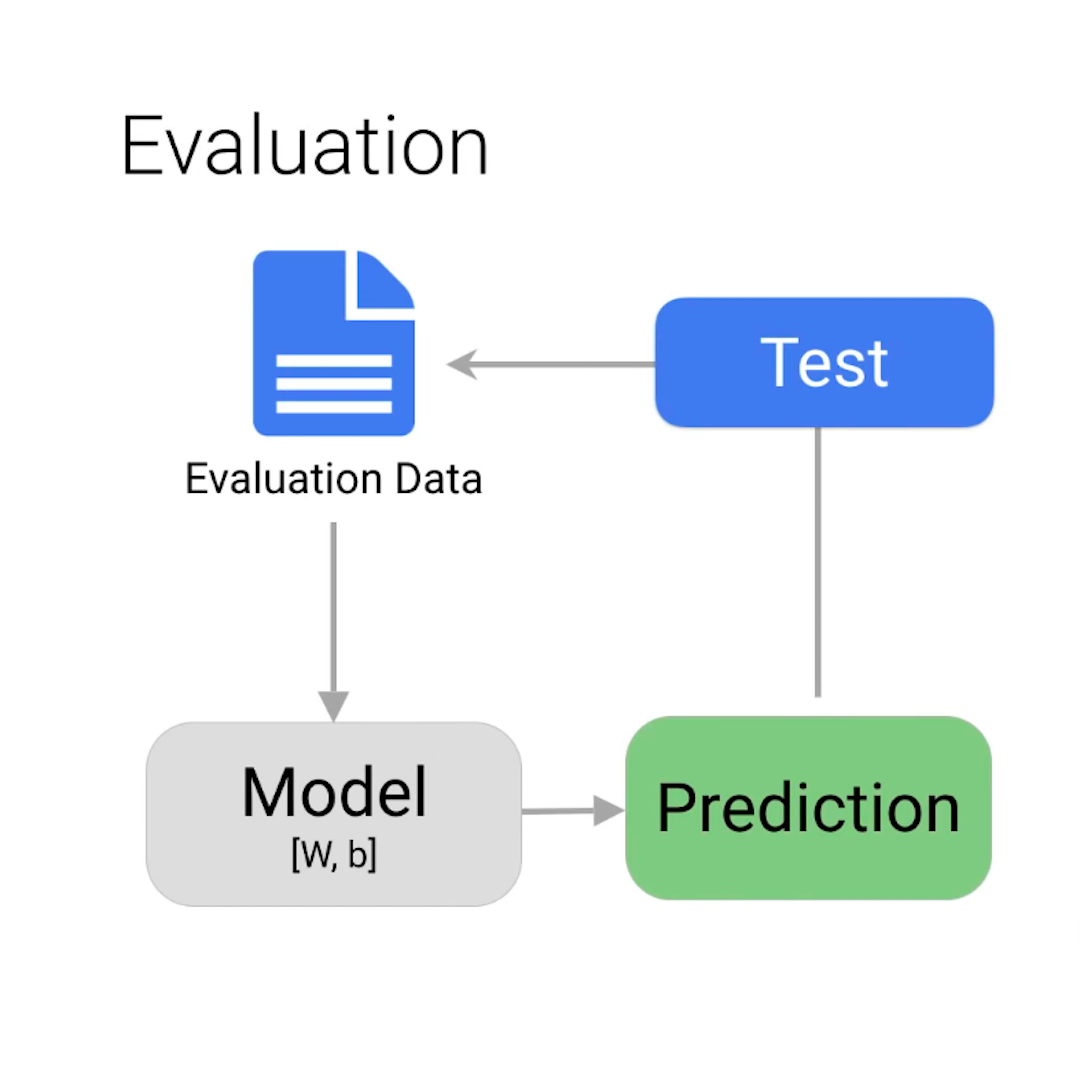

Vous vous demandez peut-être comment le modèle obtient quelques mauvaises réponses alors que nous lui avons donné toutes les bonnes réponses au départ. Le cas échéant, vous voudrez peut-être revoir la répartition entre la formation, la validation et les tests décrits dans la leçon précédente.

Pour cet exemple, presque toutes les images ont été classées correctement. Mais ce ne sera pas toujours le cas. Si vous n’êtes pas satisfait des performances de votre modèle, vous pouvez toujours mettre à jour et améliorer votre ensemble de données et former à nouveau le modèle. Vous pourriez analyser soigneusement ce qui n’a pas fonctionné lors de la première itération et, par exemple, ajouter à votre ensemble de formation davantage d’images similaires à celles qui ont été mal classées par le modèle.

Comme pour les humains, l’apprentissage est un processus itératif.

-

Vidéo : Renforcer la sécurité des journalistes en ligne

LeçonEn tant que journaliste, renforcez votre sécurité en ligne à l'aide des bonnes pratiques et des outils de Google. -

Créer des applications d'actualités avec Flutter

LeçonPassez jusqu'à 80 % de temps en moins à développer vos applications. -

Global Fishing Watch : Surveillez les flottes et navires de pêche

LeçonUn guide d’utilisation de l’outil de cartographie de Global Fishing Watch pour surveiller l’activité de pêche mondiale.