La partialité dans le "Machine Learning"

L’équité dans le Machine Learning

Jusqu’à présent, ce cours a montré comment le Machine Learning peut améliorer votre travail, en vous faisant gagner un temps précieux sur des tâches existantes ou en vous ouvrant de nouvelles possibilités. Le Machine Learning peut faire beaucoup pour vous, mais il s’accompagne de défis que vous ne devez pas prendre à la légère.

Pour relever ces défis, un nombre croissant de chercheurs et de spécialistes se concentrent sur le thème de l’« équité » dans le Machine Learning. Selon son principe directeur, le Machine Learning doit profiter à tous de manière égale, indépendamment des catégories sociales qui structurent et influencent nos vies.

Qu’est-ce qu’un préjugé? Qu’est-ce que la partialité?

Quelles sont les conséquences négatives qui pourraient découler de l’utilisation du Machine Learning ? La réponse courte est celle-ci : la partialité

En tant qu’êtres humains, nous avons tous nos préjugés. Ce sont des outils que notre cerveau utilise pour traiter les informations qui lui sont soumises chaque jour.

Prenons cet exemple : fermez les yeux et imaginez une chaussure. Vous avez probablement imaginé une basket. Peut-être une chaussure d’homme en cuir. Il est moins probable que vous ayez pensé à une chaussure de femme à talon haut. Nous ne savons peut-être même pas vraiment pourquoi, mais chacun d’entre nous a un préjugé favorable à une chaussure plutôt qu’à une autre.

Imaginez maintenant que vous vouliez apprendre à un ordinateur à reconnaître une chaussure. Vous risquez de l’influencer avec vos propres préjugés. C’est ainsi qu’ils se reproduisent dans le Machine Learning. Même avec de bonnes intentions, il est impossible de se défaire de ses propres préjugés.

Trois types de préjugés

Nos propres préjugés risquent de s’intégrer de différentes manières à la technologie que nous créons :

Les préjugés d’interaction

Prenons l’exemple précédent : si nous formons un modèle à reconnaître des chaussures avec un ensemble de données comprenant principalement des photos de baskets, le système n’apprendra pas à reconnaître les talons hauts comme des chaussures.

Les préjugés latents

Si vous formez un système de Machine Learning sur l’apparence d’un scientifique en utilisant des photos de scientifiques célèbres du passé, votre algorithme apprendra probablement à associer les scientifiques aux hommes uniquement.

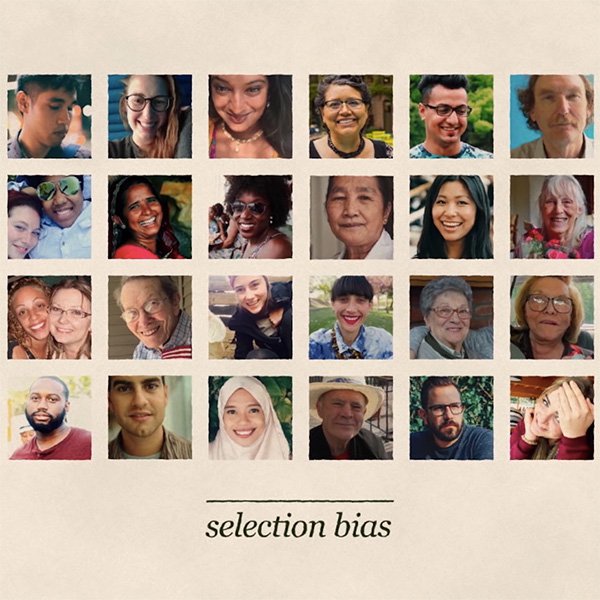

Les préjugés de sélection

Supposons que vous formiez un modèle à reconnaître les visages. Si les données que vous utilisez pour le former représentent trop une population, il fonctionnera mieux pour cette catégorie aux dépens des autres, avec des conséquences potentiellement racistes.

Que pouvons-nous donc faire pour éviter ces préjugés?

Poser les bonnes questions pour éviter les préjugés

En tant que journaliste, une première ligne de défense contre les préjugés est fermement à votre portée : les mêmes valeurs et principes éthiques que vous appliquez chaque jour dans votre profession doivent s’étendre à l’évaluation de l’équité de toute nouvelle technologie qui s’ajoute à votre boîte à outils. L’apprentissage automatique ne fait pas exception à la règle.

En outre, dans tous les cas, vous devez commencer par déterminer si les conséquences peuvent avoir un impact négatif sur les possibilités économiques ou autres opportunités importantes de la vie des individus. Cette démarche est essentielle, surtout si les données utilisées contiennent des données personnelles sensibles.

Souvent, l’impact injuste n’est pas immédiatement évident, mais il exige de poser des questions sociales, politiques et éthiques nuancées sur la façon dont votre système de Machine Learning pourrait permettre à des préjugés de s’installer.

Prendre en compte les principales sources de partialité

Bien qu’aucune donnée de formation ne soit parfaitement « impartiale », vous pouvez améliorer considérablement vos chances de construire un modèle équitable si vous examinez attentivement les sources potentielles de préjugés (ou biais) dans vos données et si vous prenez des mesures visant à y remédier.

Les préjugés s’installent le plus souvent lorsque les données relatives à la formation ne sont pas vraiment représentatives de la population sur laquelle votre modèle formule des prédictions. Vous devez disposer de suffisamment de données pour chaque groupe pertinent.

Un autre type de préjugé se manifeste lorsque certains groupes sont représentés de manière moins positive que d’autres dans les données de formation. Vous devez donc envisager de revoir vos données avant de les utiliser pour former un modèle, et ainsi vérifier si elles ne sont pas porteuses de préjugés susceptibles d’être assimilés et ensuite reproduits par l’algorithme.

Prévenir les préjugés : tout commence par la prise de conscience

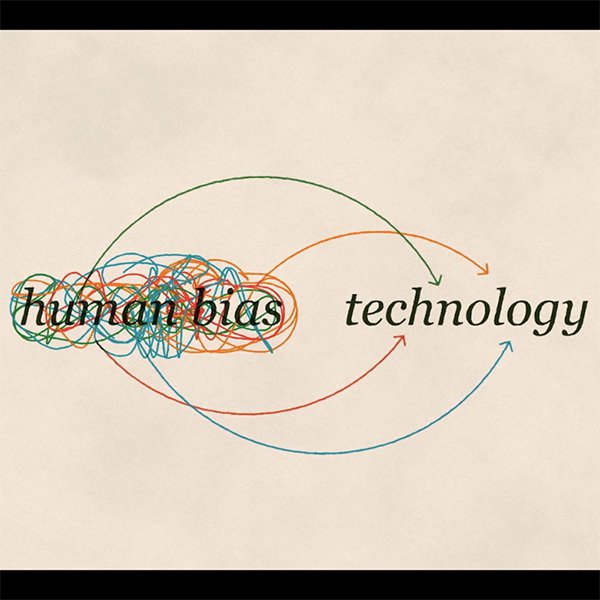

Les préjugés peuvent naître de diverses façons : à partir des ensembles de données de formation, selon les décisions prises lors du développement d’un système de Machine Learning, et par le biais de boucles de rétroaction complexes qui surviennent lorsqu’un système d’apprentissage est déployé dans le monde réel.

Voici quelques questions concrètes que vous pourriez poser afin de reconnaître les préjugés potentiels :

- Dans quel but les données ont-elles été collectées ?

- Comment les données ont-elles été collectées ?

- Quel objectif l’utilisation de cet ensemble de données et de cet algorithme particulier vise-t-il ?

- Comment la source des données a-t-elle été évaluée ?

- Comment le processus d’analyse des données a-t-il été défini avant l’analyse elle-même ?

La partialité est une question complexe et il n’existe aucune solution miracle. La solution commence par une prise de conscience, une connaissance des risques encourus et la prise de mesures efficaces visant à les minimiser.

-

Source de données : Election Databot.

LeçonUn outil pour aider les journalistes à couvrir les élections américaines. -

-

Looking ahead to ML-powered journalism

LeçonKey learnings and recommended resources to deepen your ML knowledge.