Valutazione e test

Come interpretare l'output del tuo modello e valutarne le prestazioni

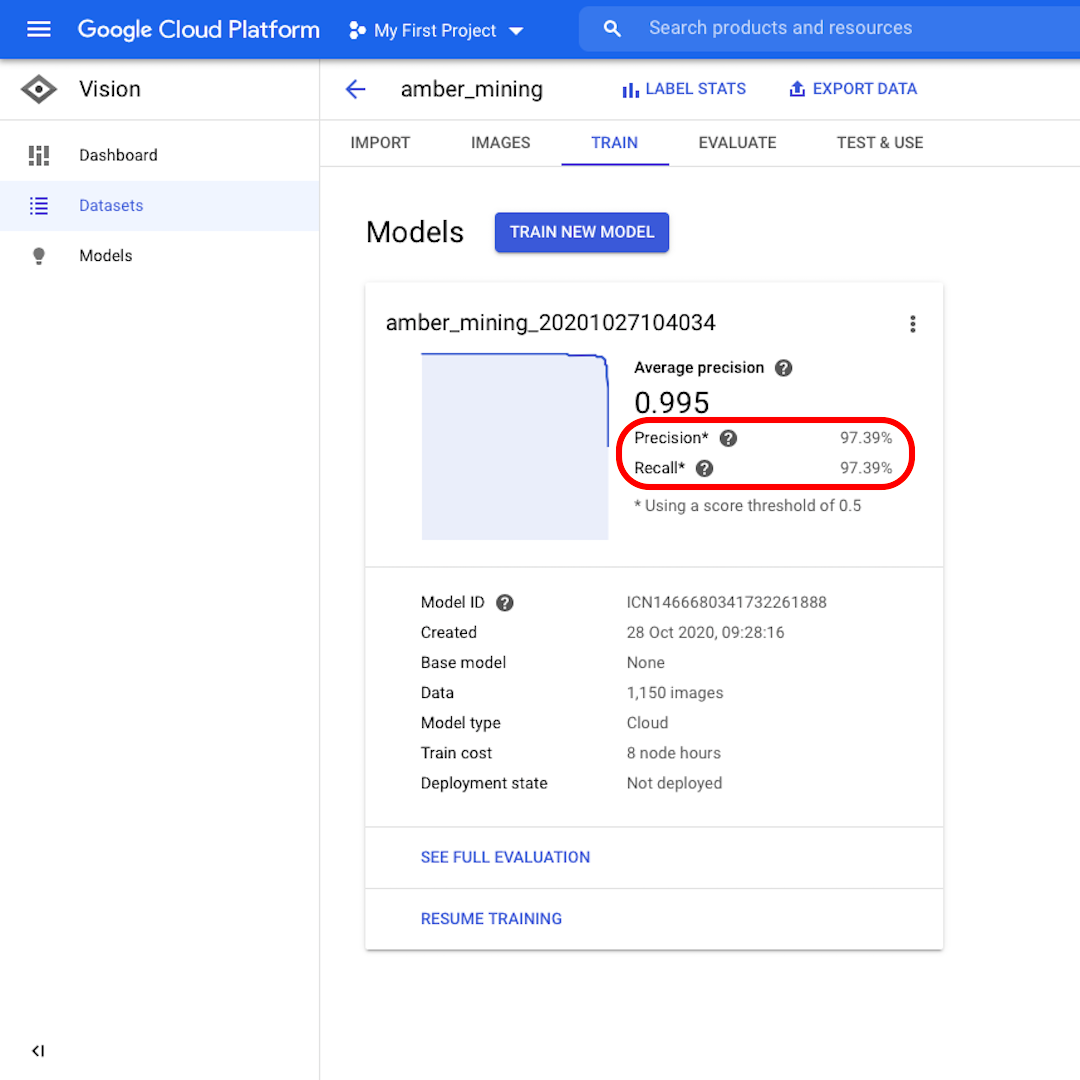

Precisione e richiamo

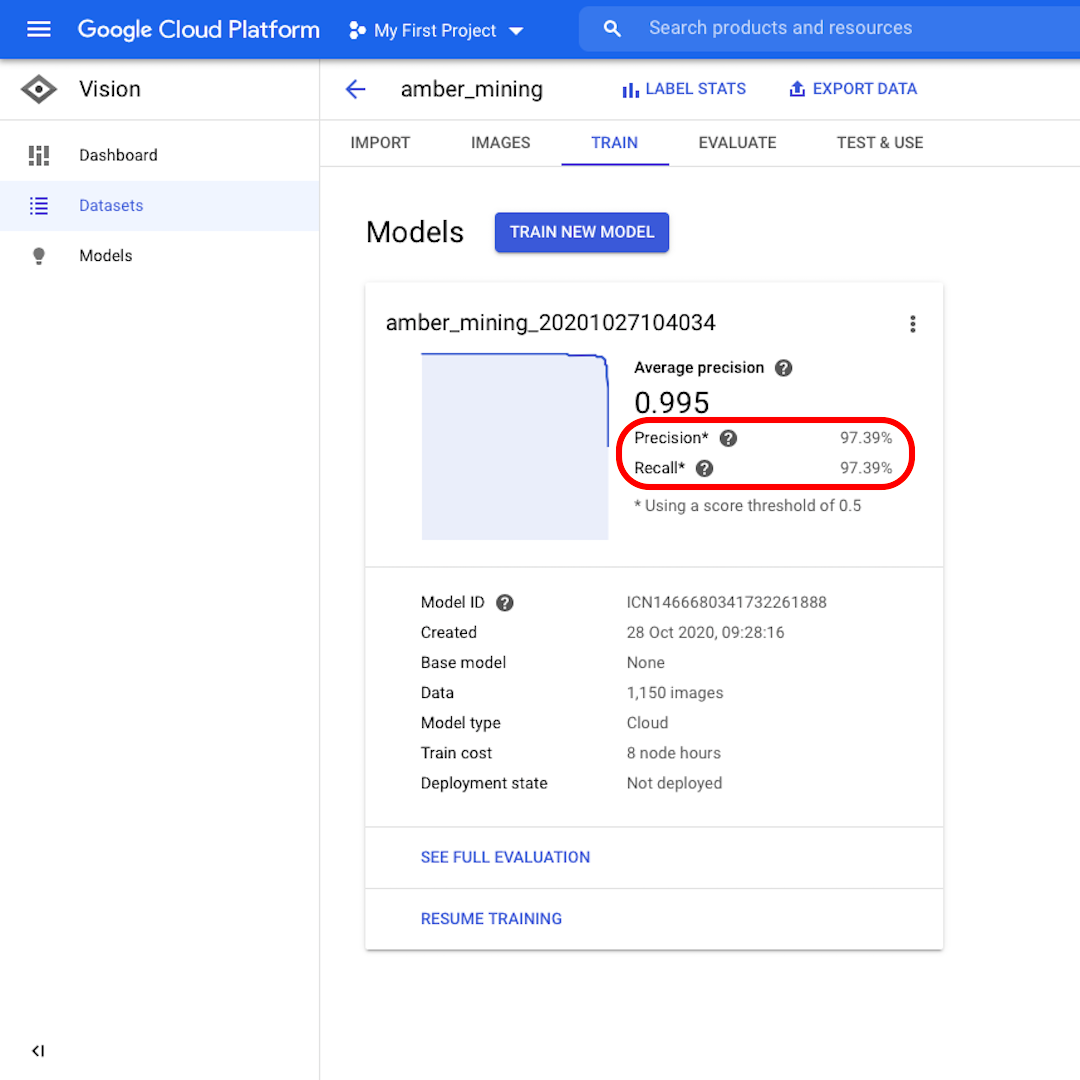

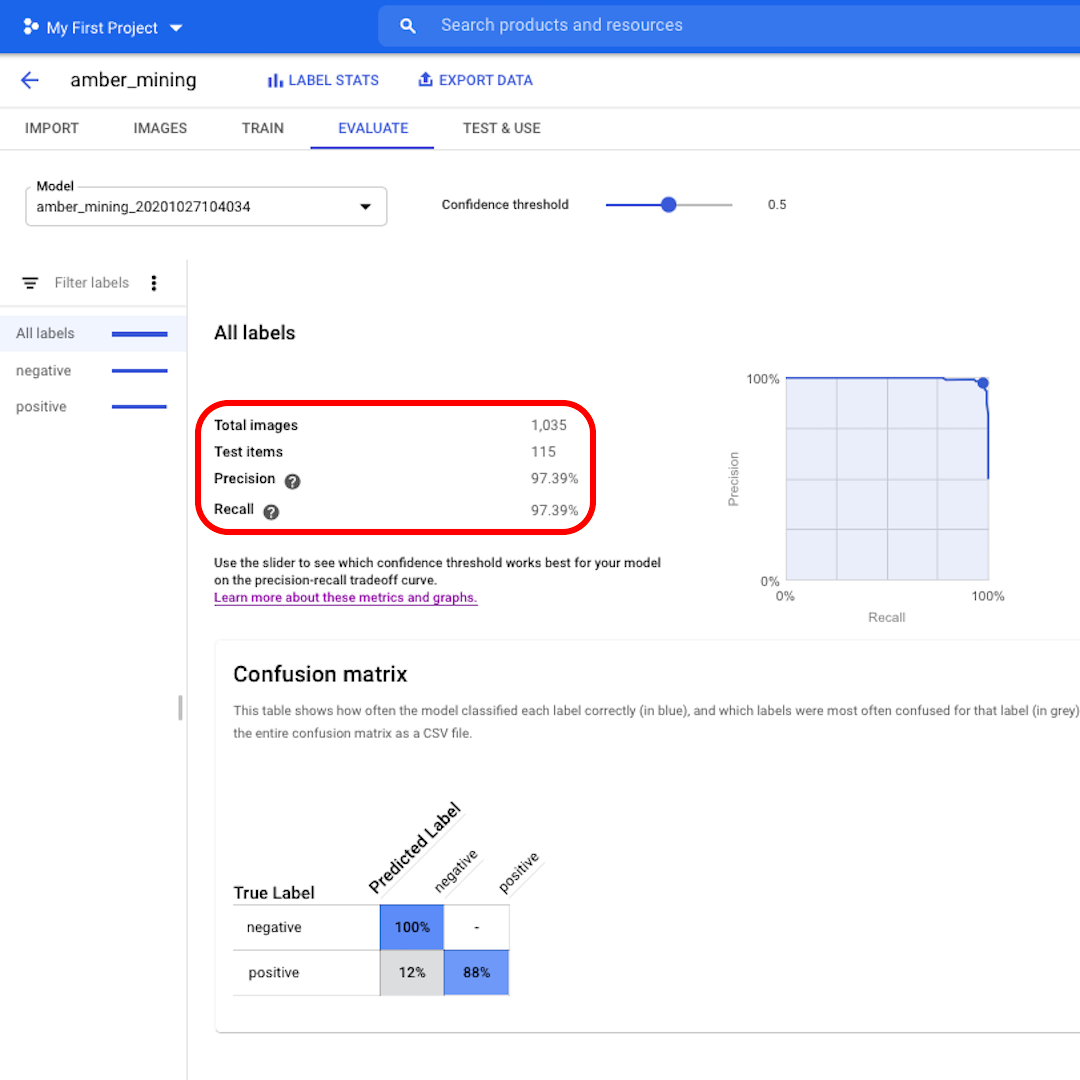

Una volta addestrato il modello, verrà visualizzato un riepilogo delle prestazioni con i punteggi in base alla "Precisione" e al "Richiamo".

La precisione ci dice quale proporzione delle immagini identificate come positive dal modello avrebbero dovuto essere classificate come tali. Il richiamo invece ci dice quale percentuale di immagini positive effettive è stata identificata correttamente.

Il nostro modello si è comportato molto bene in entrambe le categorie, con punteggi superiori al 97%. Vediamo più in dettaglio cosa significa.

Valuta le prestazioni del modello

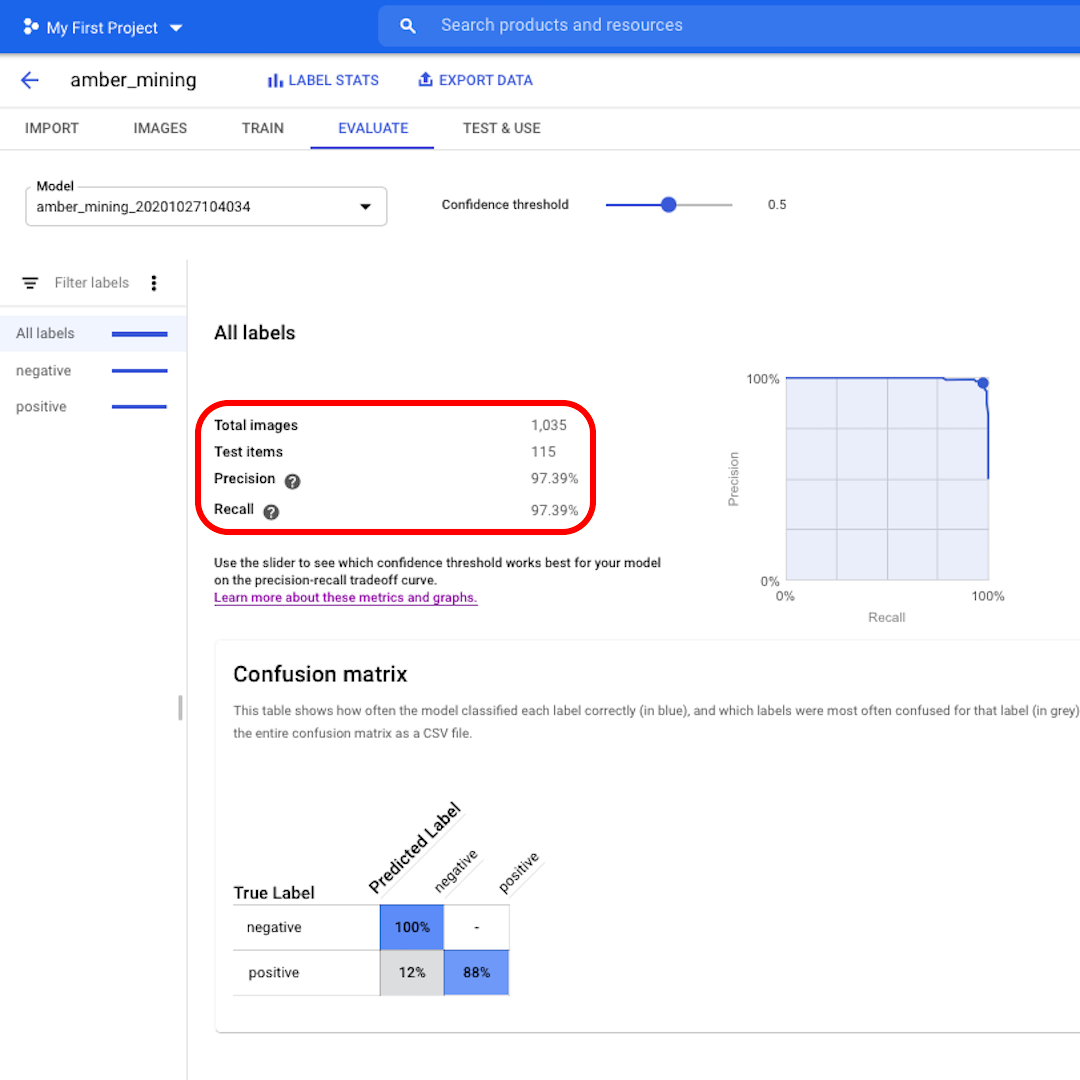

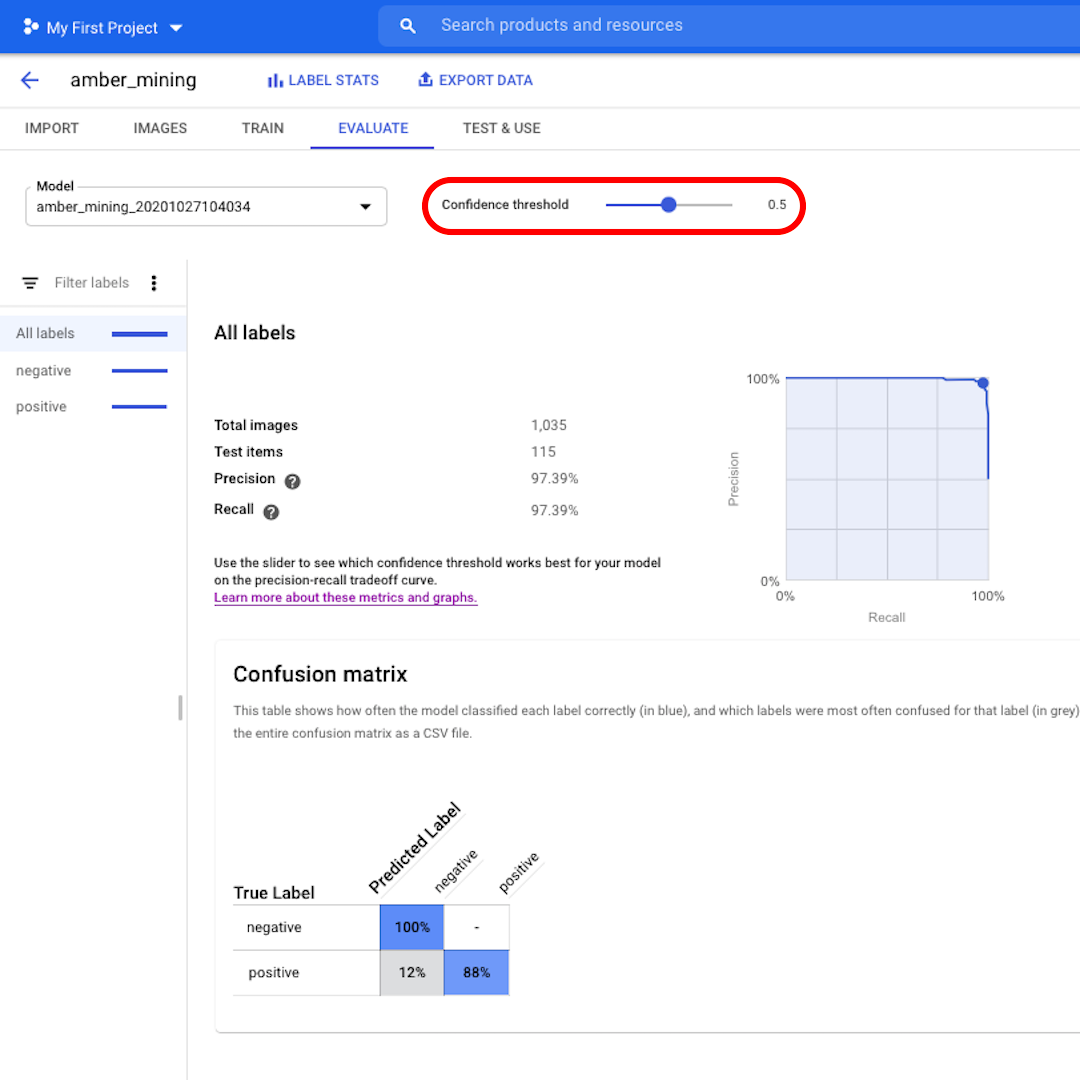

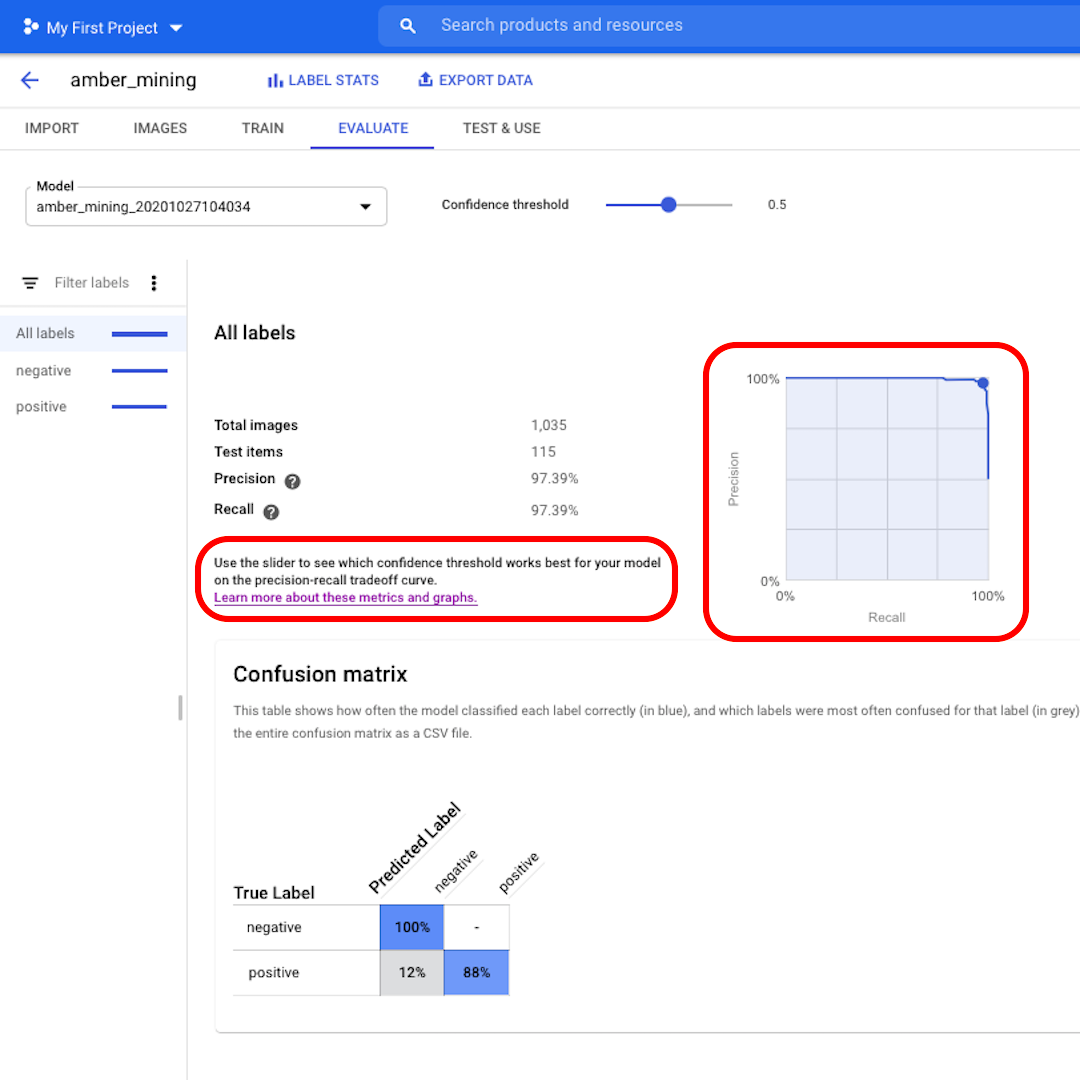

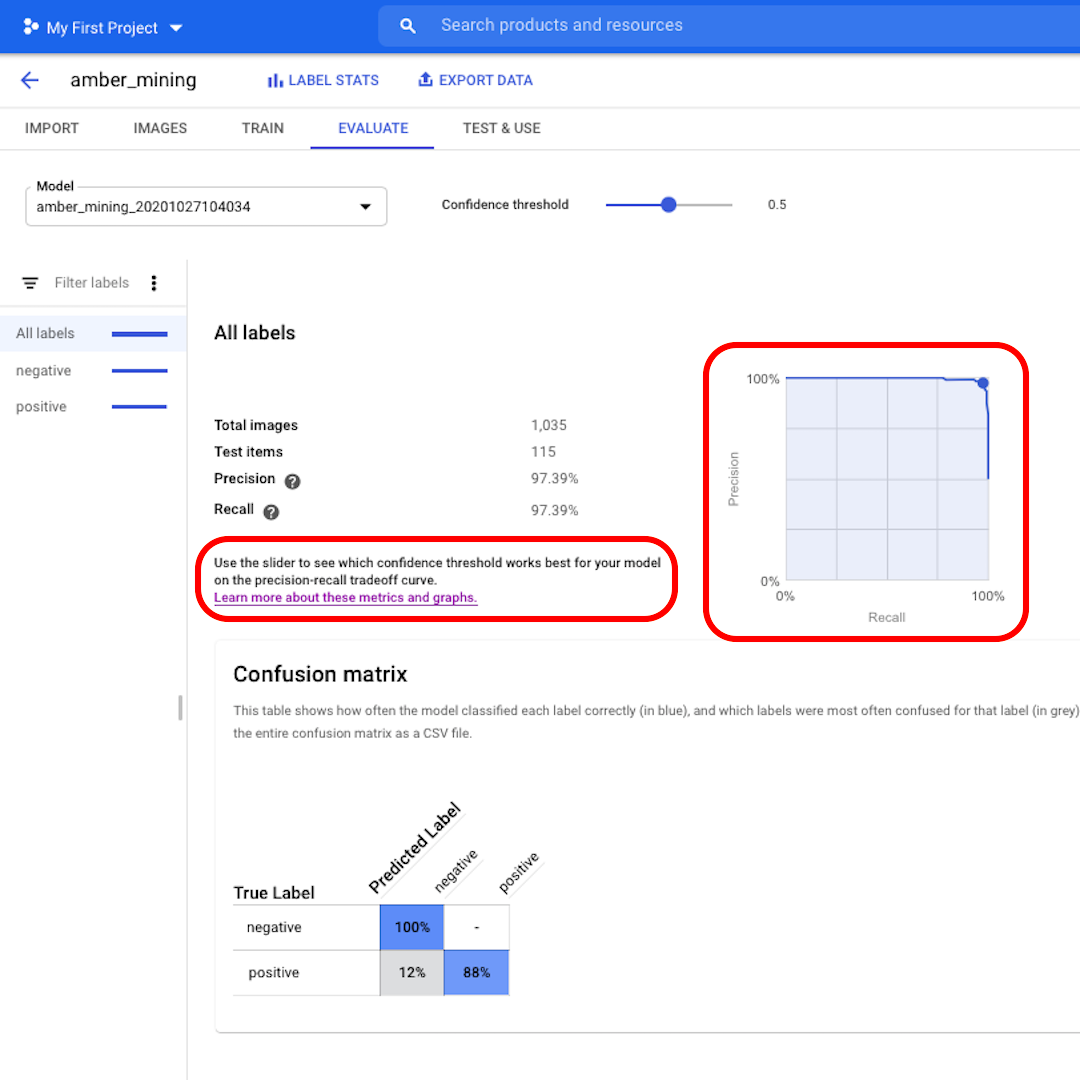

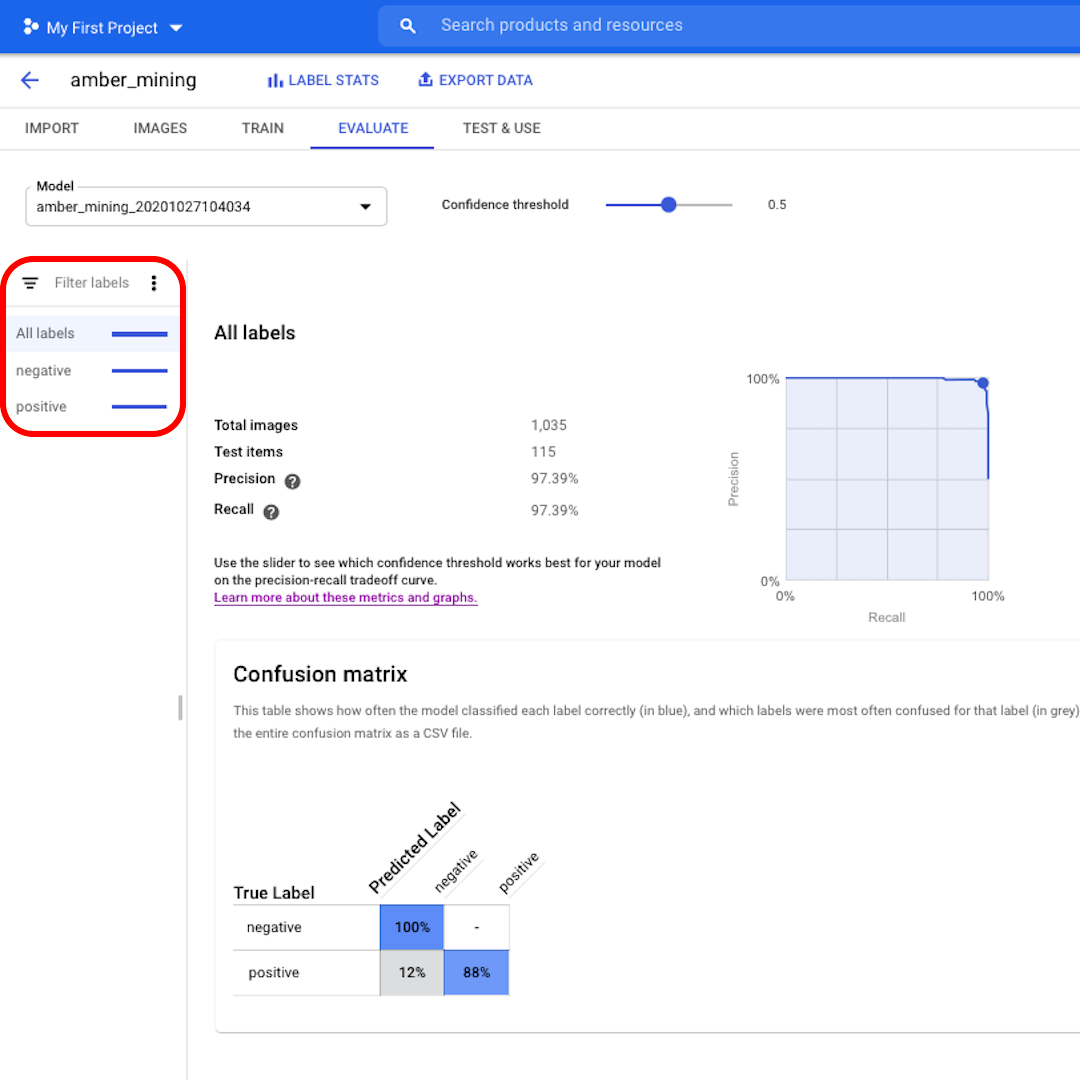

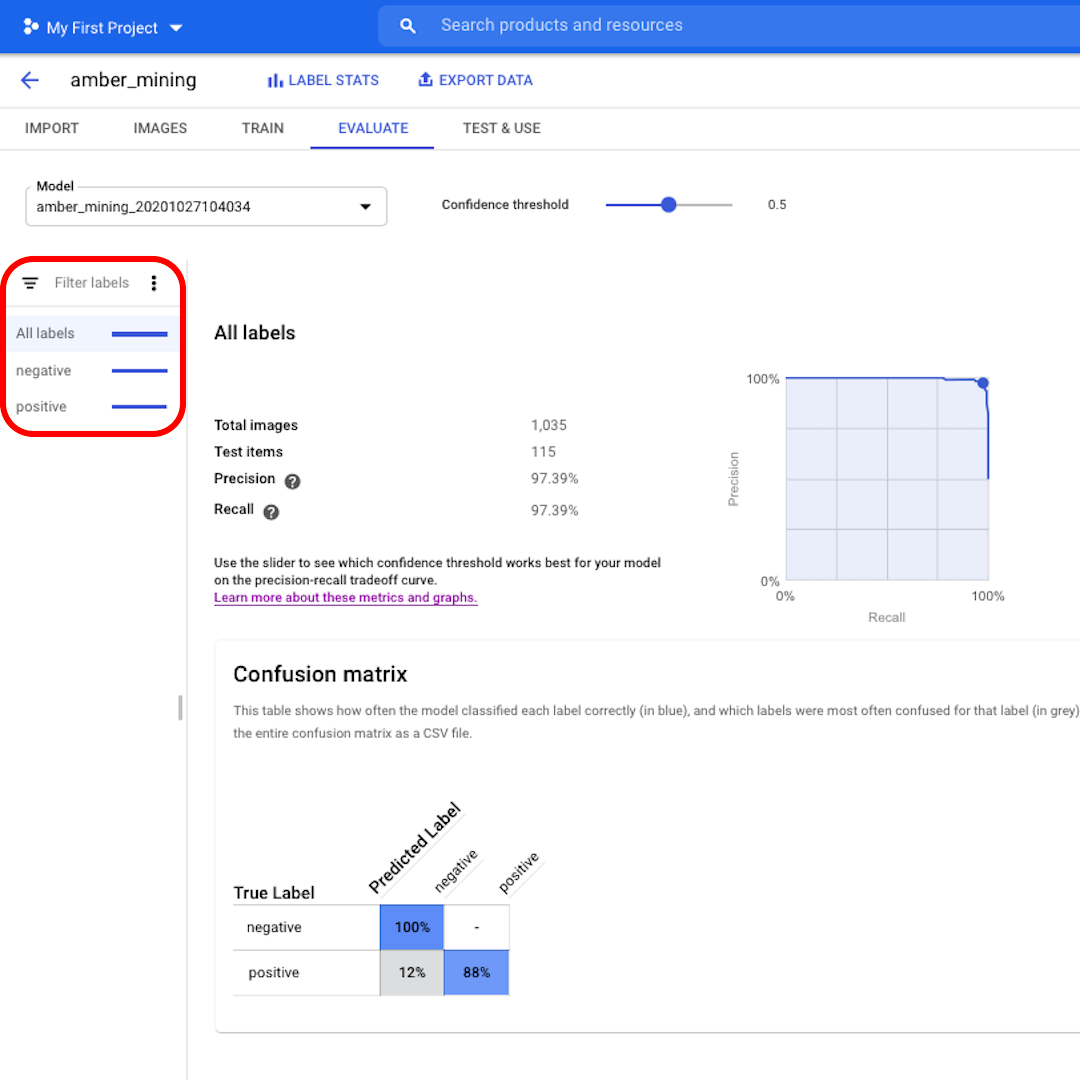

Clicca su "Valuta" nel menu in alto ed esploriamo l'interfaccia. Innanzitutto, ci mostra di nuovo i punteggi sulla precisione e sul richiamo. Nel nostro caso, il punteggio di precisione ci dice che il 97% delle immagini di prova che il modello ha identificato come esempi di estrazione dell'ambra mostrava effettivamente tracce di estrazione dell'ambra.

Il punteggio di richiamo invece ci dice che il 97% delle immagini di prova che mostrano esempi di estrazione dell'ambra sono state correttamente etichettate come tali dal modello.

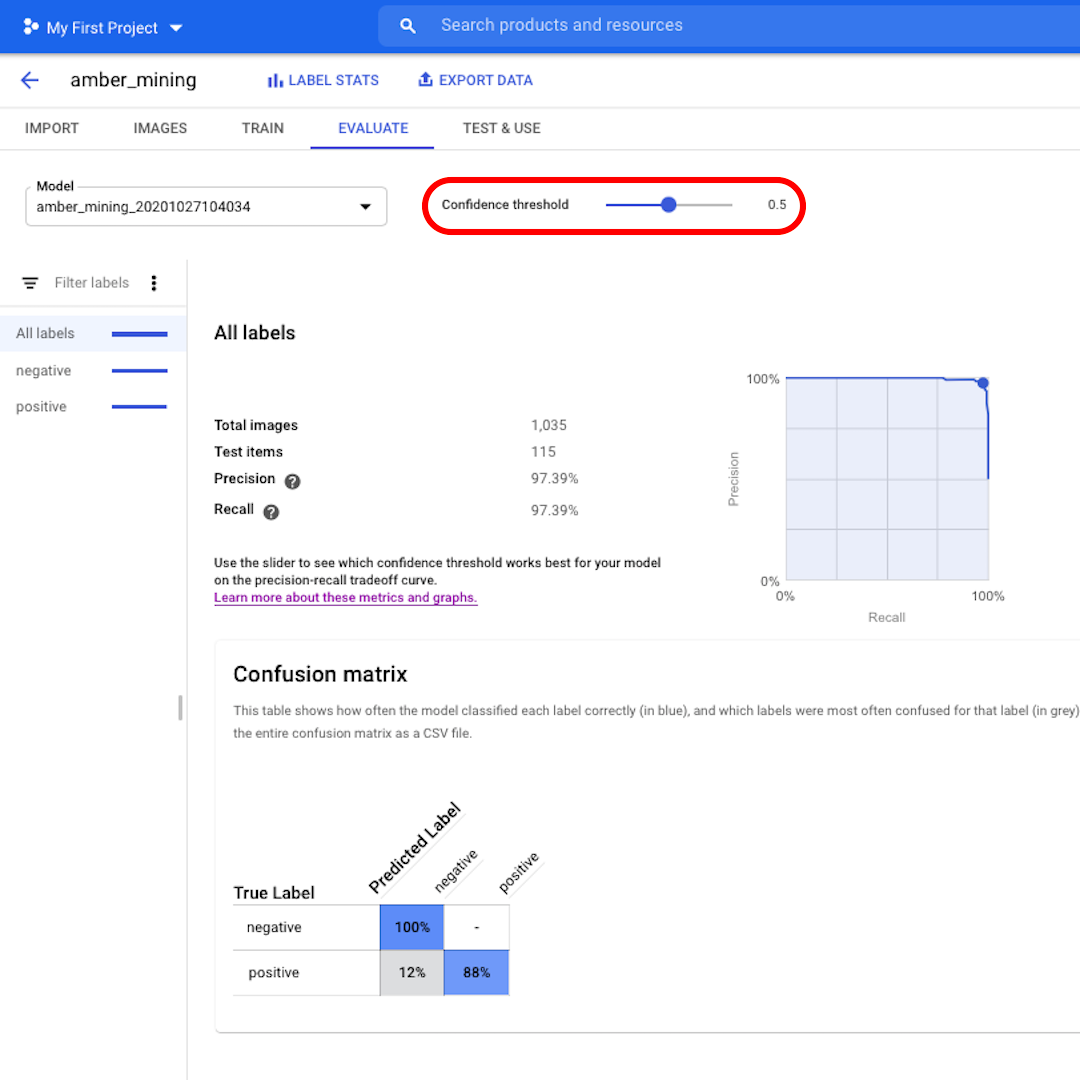

La soglia di confidenza è il livello di fiducia che il modello deve avere per assegnare un'etichetta. Più è basso, più immagini verranno classificate dal modello, ma maggiore sarà il rischio di classificare erroneamente alcune immagini.

Se vuoi approfondire ed esplorare anche le curve di richiamo e di precisione, scopri di più seguendo il link sull'interfaccia.

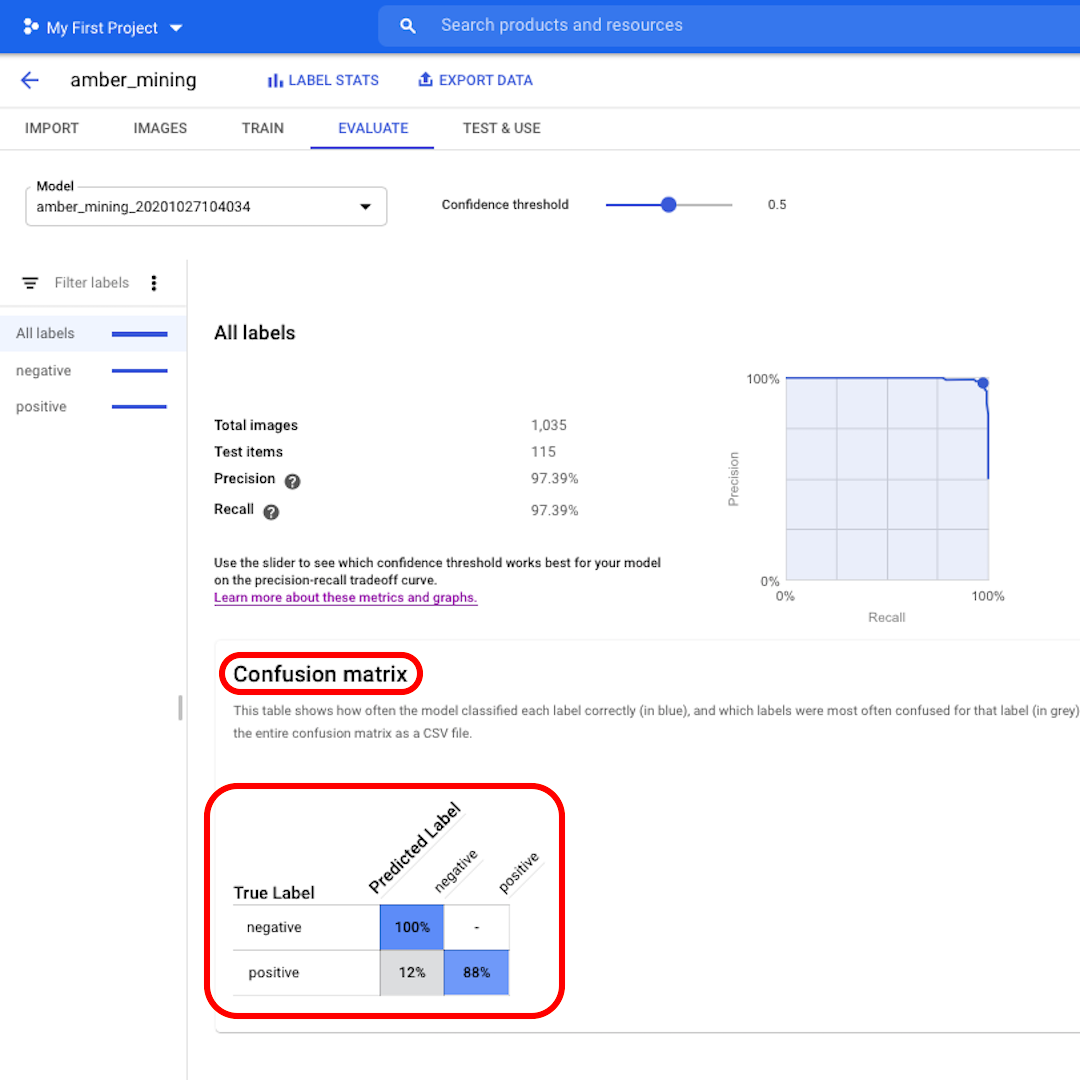

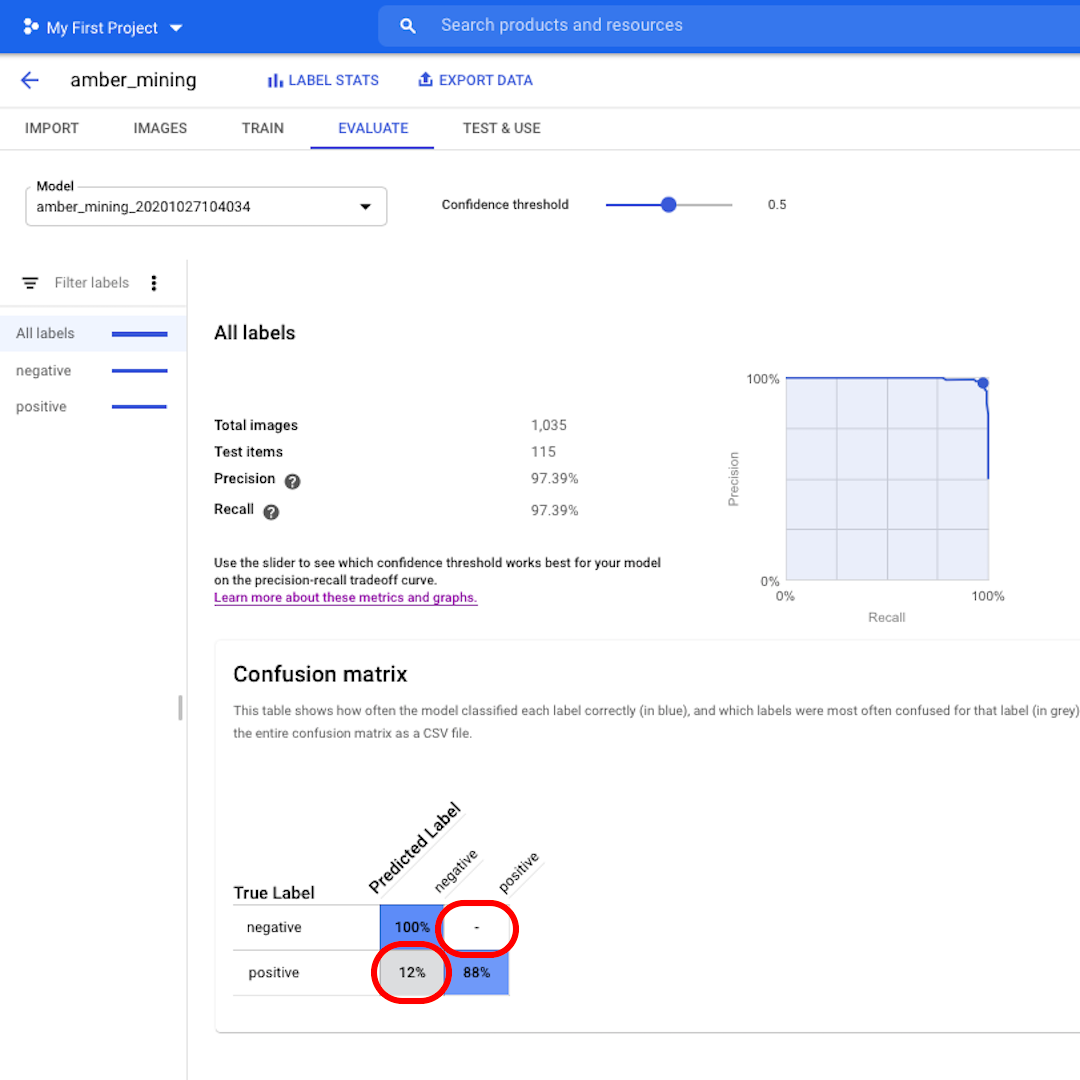

Falsi positivi e falsi negativi

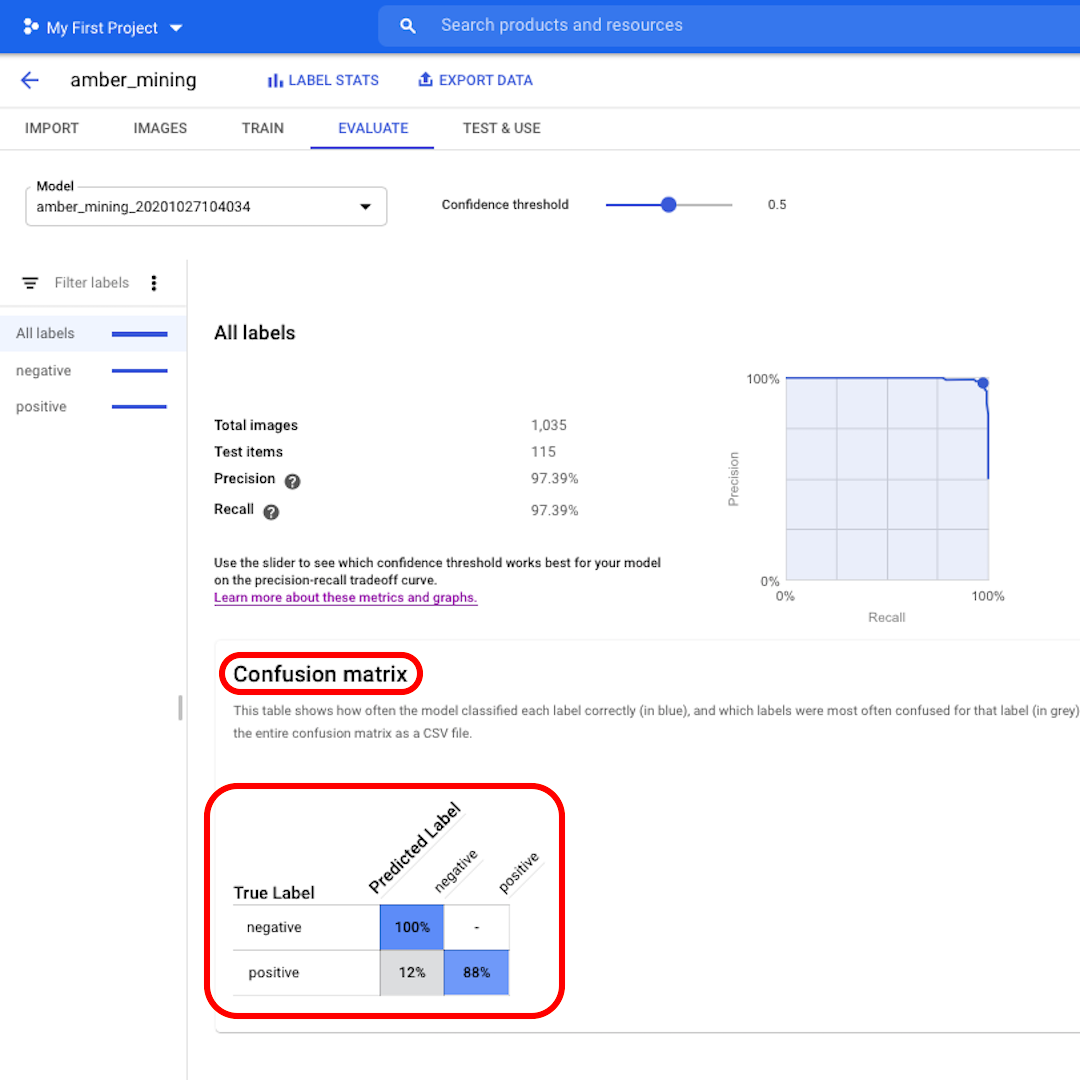

. Più alto è il punteggio su sfondo blu, migliori saranno le prestazioni del modello. In questo esempio, i punteggi sono molto buoni.

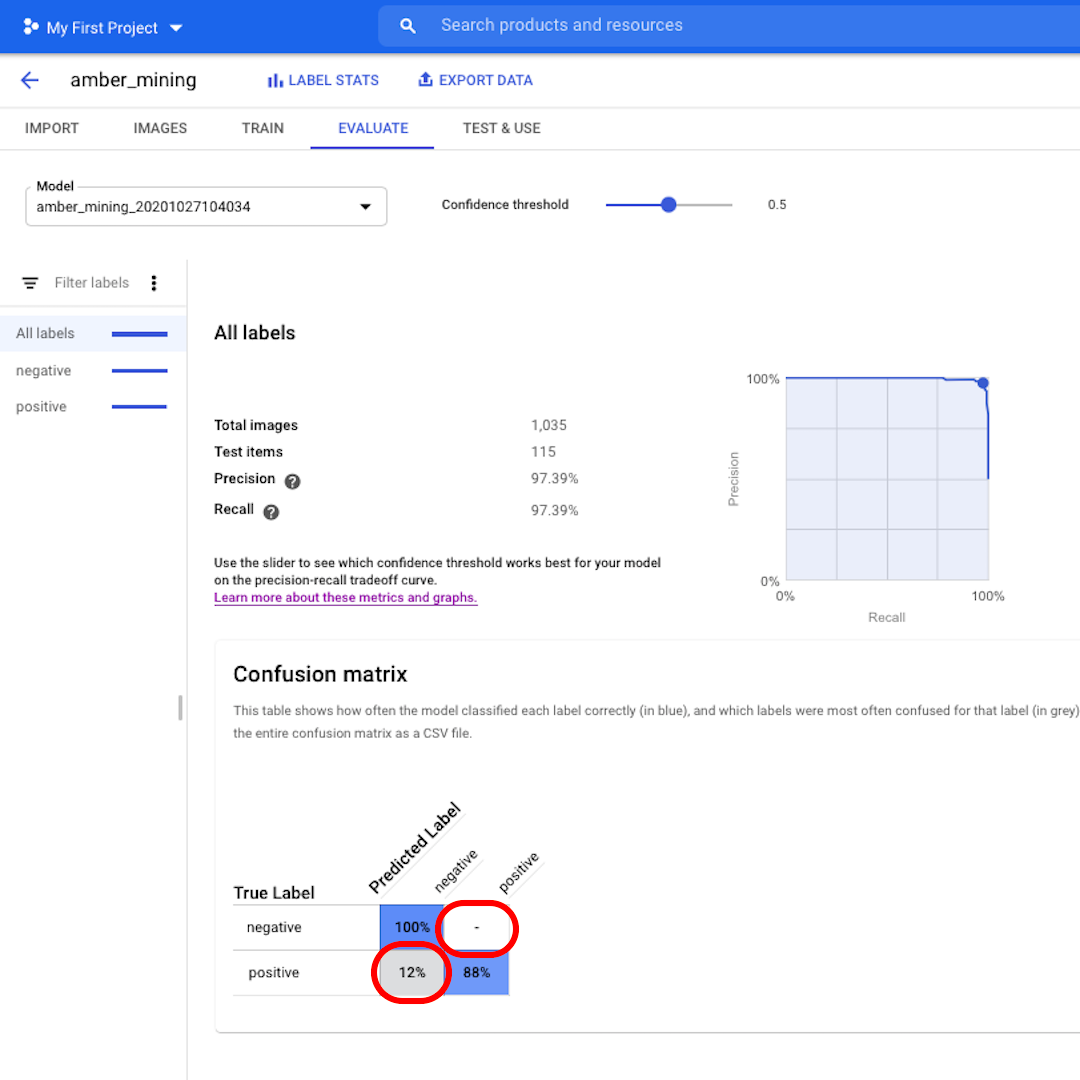

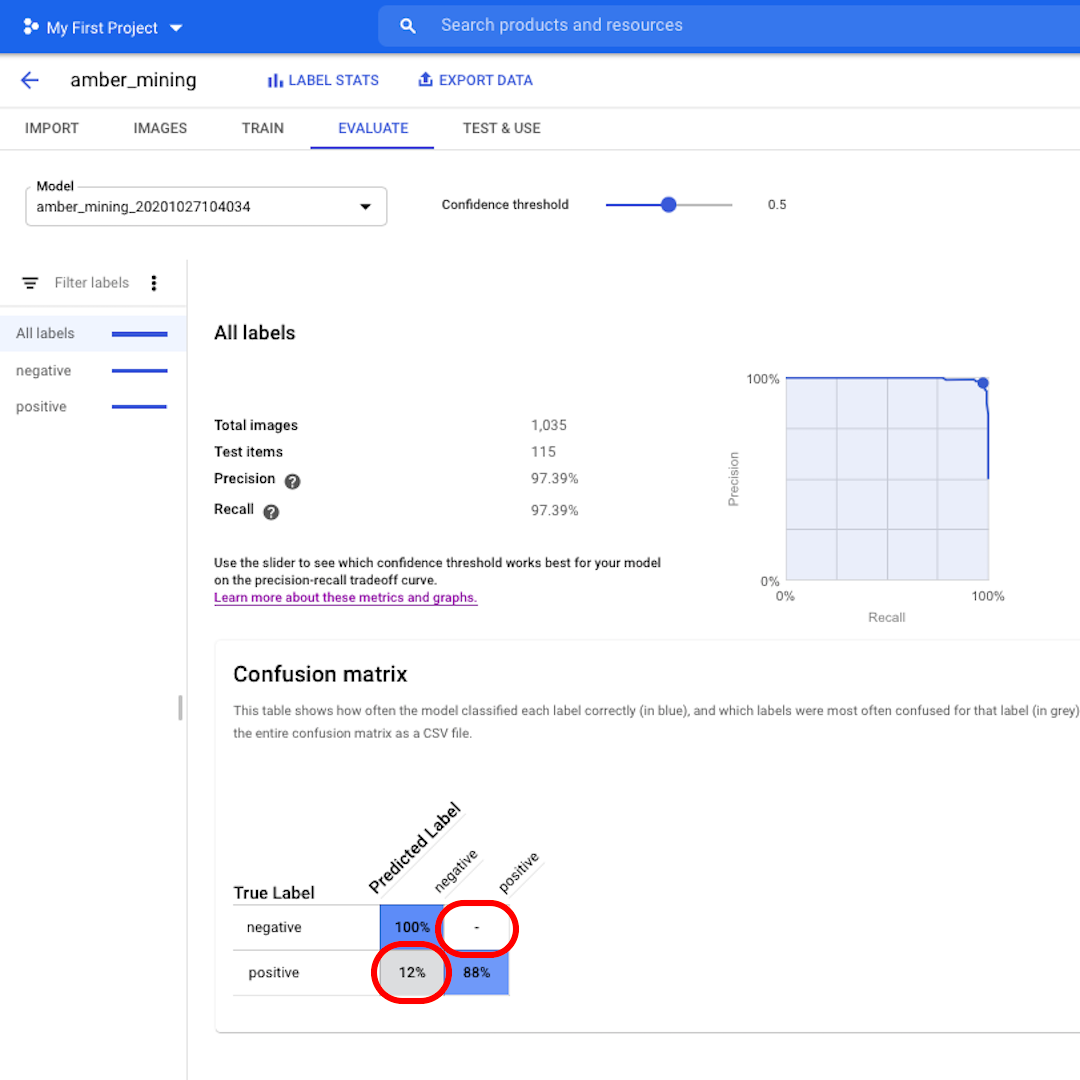

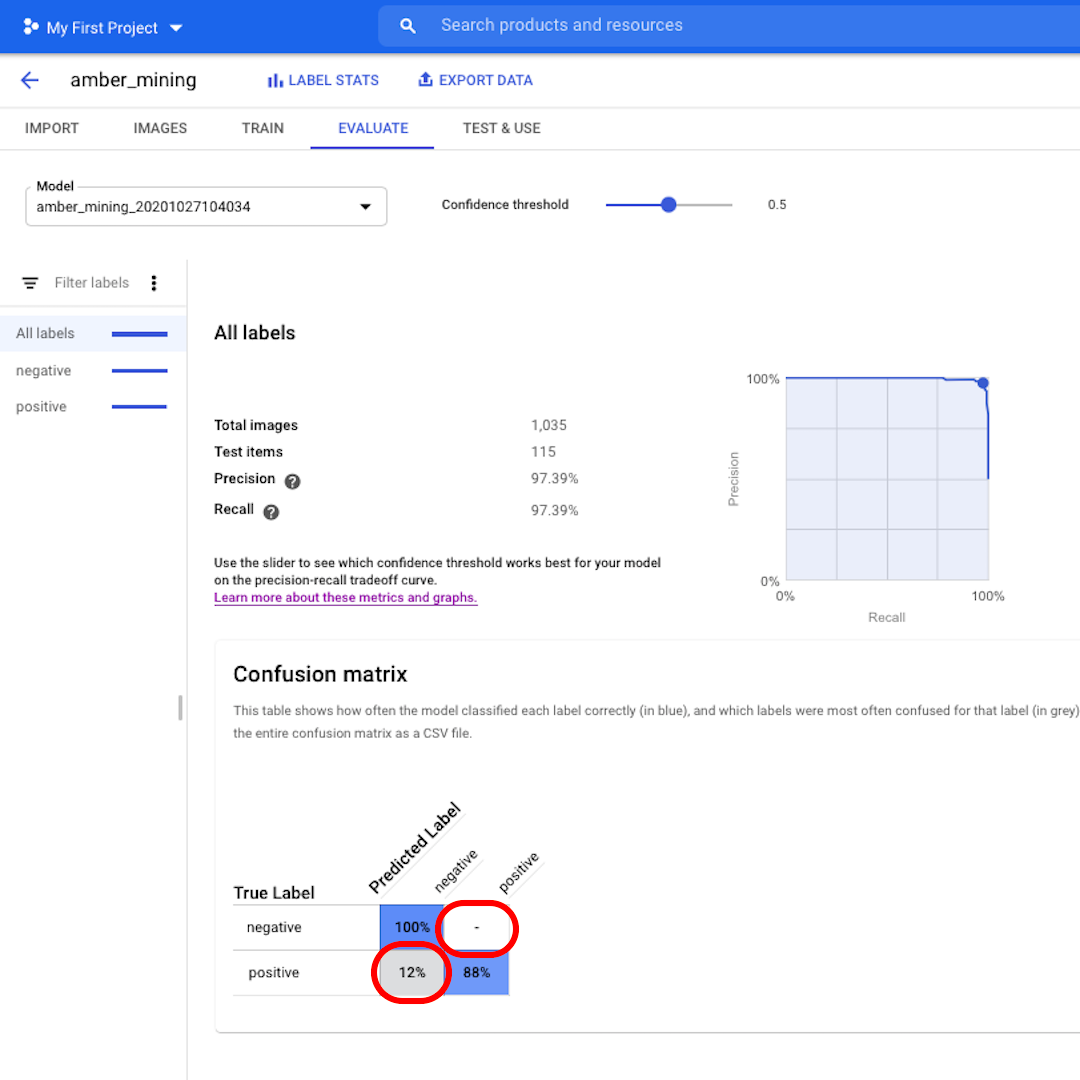

Nel nostro caso, tutte le immagini che avrebbero dovuto essere etichettate come negative (nessuna estrazione di ambra) sono state riconosciute dal modello e l'82% delle immagini che includevano tracce di estrazione di ambra sono state correttamente etichettate come tali.

Potremmo non avere falsi positivi. Nel nostro caso nessuna immagine è stata erroneamente etichettata come esempio di estrazione dell'ambra e solo il 12% riguarda invece falsi negativi: immagini che mostrano tracce di estrazione dell'ambra che il modello non è riuscito a riconoscere.

Ciò è positivo ai fini della nostra indagine sull'estrazione illegale di ambra: è meglio perdere alcuni esempi positivi piuttosto che portare come prova immagini di estrazione dell'ambra che in realtà non lo dimostrano.

Clicca sui filtri di sinistra se desideri vedere quali immagini di prova sono state classificate correttamente o erroneamente dal modello.

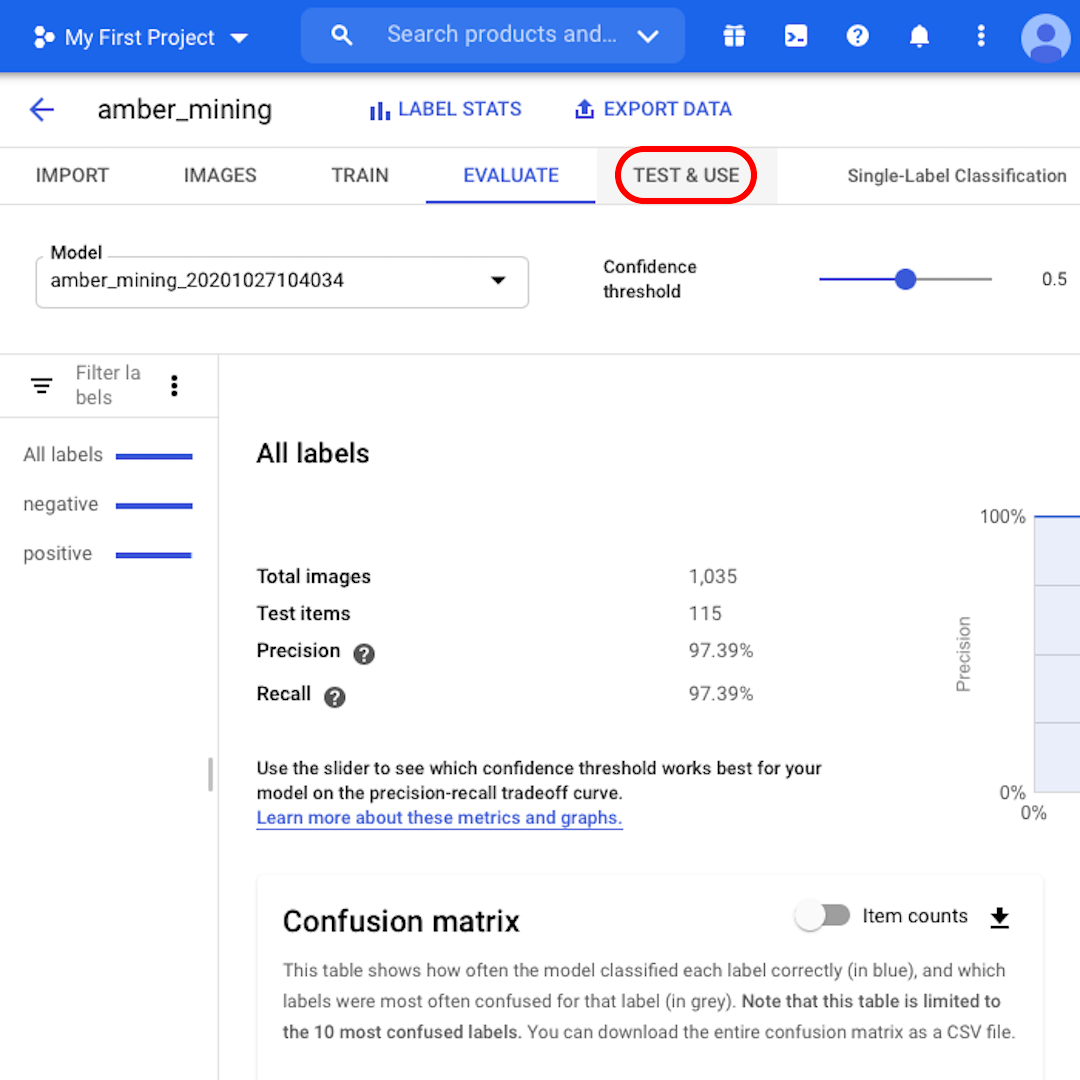

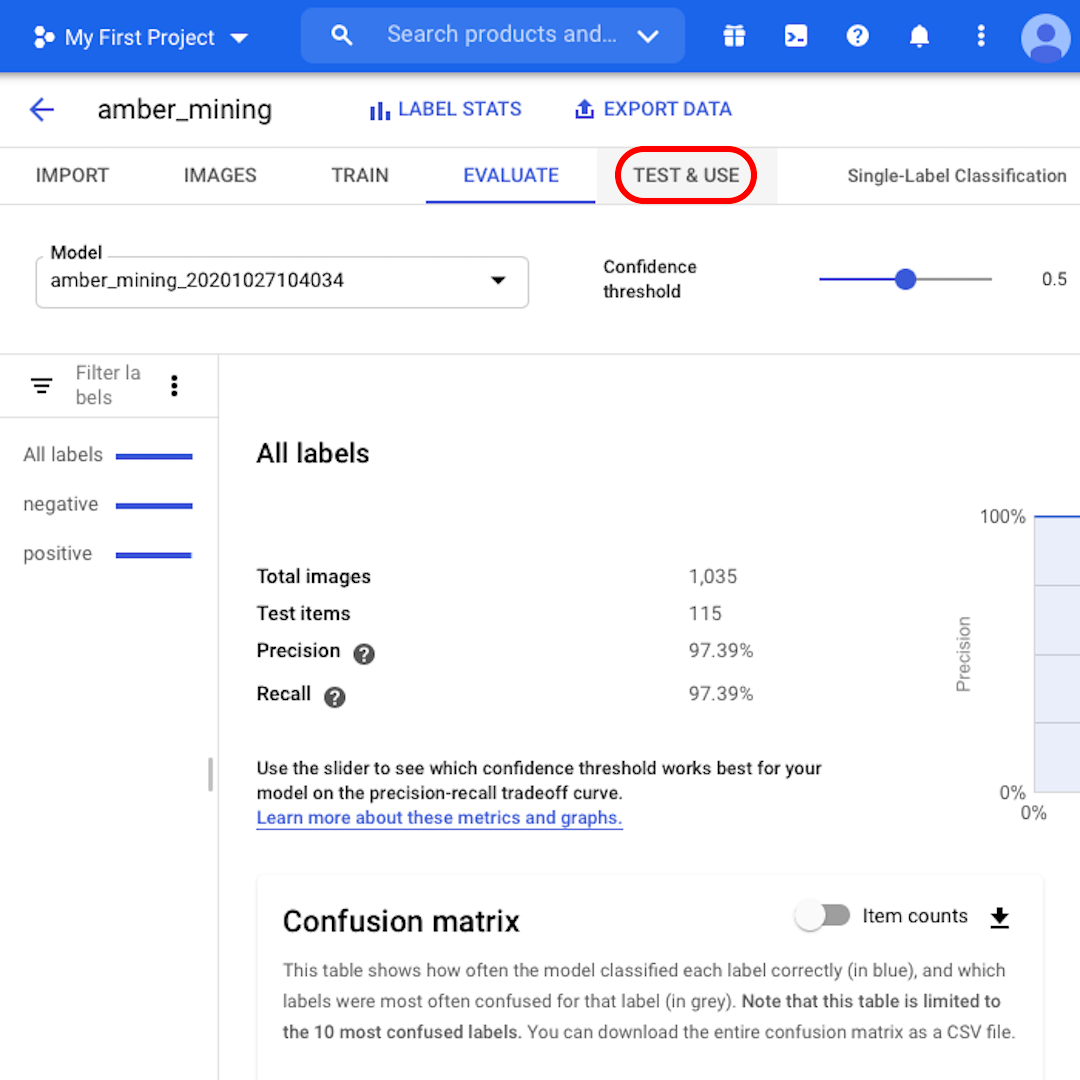

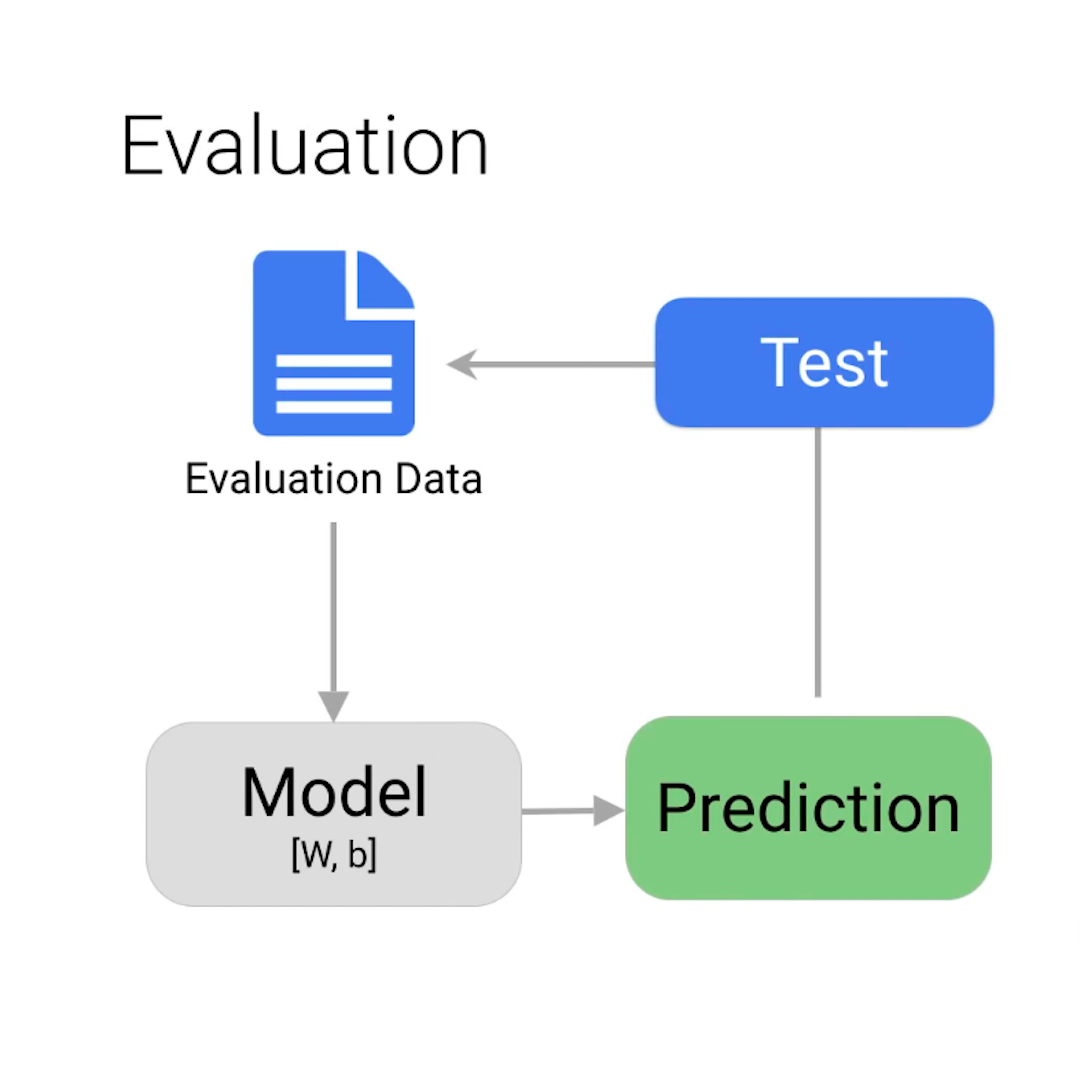

Non sei ancora sicuro di poterti fidare del modello? Cliccando su "Test & Use", puoi caricare nuove immagini satellitari, con o senza tracce di estrazione dell'ambra, per vedere se il modello le etichetta correttamente.

Prova e addestra nuovamente

Alcune considerazioni finali prima della conclusione:

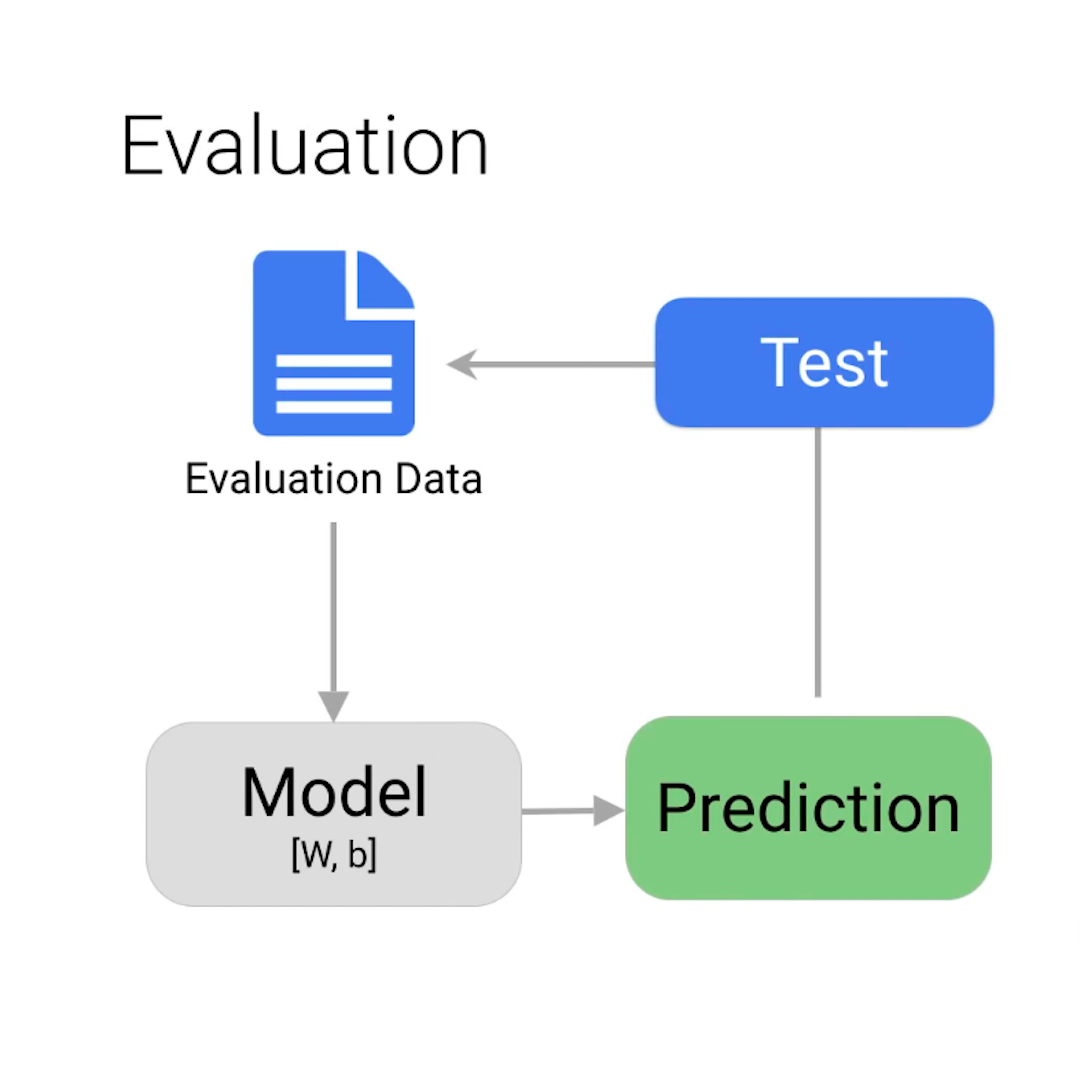

Forse ti starai chiedendo come mai il modello abbia commesso degli errori, dando delle risposte sbagliate, quando gli avevamo fornito già dall'inizio tutte le risposte giuste. Se hai dubbi, potresti voler rivedere il passaggio sula suddivisione dei dataset in seti di addestramento, convalida e test descritti nella lezione precedente.

Per questo esempio, quasi tutte le immagini sono state classificate correttamente. Ma non sarà sempre così. Se non sei soddisfatto delle prestazioni del tuo modello, puoi sempre aggiornare e migliorare il tuo dataset e addestrare nuovamente il modello. È possibile analizzare attentamente cosa è andato storto nella prima iterazione e, ad esempio, aggiungere al set di addestramento più immagini simili a quelle classificate erroneamente dal modello.

Come per gli esseri umani, l'apprendimento è un processo iterativo.

-

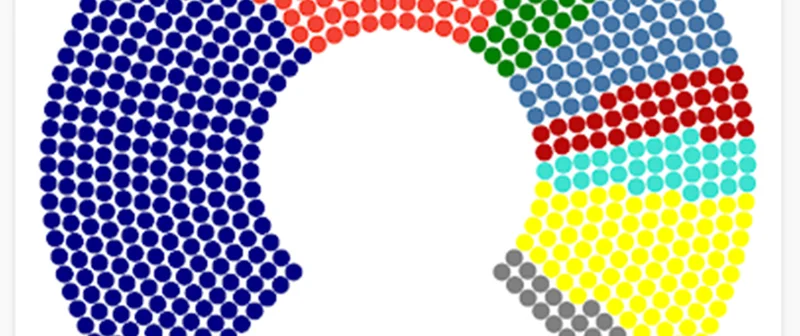

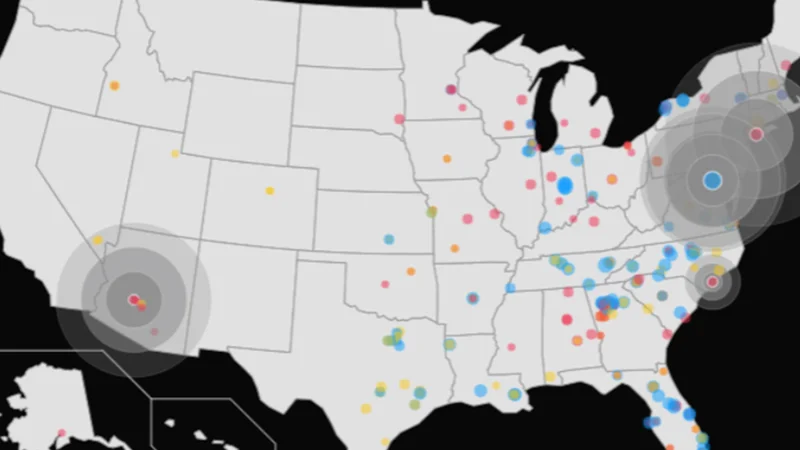

Visualizzazione delle elezioni

LezioneUn'idea concreta delle elezioni grazie a visualizzazioni interattive -

Storytelling con Google Trends

LezioneApprendi come contestualizzare i dati di Google Trends e integrarli nel tuo articolo. -

Mantieni alto il coinvolgimento dei visitatori usando i Segnali web essenziali

LezioneCrea un'esperienza utente di qualità sul tuo sito di notizie