Voreingenommenheit beim maschinellen Lernen

Verstehen, was eine ML-Voreingenommenheit ist und wie man sie vermeiden kann.

Fairness beim maschinellen Lernen

Bisher hat dieser Kurs gezeigt, wie maschinelles Lernen Ihre Arbeit verbessern kann - von der Einsparung wertvoller Zeit bei bestehenden Aufgaben bis hin zur Eröffnung neuer Möglichkeiten. ML kann eine Menge für Sie tun, aber es bringt Herausforderungen mit sich, die Sie nicht übersehen sollten.

Um sich diesen Herausforderungen zu stellen, konzentriert sich eine wachsende Zahl von Forschern und Praktikern auf das Thema „Fairness“ beim maschinellen Lernen. Das Leitprinzip dabei ist, dass ML allen gleichermaßen zugute kommen soll, unabhängig von den gesellschaftlichen Kategorien, die unser Leben strukturieren und beeinflussen.

Was ist Voreingenommenheit?

Was sind die negativen Folgen, die sich aus dem Einsatz von maschinellem Lernen ergeben könnten? Die kurze Antwort lautet: Voreingenommenheit.

Als Menschen haben wir alle unsere Vorurteile. Sie sind Tools, die unser Gehirn benutzt, um mit den Informationen umzugehen, mit denen es täglich beworfen wird.

Nehmen Sie dieses Beispiel: Schließen Sie Ihre Augen und stellen Sie sich einen Schuh vor. Höchstwahrscheinlich haben Sie sich einen Turnschuh vorgestellt. Vielleicht ein Herrenschuh aus Leder. Es ist weniger wahrscheinlich, dass Sie an einen hochhackigen Damenschuh gedacht haben. Wir wissen vielleicht nicht einmal warum, aber jeder von uns ist einem Schuh gegenüber den anderen voreingenommen.

Nun stellen Sie sich vor, Sie wollen einem Computer beibringen, einen Schuh zu erkennen. Am Ende könnten Sie ihn Ihrer eigenen Voreingenommenheit aussetzen. So entsteht die Voreingenommenheit beim maschinellen Lernen. Selbst mit guten Absichten ist es unmöglich, uns von unseren eigenen Vorurteilen zu trennen.

Drei Arten der Voreingenommenheit

Es gibt verschiedene Möglichkeiten, wie unsere eigenen Vorurteile Gefahr laufen, Teil der von uns geschaffenen Technologie zu werden:

Voreingenommenheit bei der Interaktion

Nehmen wir das Beispiel von vorhin: Wenn wir ein Modell darauf trainieren, Schuhe mit einem Datensatz zu erkennen, der hauptsächlich Bilder von Turnschuhen enthält, wird das System nicht lernen, hohe Absätze als Schuhe zu erkennen.

Latente Voreingenommenheit

Wenn Sie ein ML-System anhand von Bildern berühmter Wissenschaftler aus der Vergangenheit darauf trainieren, wie ein Wissenschaftler aussieht, wird Ihr Algorithmus wahrscheinlich lernen, Wissenschaftler nur mit Männern in Verbindung zu bringen.

Voreingenommenheit bei der Auswahl

Angenommen, Sie trainieren ein Modell, Gesichter zu erkennen. Wenn die Daten, mit denen Sie es trainieren, eine Population überrepräsentieren, wird es für diese auf Kosten der anderen besser funktionieren, mit potenziell rassistischen Folgen.

Was können wir also tun, um diese Voreingenommenheit zu vermeiden?

Die richtigen Fragen stellen, um Voreingenommenheit zu vermeiden

Als Journalist ist eine erste Abwehrmaßnahme gegen Voreingenommenheit durchaus möglich: Dieselben Werte und ethischen Grundsätze, die Sie täglich in Ihrem Beruf anwenden, sollten auch auf die Bewertung der Fairness jeder neuen Technologie, die Ihrer Toolbox hinzugefügt wird, Anwendung finden. Das maschinelle Lernen bildet da keine Ausnahme.

Darüber hinaus sollten Sie in jedem Fall damit beginnen, zu überlegen, ob die Folgen sich negativ auf die wirtschaftlichen oder anderen wichtigen Lebenschancen des Einzelnen auswirken könnten. Dies ist besonders kritisch, wenn die von Ihnen verwendeten Daten sensible persönliche Informationen enthalten.

Oft sind die unfairen Auswirkungen nicht sofort offensichtlich, sondern erfordern es, nuancierte soziale, politische und ethische Fragen darüber zu stellen, wie sich in Ihr maschinelles Lernsystem eine Voreingenommenheit einschleichen könnte.

Berücksichtigung der Hauptquellen der Voreingenommenheit

Obwohl keine Trainingsdaten jemals vollkommen „unvoreingenommen“ sein werden, können Sie Ihre Chancen, ein faires Modell zu erstellen, erheblich verbessern, wenn Sie mögliche Quellen der Voreingenommenheit in Ihren Daten sorgfältig prüfen und Schritte unternehmen, um diese zu beseitigen.

Der häufigste Grund für eine sich einschleichende Voreingenommenheit ist, wenn Ihre Trainingsdaten nicht wirklich repräsentativ für die Bevölkerung sind, für die Ihr Modell Vorhersagen macht. Sie müssen sicherstellen, dass Sie genügend Daten für jede relevante Gruppe haben.

Eine andere Art der Voreingenommenheit zeigt sich, wenn einige Gruppen in den Trainingsdaten weniger positiv als andere vertreten sind. Sie sollten in Betracht ziehen, Ihre Daten zu überprüfen, bevor Sie sie zum Trainieren eines Modells verwenden, um zu überprüfen, ob sie irgendwelche Voreingenommenheiten beinhalten, die durch den Algorithmus erlernt und reproduziert werden könnten.

Voreingenommenheiten verhindern: Es beginnt mit dem Bewusstsein

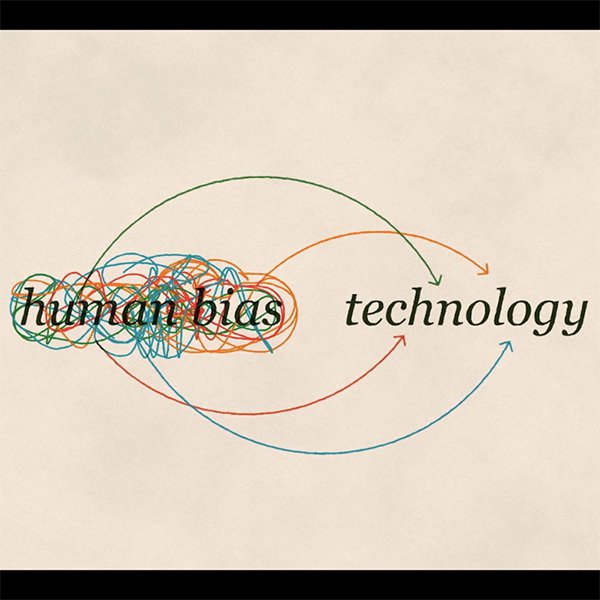

Voreingenommenheit kann auf viele Arten entstehen: von Trainingsdatensätzen, aufgrund von Entscheidungen, die während der Entwicklung eines maschinellen Lernsystems getroffen werden, und durch komplexe Rückkopplungsschleifen, die beim Einsatz eines ML-Systems in der realen Welt entstehen.

Einige konkrete Fragen, die Sie vielleicht stellen möchten, um mögliche Voreingenommenheit zu erkennen, sind:

- Zu welchem Zweck wurden die Daten gesammelt?

- Wie wurden die Daten gesammelt?

- Was ist das Ziel der Verwendung dieses Datensatzes und dieses speziellen Algorithmus?

- Wie wurde die Datenquelle bewertet?

- Wie wurde der Prozess der Datenanalyse vor der eigentlichen Analyse definiert?

Voreingenommenheit ist ein komplexes Thema, und es gibt keine Patentlösung. Die Lösung beginnt mit dem Bewusstsein und damit, dass wir alle uns der Risiken bewusst sind und die richtigen Schritte unternehmen, um sie zu minimieren.

-

Looking ahead to ML-powered journalism

LektionKey learnings and recommended resources to deepen your ML knowledge. -

Berechtigungen: Google-Daten als Quelle

LektionLernen Sie, wie Sie die Google-Produkte rechtmäßig nutzen und zitieren. -

Access Google Finance data in Sheets

LektionAccess Google Finance data in Google Sheets. Examine closing prices, percentage change or market movement over any timeframe.